赶超 GPT-4o,最强大模型 Llama 3.1 405B 一夜封神,扎克伯格:开源引领新时代

赶超 GPT-4o,最强大模型 Llama 3.1 405B 一夜封神,扎克伯格:开源引领新时代就在刚刚,Meta 如期发布了 Llama 3.1 模型。

就在刚刚,Meta 如期发布了 Llama 3.1 模型。

Llama 3.1 终于现身了,不过出处却不是 Meta 官方。

Llama 3.1又被提前泄露了!开发者社区再次陷入狂欢:最大模型是405B,8B和70B模型也同时升级,模型大小约820GB。基准测试结果惊人,磁力链全网疯转。

苹果最新杀入开源大模型战场,而且比其他公司更开放。 推出7B模型,不仅效果与Llama 3 8B相当,而且一次性开源了全部训练过程和资源。大模型,AI,苹果AI,苹果开源模型

Scaling Law还没走到尽头,「小模型」逐渐成为科技巨头们的追赶趋势。Meta最近发布的MobileLLM系列,规模甚至降低到了1B以下,两个版本分别只有125M和350M参数,但却实现了比更大规模模型更优的性能。

最高端的大模型,往往需要最朴实的语言破解。来自EPFL机构研究人员发现,仅将一句有害请求,改写成过去时态,包括GPT-4o、Llama 3等大模型纷纷沦陷了。

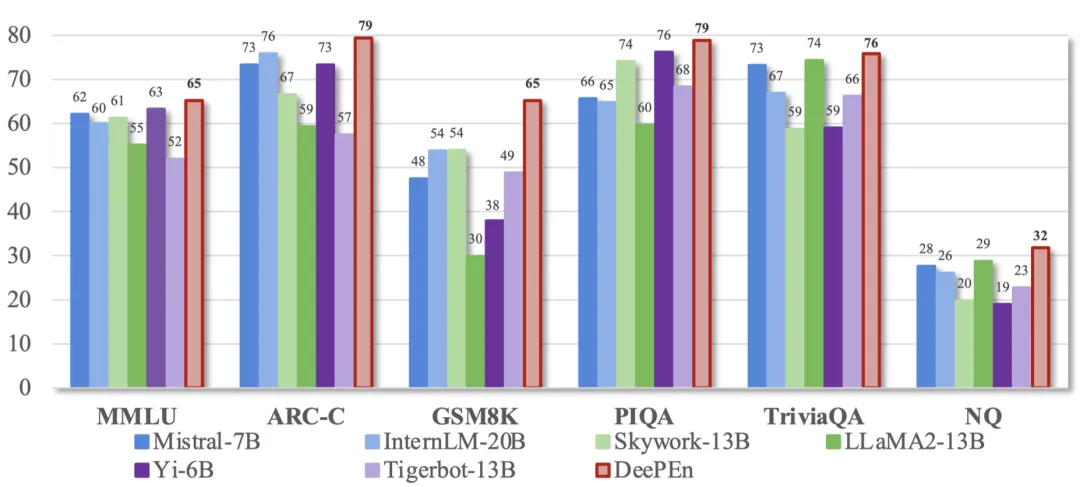

GPT-4o mini头把交椅还未坐热,Mistral AI联手英伟达发布12B参数小模型Mistral Nemo,性能赶超Gemma 2 9B和Llama 3 8B。

AI经过多轮“自我提升”,能力不增反降?

随着大语言模型展现出惊人的语言智能,各大 AI 公司纷纷推出自己的大模型。这些大模型通常在不同领域和任务上各有所长,如何将它们集成起来以挖掘其互补潜力,成为了 AI 研究的前沿课题。

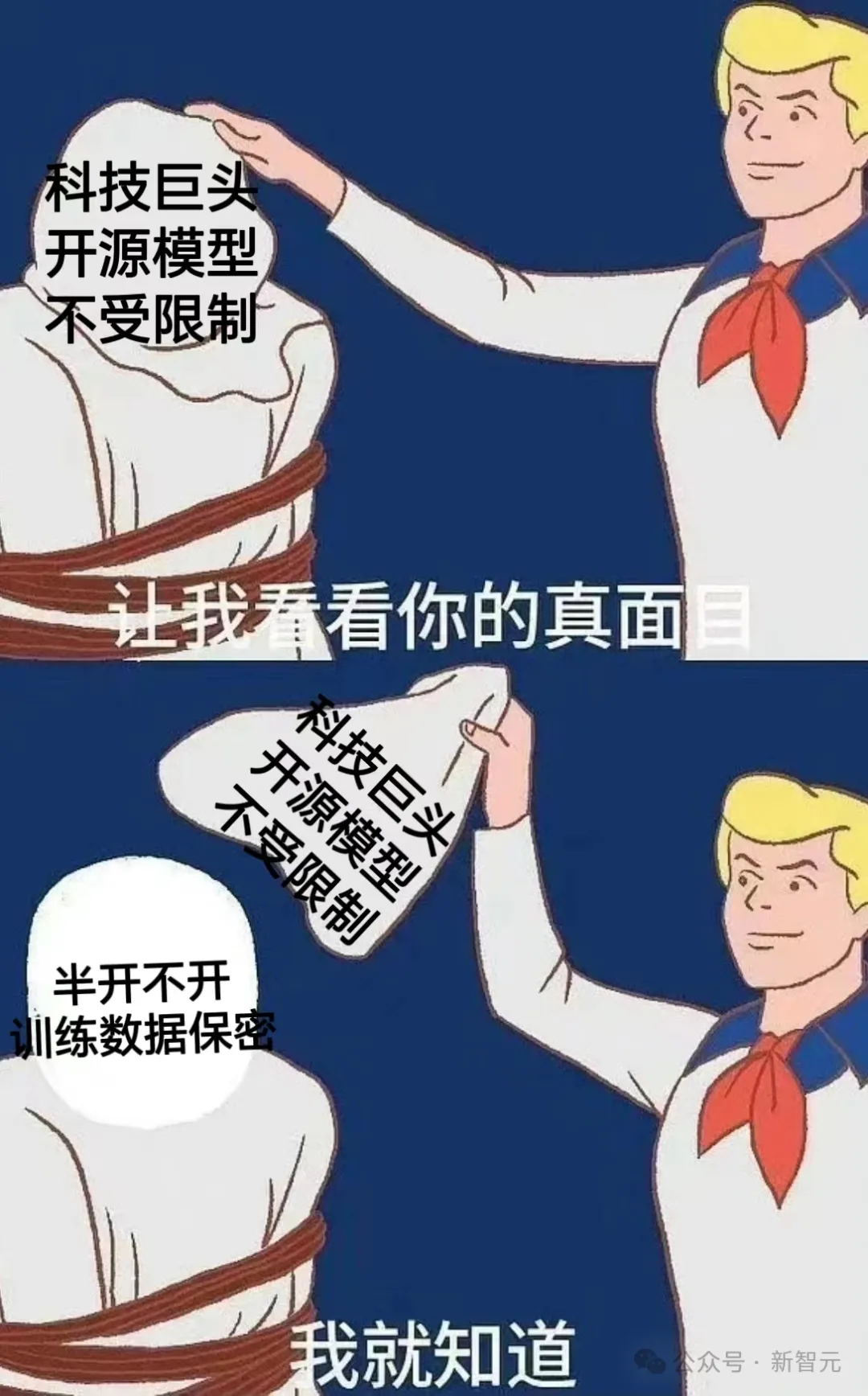

大模型开源的热潮下,隐藏着诸多问题,从定义的模糊到实际开放内容的局限性,Lecun再陷Meta大模型是否真开源的质疑风波只是冰山一角。