又一个Genie 3来了!刚上线挤爆服务器,Mirage 2把世界模型玩成在线游戏

又一个Genie 3来了!刚上线挤爆服务器,Mirage 2把世界模型玩成在线游戏全球首款AI原生UGC游戏引擎迎来2.0版本。Mirage 2是一款可在线游玩的实时通用领域生成式世界引擎,能将任何图像(照片、绘画、涂鸦等)转化为可实时互动的3D世界。

来自主题: AI资讯

8848 点击 2025-08-23 13:38

全球首款AI原生UGC游戏引擎迎来2.0版本。Mirage 2是一款可在线游玩的实时通用领域生成式世界引擎,能将任何图像(照片、绘画、涂鸦等)转化为可实时互动的3D世界。

作为开放世界游戏的标杆,GTA 系列不仅在游戏圈声名赫赫。尤其是在 AI 驱动的视频生成、三维生成或是世界模型等领域里,研究者们不仅采用游戏内场景为训练数据,更将生成类 GTA 的完整世界作为长久以来的目标。

世界首个实时AI扩散视频模型炸场,Karpathy亲自站台,颠覆AI视频交互,0延迟+无限时长,每秒24帧不卡顿,MirageLSD首次实现AI直播级生成。

谁曾想,AI竟能实时生成GTA级大作。刚刚,谷歌、英伟达等机构联手,震撼发布全球首款AI原生UGC游戏引擎——Mirage,没有预设关卡,一句话即生游戏,超长十分钟沉浸式体验

在 AI 领域,英伟达开发的 CUDA 是驱动大语言模型(LLM)训练和推理的核心计算引擎。

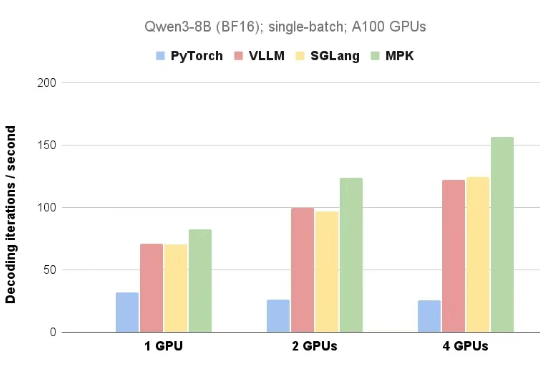

近日,来自 CMU 的 Catalyst Group 团队发布了一款 PyTorch 算子编译器 Mirage,用户无需编写任何 CUDA 和 Triton 代码就可以自动生成 GPU 内核,并取得更佳的性能。