Mistral发布了全世界最好的OCR,希望不是吹牛

Mistral发布了全世界最好的OCR,希望不是吹牛今天,他们自称发布了世界上最好的 OCR API,它能够将复杂的 PDF 文件转换为文本文件,以便 AI 模型处理。现在,所有大模型的输入端格式都是文本,或者规整的、容易识别的文本文件,但这个世界上,还有很多文件是粗糙的,不规整的,难以识别的,它需要依赖强大的 OCR 功能才能转换为文本。

今天,他们自称发布了世界上最好的 OCR API,它能够将复杂的 PDF 文件转换为文本文件,以便 AI 模型处理。现在,所有大模型的输入端格式都是文本,或者规整的、容易识别的文本文件,但这个世界上,还有很多文件是粗糙的,不规整的,难以识别的,它需要依赖强大的 OCR 功能才能转换为文本。

史上首次,Mistral AI的超级助手Le Chat登顶法国免费APP榜首!开发者们激动表示,谢谢Mistral AI,欧洲终于在AI竞赛中有了一席之地。马克龙也宣布,法国将投资1090亿欧元建设欧洲版「星际之门」。

欧洲OpenAI”Mistral AI有新动作了! Le Chat(法语“猫”)全新升级,官方自称它是“您生活和工作的终极AI助手”。

据外电报道,就在谷歌与美联社签署协议的第二天,Mistral 还宣布与法新社 (AFP) 达成内容协议,以提高Mistral 聊天机器人产品Le Chat的答案的准确性。对于这家总部位于巴黎的人工智能公司来说,这是第一笔此类交易。这表明 Mistral 不想被视为仅仅一家基础模型制造商。

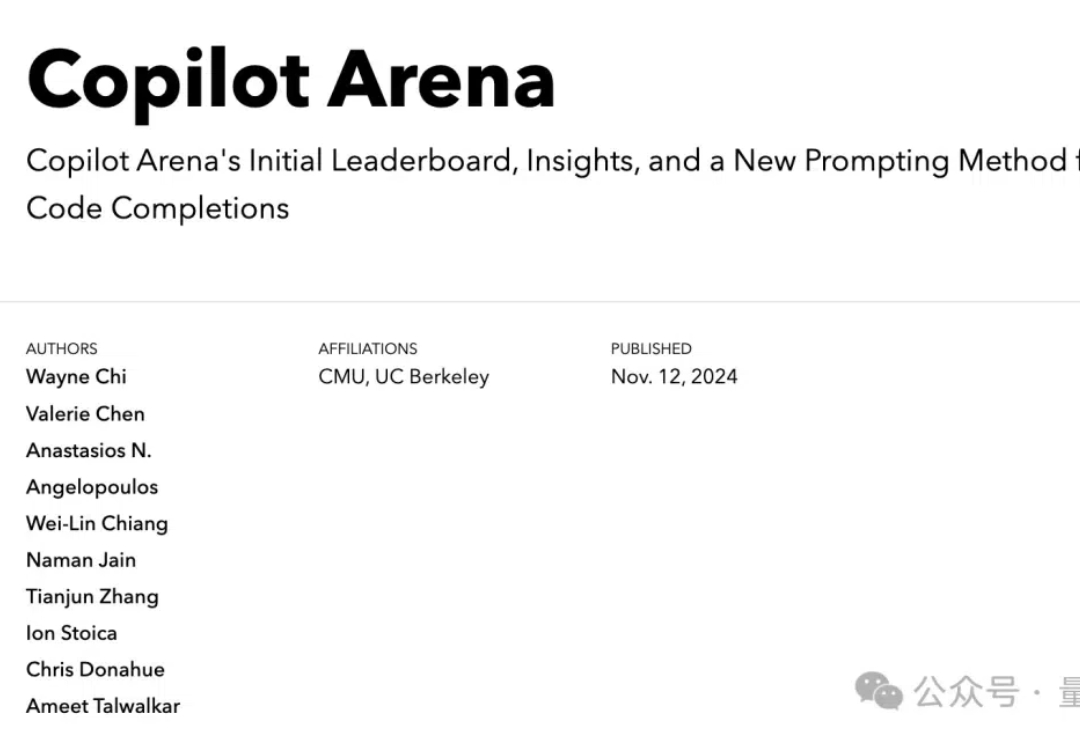

“欧洲版 OpenAI” Mistral 的代码模型 CodeStral,又上新了! 而且与 DeepSeek V2.5 和 Claude 3.5 平起平坐,共同位列 Copilot 竞技场第一名。

你是否想过在自己的设备上运行自己的大型语言模型(LLMs)或视觉语言模型(VLMs)?你可能有过这样的想法,但是一想到要从头开始设置、管理环境、下载正确的模型权重,以及你的设备是否能处理这些模型的不确定性,你可能就犹豫了。

欧洲的OpenAI,把ChatGPT功能都复制了。 Mistral AI大模型平台Le Chat新增Canvas、联网搜索、上传PDF等ChatGPT同款功能,而且全都免!费!

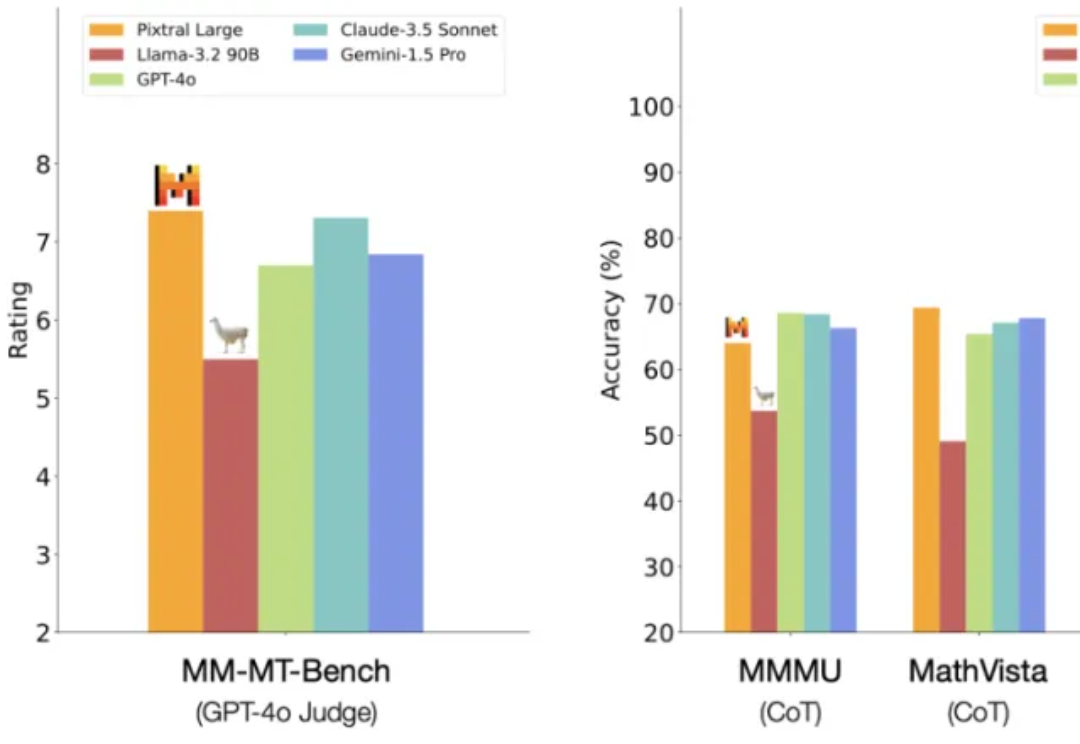

一觉醒来,Mistral AI 又发力了。 就在今天,Mistral AI 多模态家族迎来了第二位成员:一个名为 Pixtral Large 的超大杯基础模型。

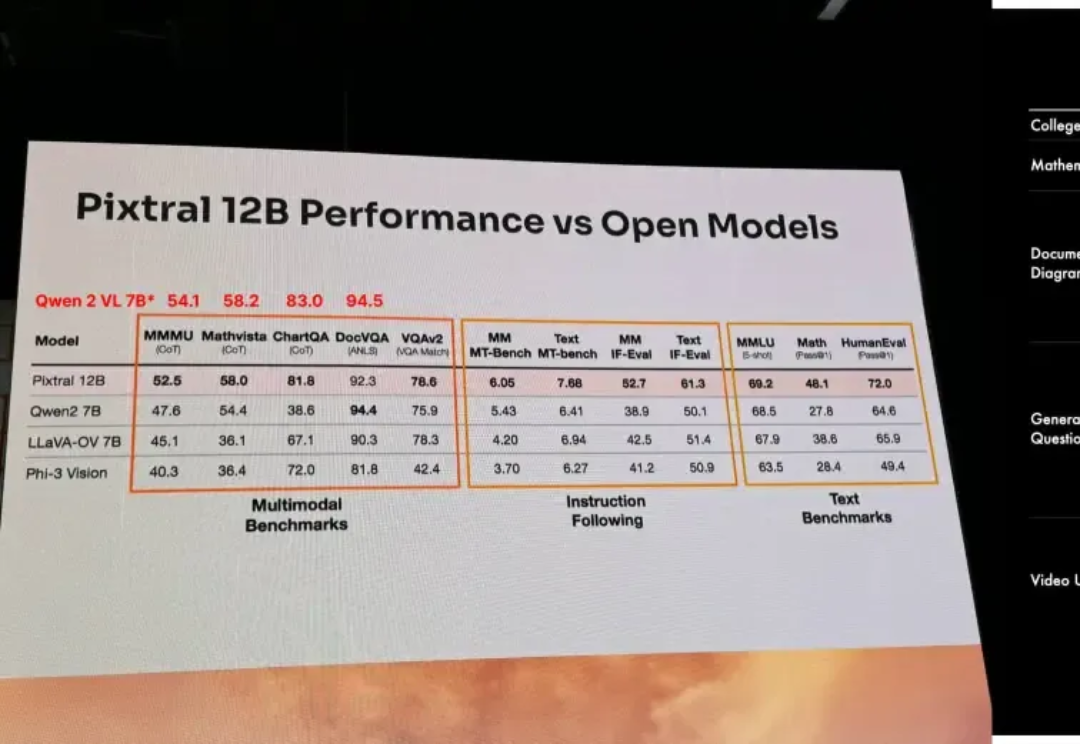

以开源极客之姿杀入江湖的Mistral AI,在9月份甩出了自家的首款多模态大模型Pixtral 12B,如今,报告之期已至,技术细节全公开。

Mistral 7B诞生一周年之际,法国AI初创公司Mistral再次连发两个轻量级模型Ministral 3B和Ministral 8B,性能赶超Llama 3 8B。