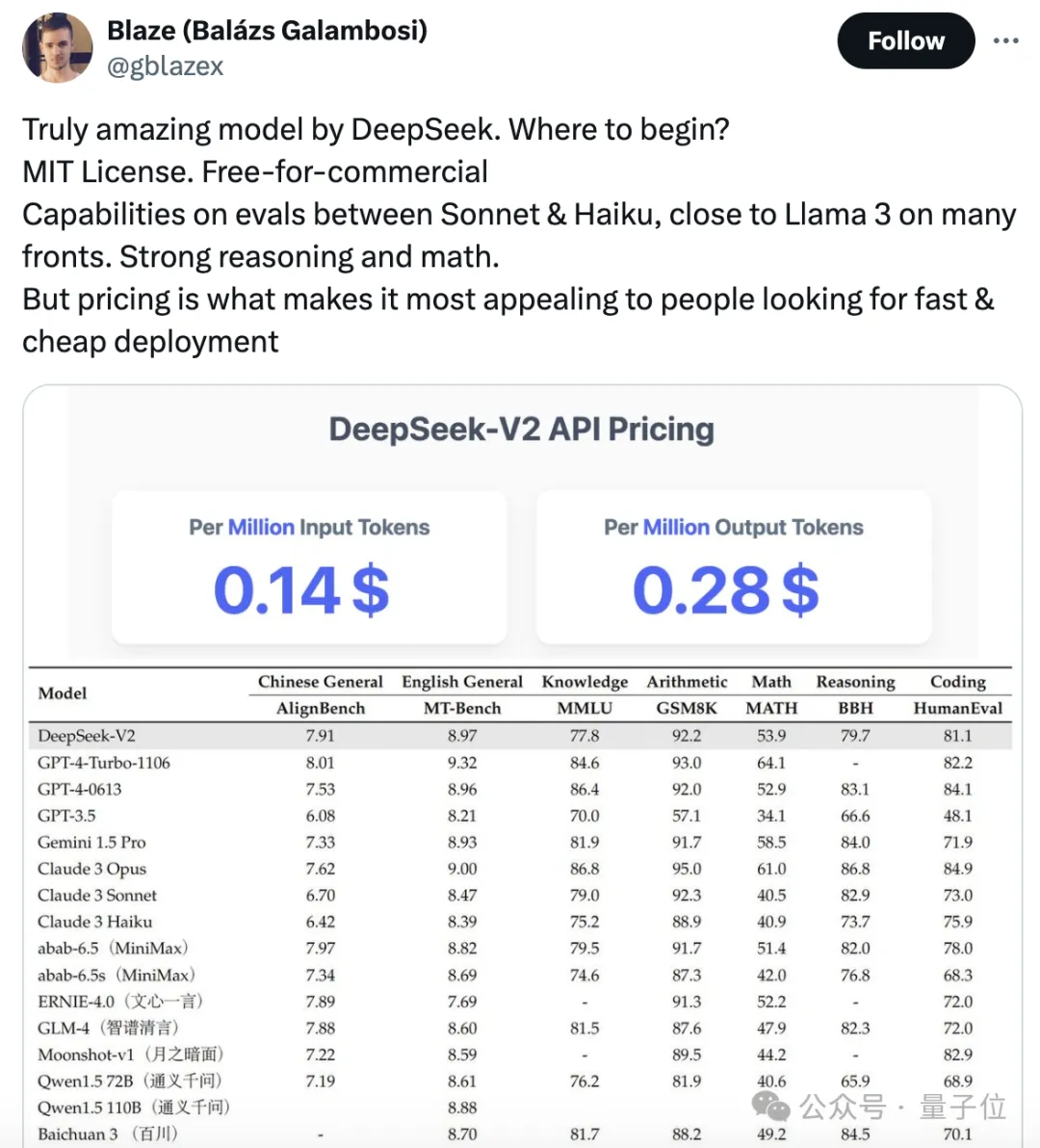

一块钱100万token,超强MoE模型开源,性能直逼GPT-4-Turbo

一块钱100万token,超强MoE模型开源,性能直逼GPT-4-Turbo开源大模型领域,又迎来一位强有力的竞争者。

开源大模型领域,又迎来一位强有力的竞争者。

最新国产开源MoE大模型,刚刚亮相就火了。

君不见,估值超 25 亿美元一举荣升独角兽。 君不见,闭门研发万亿 MoE 模型 abab 6.5. 君不见,低调上线海螺 AI 功能齐全好用到爆。

在 4 月 27 日召开的中关村论坛通用人工智能平行论坛上,人大系初创公司智子引擎隆重发布全新的多模态大模型 Awaker 1.0。

在4月27日召开的中关村论坛通用人工智能平行论坛上,人大系初创公司智子引擎隆重发布全新的多模态大模型Awaker 1.0,向AGI迈出至关重要的一步。

就在刚刚,拥有128位专家和4800亿参数的Arctic,成功登上了迄今最大开源MoE模型的宝座。

Snowflake 发布高「企业智能」模型 Arctic,专注于企业内部应用。

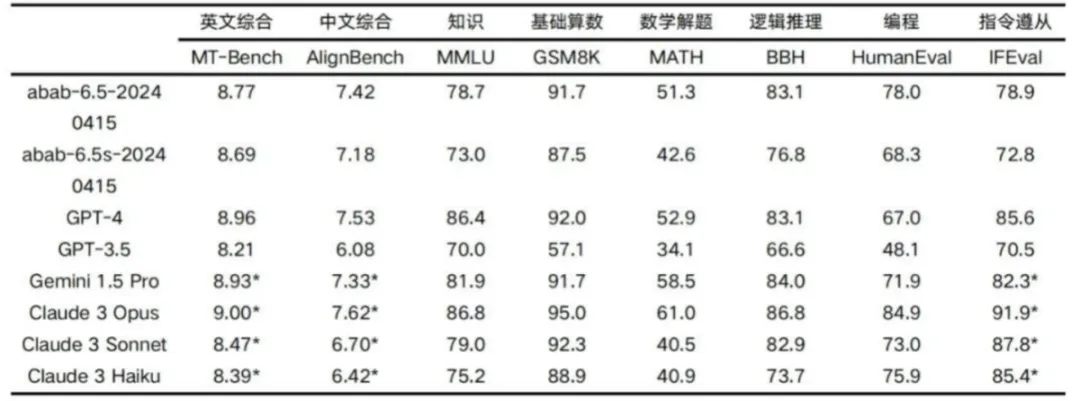

继 1 月推出国内首个基于 MoE 架构的千亿参数量大语言模型 abab6 后,上周,通用人工智能创业公司、中国估值最高的大模型公司之一 MiniMax 推出了万亿 MoE 模型 abab 6.5。根据 MiniMax 发布的技术报告,在各类核心能力测试中,abab 6.5接近 GPT-4、 Claude 3 Opus 、Gemini 1.5 Pro 等世界领先的大语言模型。

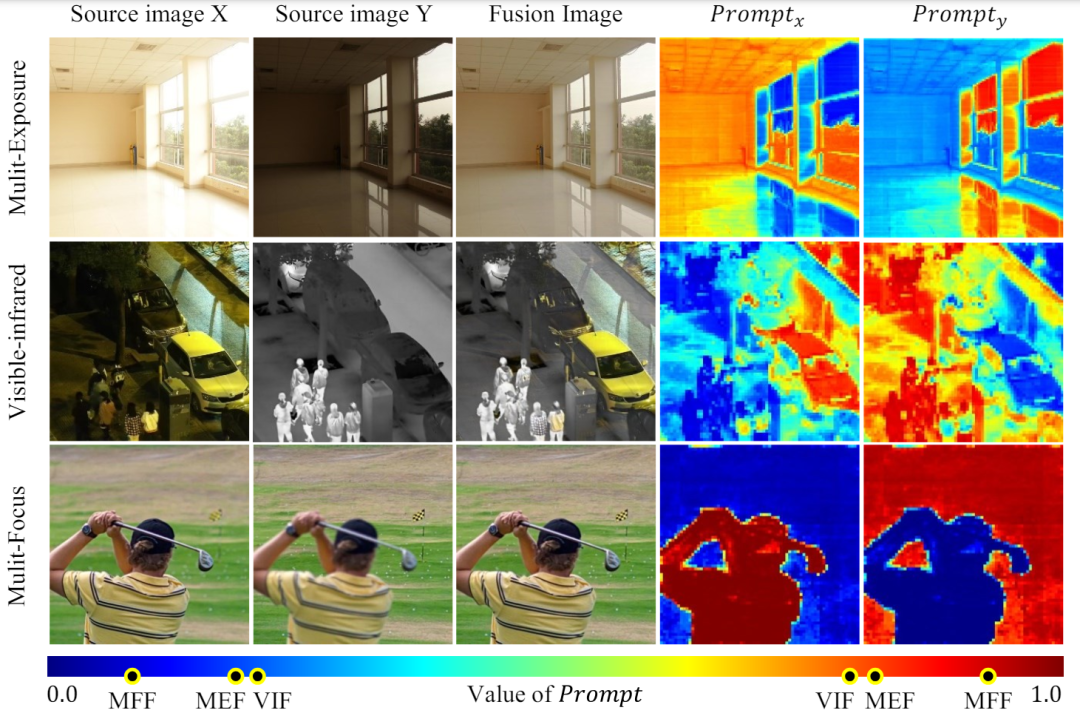

图像融合的目的是将同一场景中不同传感器捕获的多源图像的互补信息整合到单个图像上。这种方式通常被用于提取图片重要信息和提高视觉质量。

多任务机器人学习在应对多样化和复杂情景方面具有重要意义。然而,当前的方法受到性能问题和收集训练数据集的困难的限制