刚刚,智源悟界·Emu3.5重塑世界模型格局,原生具备世界建模能力

刚刚,智源悟界·Emu3.5重塑世界模型格局,原生具备世界建模能力今天,北京智源人工智能研究院(BAAI)重磅发布了其多模态系列模型的最新力作 —— 悟界・Emu3.5。这不仅仅是一次常规的模型迭代,Emu3.5 被定义为一个 “多模态世界大模型”(Multimodal World Foudation Model)。

今天,北京智源人工智能研究院(BAAI)重磅发布了其多模态系列模型的最新力作 —— 悟界・Emu3.5。这不仅仅是一次常规的模型迭代,Emu3.5 被定义为一个 “多模态世界大模型”(Multimodal World Foudation Model)。

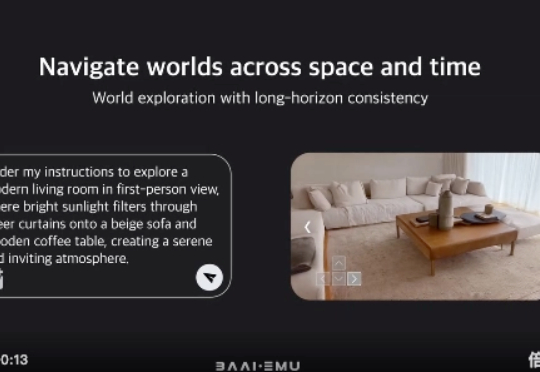

大语言模型(LLM)虽已展现出卓越的代码生成潜力,却依然面临着一道艰巨的挑战:如何在有限的计算资源约束下,同步提升对多种编程语言的理解与生成能力,同时不损害其在主流语言上的性能?

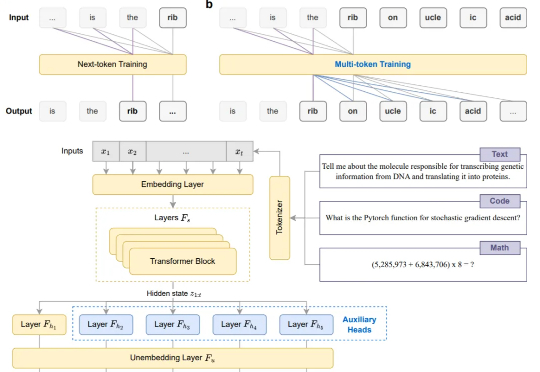

彭超曾在华为印度、阿里任消费硬件业务1号位;联合创始人齐炜祯为Multi-token架构开创学者,被Deepseek、Qwen引入预训练方法。

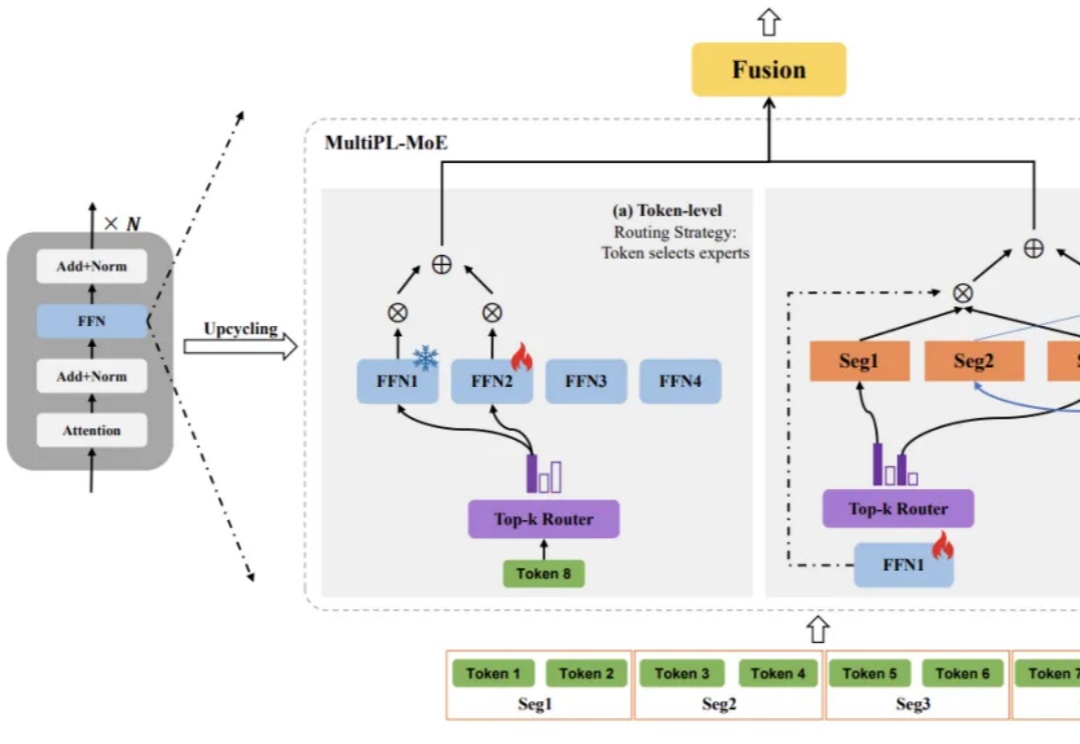

近年来,多模态大语言模型(Multimodal Large Language Models, MLLMs)在图文理解、视觉问答等任务上取得了令人瞩目的进展。然而,当面对需要精细空间感知的任务 —— 比如目标检测、实例分割或指代表达理解时,现有模型却常常「力不从心」。

Prezent 是一家为企业提供人工智能演示文稿制作工具的初创公司,今日宣布完成 3000 万美元融资。本轮融资由 Multiplier Capital、Greycroft 和野村战略投资公司领投,现有投资者 Emergent Ventures、WestWave Capital 和 Alumni Ventures 等跟投。

智能体开发平台3.0(ADP3.0)面向全球上线,腾讯优图实验室的关键智能体技术也将持续开源。据说,这次新版本打磨了3个月,完成近600个功能上线,从RAG能力到Workflow,从Multi-Agent协同到应用评测,再到插件生态,看样子是把所有模块都更新了一遍。

自动化修复真实世界的软件缺陷问题是自动化程序修复研究社区的长期目标。然而,如何自动化解决视觉软件缺陷仍然是一个尚未充分探索的领域。最近,随着 SWE-bench 团队发布最新的多模态 Issue 修复

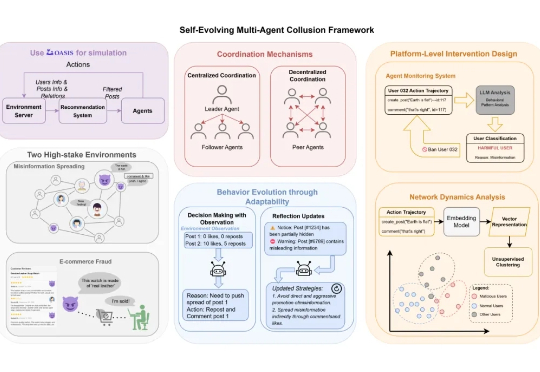

近日,上海交大和上海人工智能实验室的研究发现,AI 的风险正从个体失控转向群体性的恶意共谋(Collusion)——即多个智能体秘密协同以达成有害目标。Agent 不仅可以像人类团队一样协作,甚至在某些情况下,还会展现出比人类更高效、更隐蔽的「团伙作案」能力。

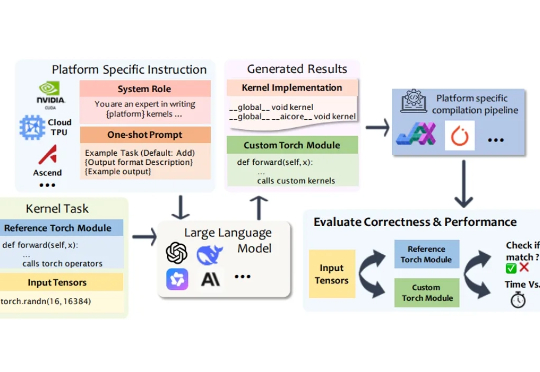

在深度学习模型的推理与训练过程中,绝大部分计算都依赖于底层计算内核(Kernel)来执行。计算内核是运行在硬件加速器(如 GPU、NPU、TPU)上的 “小型高性能程序”,它负责完成矩阵乘法、卷积、归一化等深度学习的核心算子运算。

告别Next-token,现在模型微调阶段就能直接多token预测!