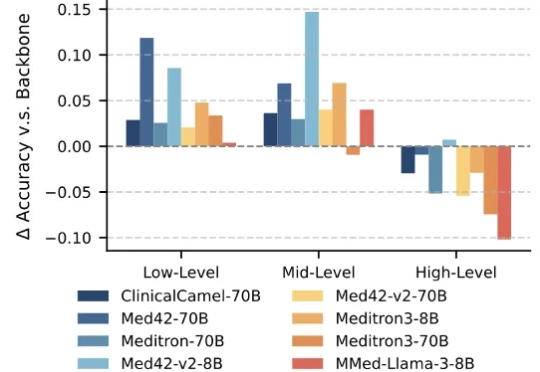

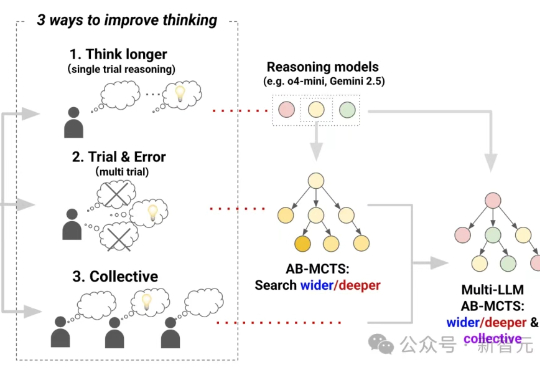

ICML2025|清华医工平台提出大模型「全周期」医学能力评测框架MultiCogEval

ICML2025|清华医工平台提出大模型「全周期」医学能力评测框架MultiCogEval大语言模型(Large Language Models,LLMs)技术的迅猛发展,正在深刻重塑医疗行业。医疗领域正成为这一前沿技术的 “新战场” 之一。大模型具备强大的文本理解与生成能力,能够快速读取医学文献、解读病历记录,甚至基于患者表述生成初步诊断建议,有效辅助医生提升诊断的准确性与效率。

大语言模型(Large Language Models,LLMs)技术的迅猛发展,正在深刻重塑医疗行业。医疗领域正成为这一前沿技术的 “新战场” 之一。大模型具备强大的文本理解与生成能力,能够快速读取医学文献、解读病历记录,甚至基于患者表述生成初步诊断建议,有效辅助医生提升诊断的准确性与效率。

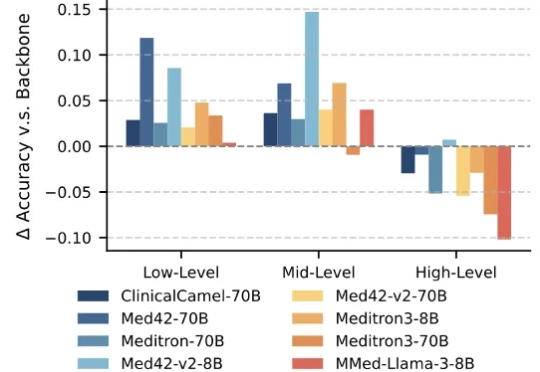

本文主要介绍 xML 团队的论文:Discrete Diffusion in Large Language and Multimodal Models: A Survey。

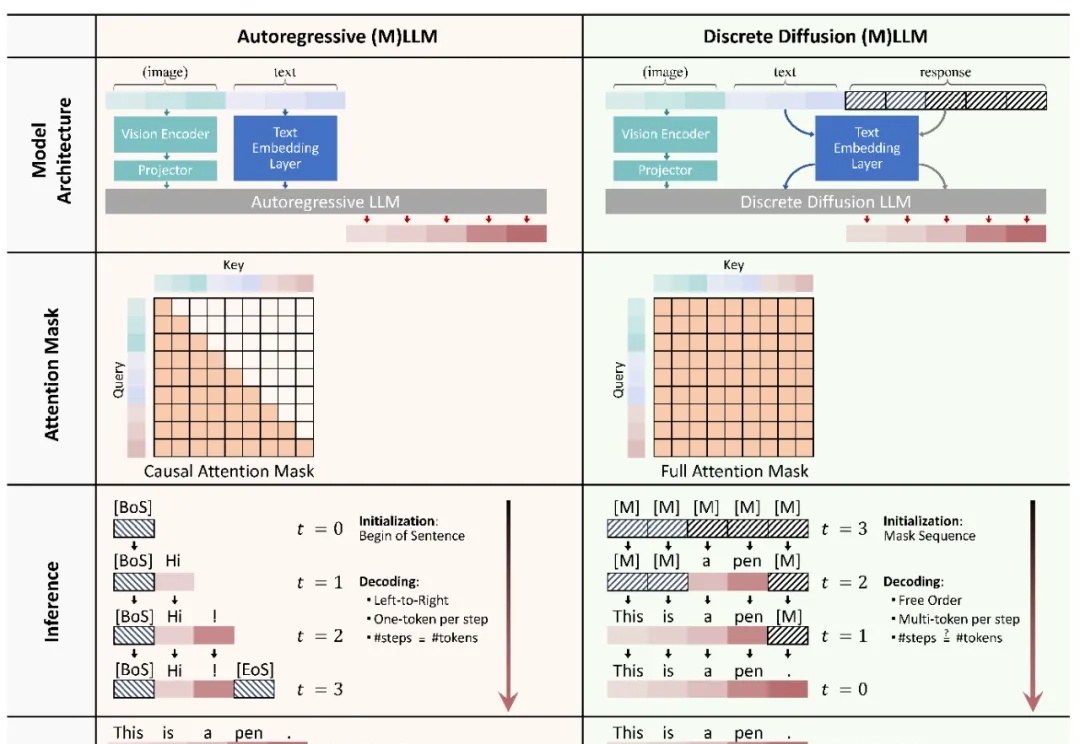

三个前沿AI能融合成AGI吗?Sakana AI提出Multi-LLM AB-MCTS方法,整合o4-mini、Gemini-2.5-Pro与DeepSeek-R1-0528模型,在推理过程中动态协作,通过试错优化生成过程,有效融合群体AI智慧。

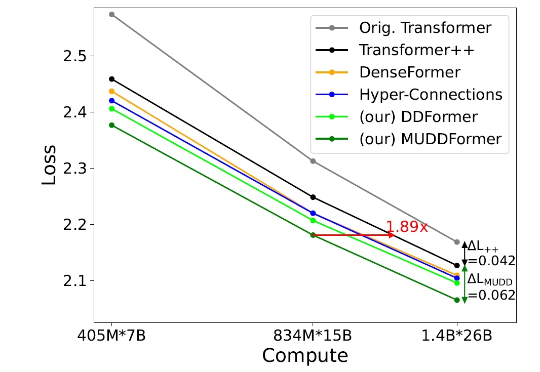

但在当今的深度 Transformer LLMs 中仍有其局限性,限制了信息在跨层间的高效传递。 彩云科技与北京邮电大学近期联合提出了一个简单有效的残差连接替代:多路动态稠密连接(MUltiway Dynamic Dense (MUDD) connection),大幅度提高了 Transformer 跨层信息传递的效率。

2022 年底,前 Stripe 亚太区业务负责人 Noah Pepper 创立了 Multiplier,这家初创公司最初旨在向税务会计师销售软件。

原生并行生成不仅仅是加速,它是我们对 LLM 推理思考方式的根本转变。

Era of Experience 这篇文章中提到:如果要实现 AGI, 构建能完成复杂任务的通用 agent,必须借助“经验”这一媒介,这里的“经验”就是指强化学习过程中模型和 agent 积累的、人类数据集中不存在的高质量数据。

西班牙初创公司 Multiverse Computing 于 6 月 12 日宣布 ,凭借其名为"CompactifAI"的技术优势,已完成 1.89 亿欧元(约合 2.15 亿美元)的巨额 B 轮融资。本轮B 轮融资由 Bullhound Capital 领投,该机构曾投资过 Spotify、Revolut、Delivery Hero、Avito 和 Discord 等企业

1986年,图灵奖得主Fred Brooks在软件工程领域提出了著名的"没有银弹"理论:没有任何一种技术或方法能够独自带来软件工程生产力的数量级提升。近四十年后,这个深刻洞察在AI领域再次得到验证——你是否也曾经历过这样的挫折:

普林斯顿大学与字节 Seed、北大、清华等研究团队合作提出了 MMaDA(Multimodal Large Diffusion Language Models),作为首个系统性探索扩散架构的多模态基础模型,MMaDA 通过三项核心技术突破,成功实现了文本推理、多模态理解与图像生成的统一建模。