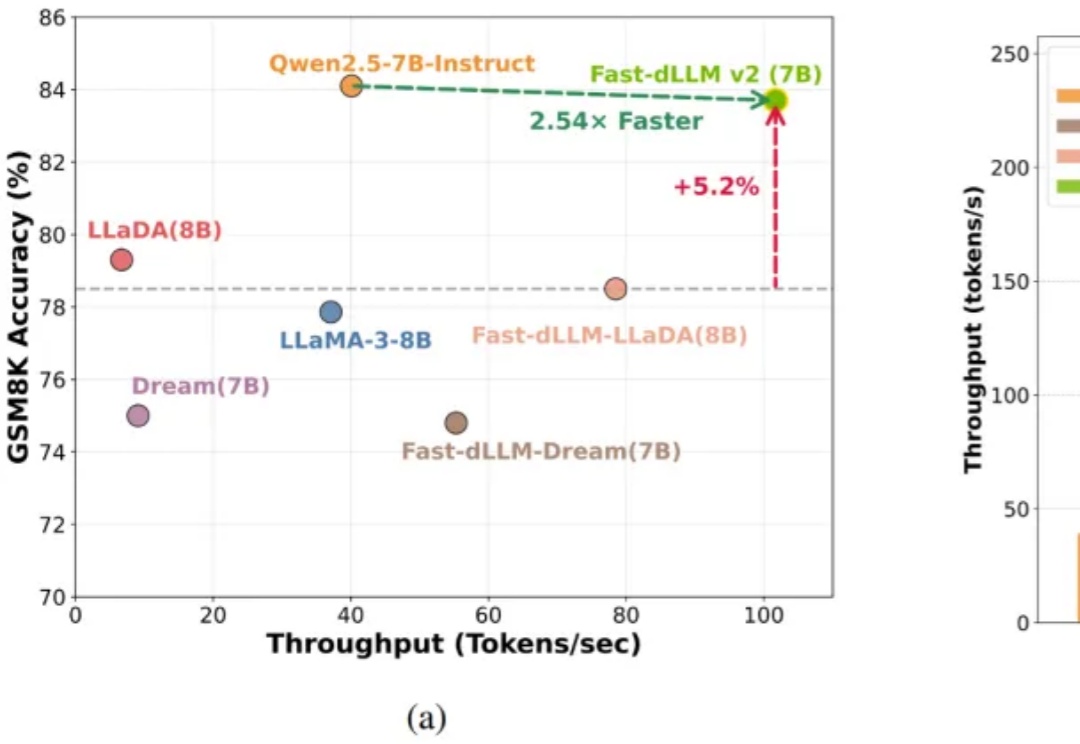

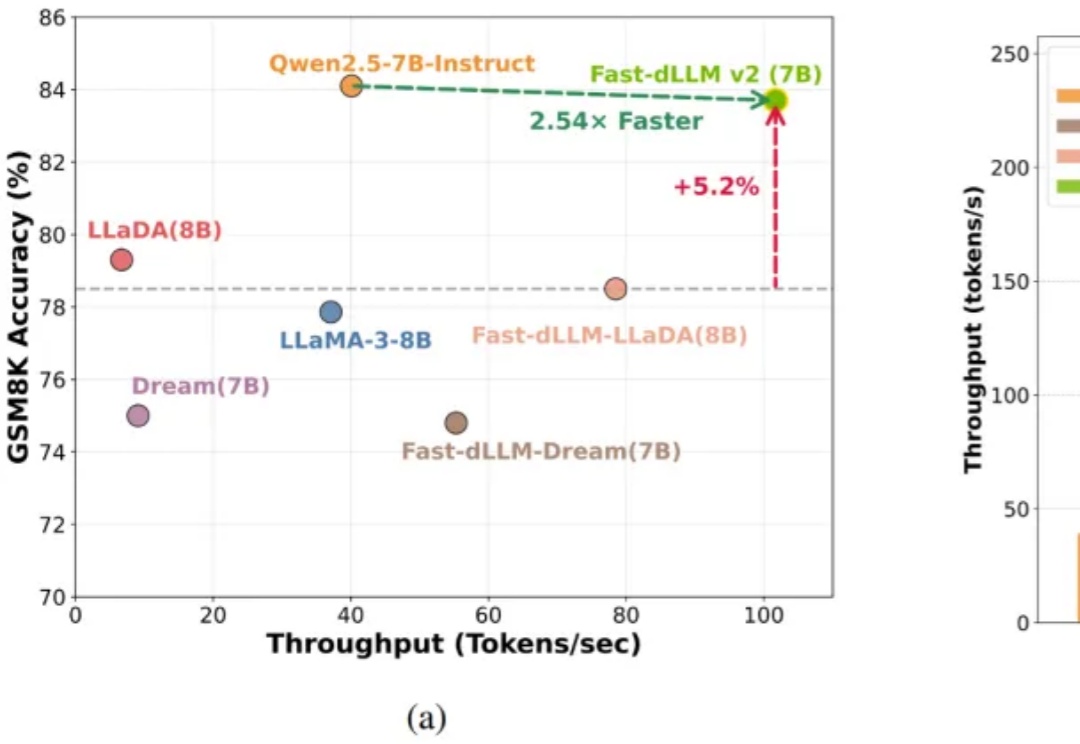

NVIDIA港大MIT联合推出Fast-dLLM v2:端到端吞吐量提升2.5倍

NVIDIA港大MIT联合推出Fast-dLLM v2:端到端吞吐量提升2.5倍自回归(AR)大语言模型逐 token 顺序解码的范式限制了推理效率;扩散 LLM(dLLM)以并行生成见长,但过去难以稳定跑赢自回归(AR)模型,尤其是在 KV Cache 复用、和 可变长度 支持上仍存挑战。

自回归(AR)大语言模型逐 token 顺序解码的范式限制了推理效率;扩散 LLM(dLLM)以并行生成见长,但过去难以稳定跑赢自回归(AR)模型,尤其是在 KV Cache 复用、和 可变长度 支持上仍存挑战。

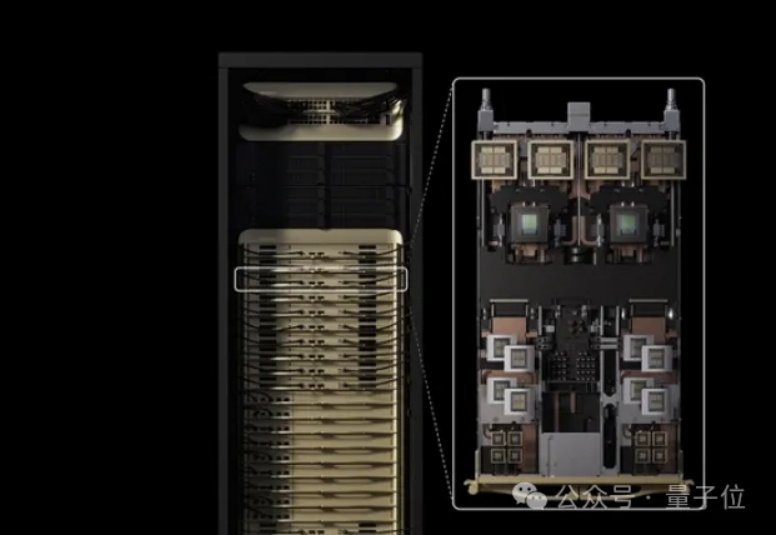

甲骨文于上周发布全球最大云端AI超级计算机「OCI Zettascale10」,由80万块NVIDIA GPU组成,峰值算力高达16 ZettaFLOPS,成为OpenAI「星际之门」集群的算力核心。其独创Acceleron RoCE网络实现GPU间高效互联,显著提升性能与能效。该系统象征甲骨文在AI基础设施竞争中的强势布局。

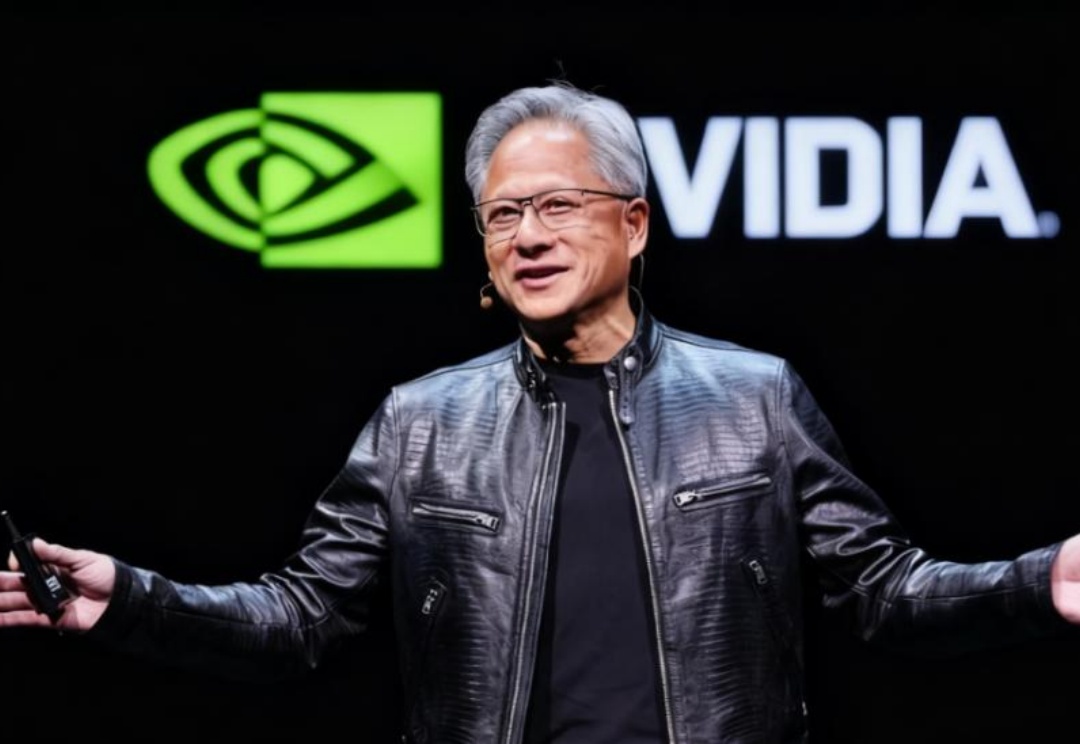

AI模型是现在,Physical AI是未来

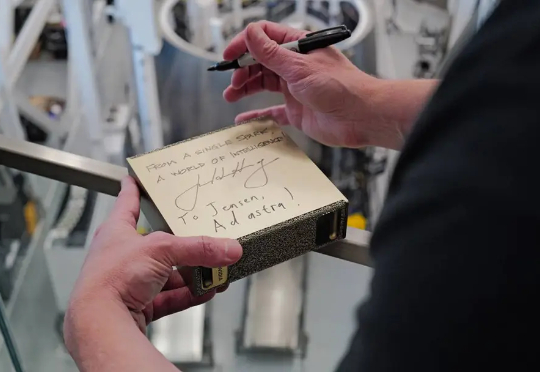

今天星舰第十一飞圆满收官,没想到黄仁勋也闪现到了现场。 原来,黄仁勋亲自飞到了德州的星际基地(Starbase),在冲天的星舰旁边,就是为了把一台刚出炉的新「核弹」交到了马斯克手上。 这就是大家从年初

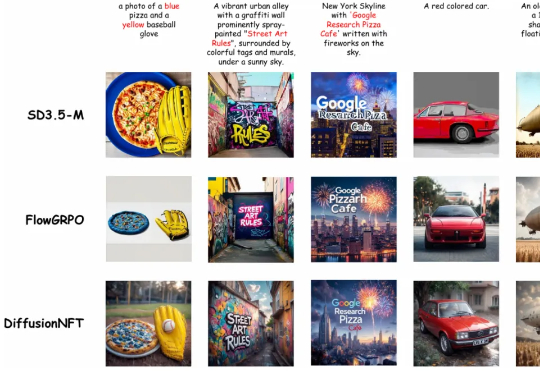

清华大学朱军教授团队,NVIDIA Deep Imagination 研究组与斯坦福 Stefano Ermon 团队联合提出了一种全新的扩散模型强化学习(RL)范式 ——Diffusion Negative-aware FineTuning (DiffusionNFT)。该方法首次突破现有 RL 对扩散模型的基本假设,直接在前向加噪过程(forward process)上进行优化

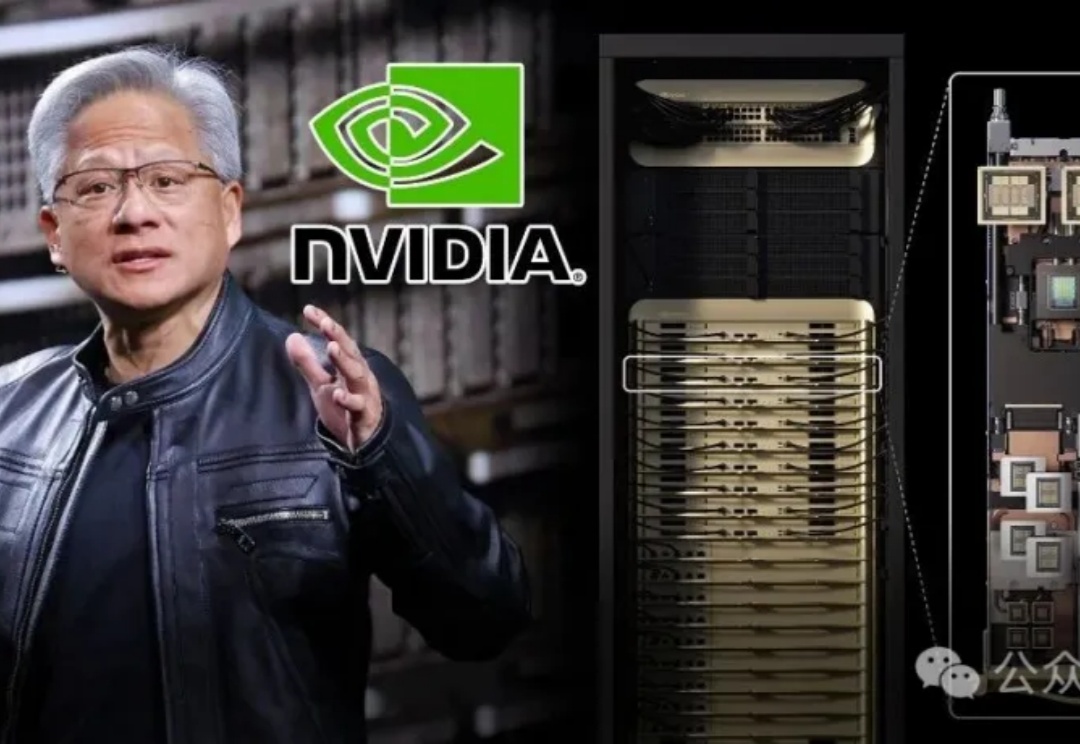

昨天,英伟达重磅发布了专为海量上下文AI打造的CUDA GPU——Rubin CPX,将大模型一次性推理带入「百万Token时代」。NVIDIA创始人兼CEO黄仁勋表示,Vera Rubin平台将再次推动AI计算的前沿,不仅带来下一代Rubin GPU,也将开创一个CPX的全新处理器类别。

老黄对token密集型任务下手了。

虽然大家都期待未来的 Agent 能够真正端到端完成所有任务,并且在出错时也知道如何重新开始,但目前 AI 还没有达到这种能力。

今年是人工智能正式被提出七十周年,新智元十周年峰会也将于9月7日在北京中关村软件园举行,主题是「新天终启,万象智生」。此次峰会将发布《2025新智元ASI前沿趋势报告》,大会集结百度CTO、NVIDIA副总裁等十位领航者,以「十人十题」解构AI五阶段路线图,纵贯大模型、Physical AI、具身智能到医疗AI、视频AI、脑科学、AI Agent与人才培养,定义下个十年智能图景。

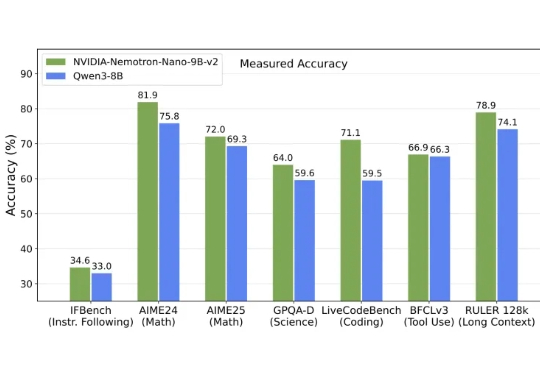

英伟达发布全新架构9B模型,以Mamba-Transformer混合架构实现推理吞吐量最高提升6倍,对标Qwen3-8B并在数学、代码、推理与长上下文任务中表现持平或更优。