小扎噩梦来了!MSL两月爆雷8人闪辞,PyTorch元老出走实验室人心崩盘

小扎噩梦来了!MSL两月爆雷8人闪辞,PyTorch元老出走实验室人心崩盘小扎AI豪赌,要翻车了?MSL成立两月,从PyTorch元老到新招募的硅谷天才,至少八人曝出离职。甚至,还有不少直奔OpenAI。内部重组频繁,战略摇摆不定,Meta超级智能梦裂痕满满。

小扎AI豪赌,要翻车了?MSL成立两月,从PyTorch元老到新招募的硅谷天才,至少八人曝出离职。甚至,还有不少直奔OpenAI。内部重组频繁,战略摇摆不定,Meta超级智能梦裂痕满满。

加拿大AI新贵Cohere获5亿美元融资、估值68亿美元,前Meta FAIR副总裁、PyTorch与Llama重要推手Joelle Pineau加盟出任首席AI官,或将开启企业AI新战局。

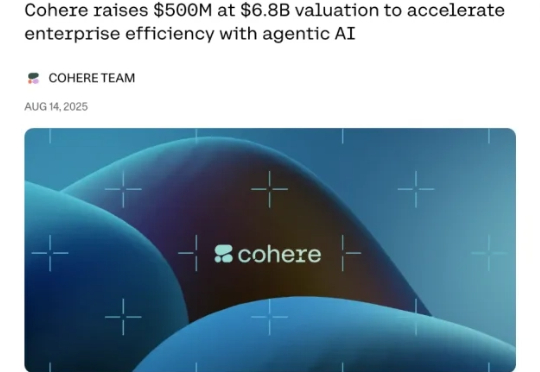

本想练练手合成点数据,没想到却一不小心干翻了PyTorch专家内核!斯坦福华人团队用纯CUDA-C写出的AI生成内核,瞬间惊艳圈内并登上Hacker News热榜。团队甚至表示:本来不想发这个结果的。

好家伙,AI意外生成的内核(kernel),性能比人类专家专门优化过的还要好!

Meta推出KernelLLM,这个基于Llama 3.1微调的8B模型,竟能将PyTorch代码自动转换为高效Triton GPU内核。实测数据显示,它的单次推理性能超越GPT-4o和DeepSeek V3,多次生成时得分飙升。

前 Meta 工程师创办的 Lace AI 融资1400万美元,这是一家家庭服务创收软件初创公司。作为 Meta 的 AI 工程师,Boris Valkov 帮助构建了世界上最大的机器学习库之一 PyTorch。在那里,瓦尔科夫意识到人工智能“即将解锁能力,在软件堆栈的应用层中。

Meta AI研究副总裁Pineau亲自发帖声称将于5月30日离职,她主导了Llama开源系列及PyTorch项目。此举正逢扎克伯格重金投入AI及LlamaCon AI大会前夕,引发业内对Meta战略调整和未来新作的诸多猜测。

PyTorch机器学习大神Horace He宣布,正是离职加入OpenAI前CTO初创Thinking Machines。这位技术奇才,曾被OpenAI、SSI、谷歌等顶级AI实验室争相邀请,最终选择了刚刚成立的初创。他的选择,不仅是个人职业生涯的转折,更是对AI未来发展方向的一次战略性押注。

斯坦福和普林斯顿研究者发现,DeepSeek-R1生成的自定义CUDA内核,完爆了o1和Claude 3.5 Sonnet,拿下总排名第一。虽然目前只能在不到20%任务上超越PyTorch Eager基线,但GPU编程加速自动化的按钮,已经被按下!

Transformer论文八位作者之一Llion Jones创立的Sakana AI发布重磅成果——全球首个「AI CUDA工程师」!它能将PyTorch代码自动转换为高度优化的CUDA内核,速度比PyTorch原生实现快10-100倍。