本地也能运行Deep Research!支持arXiv平台,兼容PDF、Markdown等

本地也能运行Deep Research!支持arXiv平台,兼容PDF、Markdown等今年年初,OpenAI 上线 Deep Research,开启了智能体又一新阶段,其能根据用户需求自主进行网络信息检索、整合多源信息、深度分析数据,并最终为用户提供全面深入的解答。

今年年初,OpenAI 上线 Deep Research,开启了智能体又一新阶段,其能根据用户需求自主进行网络信息检索、整合多源信息、深度分析数据,并最终为用户提供全面深入的解答。

HuixiangDou 是群聊场景的 LLM 知识助手。

南洋理工大学的研究团队提出了MedRAG模型,通过结合知识图谱推理增强大语言模型(LLM)的诊断能力,显著提升智能健康助手的诊断精度和个性化建议水平。MedRAG在真实临床数据集上表现优于现有模型,准确率提升11.32%,并具备良好的泛化能力,可广泛应用于不同LLM基模型。

去年的诺贝尔奖梅开二度,两次颁给了AI相关领域,让所有人惊讶于AI4science的潜力。然而近日密西根大学的一项覆盖16万篇文献的大规模研究指出,AI和科学的结合仍存在错位。

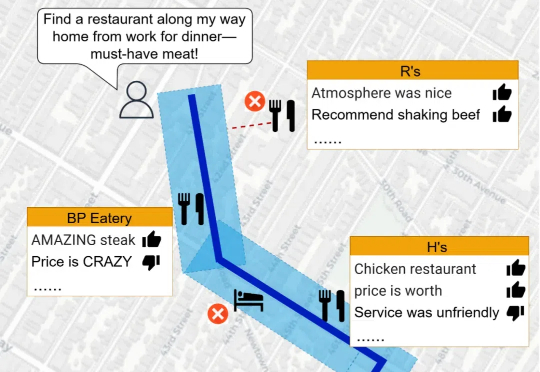

当涉及到空间推理任务时,LLMs 的表现却显得力不从心。空间推理不仅要求模型理解复杂的空间关系,还需要结合地理数据和语义信息,生成准确的回答。为了突破这一瓶颈,研究人员推出了 Spatial Retrieval-Augmented Generation (Spatial-RAG)—— 一个革命性的框架,旨在增强 LLMs 在空间推理任务中的能力。

技术上,从传统的关键词检索,到RAG,大家已经不满足于只是生成对应的简单回答。而是期待大语言模型能够更好地应用于企业级场景,产生更大的价值。不久前,OpenAI推出了最新的深度内容生成神器“DeepResearch”,用户只需一个"特斯拉的合理市值是多少"的提问,

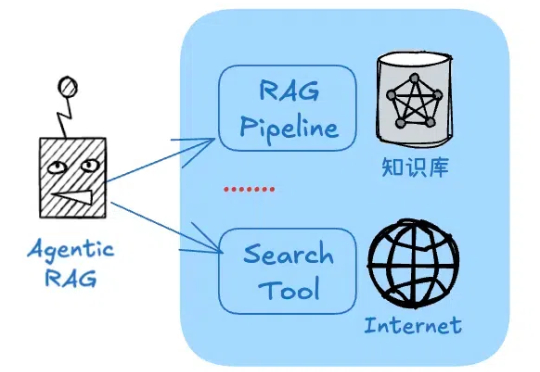

RAG是一种基于“检索结果”做推理的应用,这大大限制了类似DeepSeek-R1模型的发挥空间。但又的确存在将RAG的准确性与DeepSeek深度思考能力结合的场景,而不仅仅是回答事实性问题。比如:

什么,你在开发RAG竟然还没听说过Embedding模型还有排名?在AI应用开发热潮中,Embedding模型的选择已成为决定RAG系统成败的关键因素。然而,令人惊讶的是,许多开发者仍依靠直觉或跟风选择模型,而非基于系统化评估。

零基础逆袭!2年靠AI自学编程打造3款千万级APP,揭秘TikTok流量红利+9.9美金订阅制,如何用百元营销撬动百万利润?

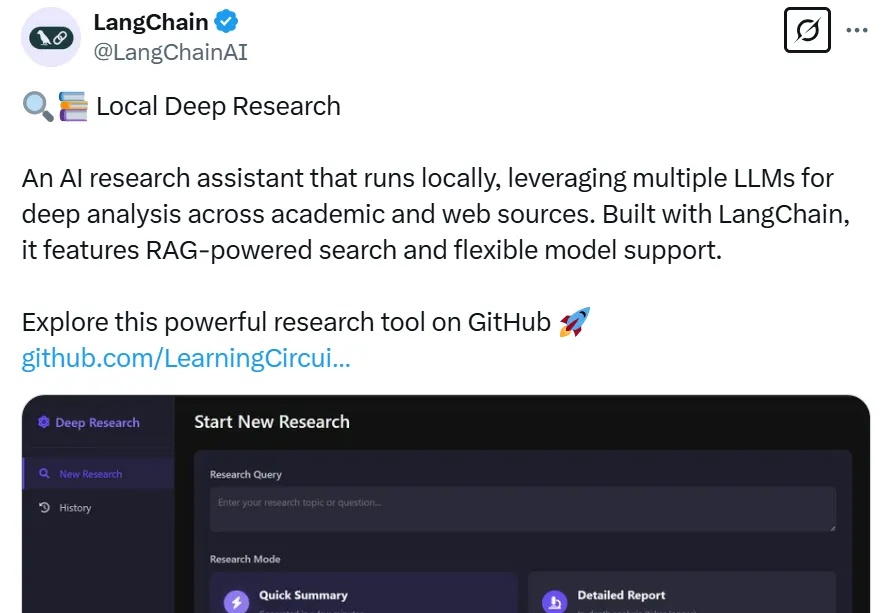

Zep,一个为大模型智能体提供长期记忆的插件,能将智能体的记忆组织成情节,从这些情节中提取实体及其关系,并将它们存储在知识图谱中,从而让用户以低代码的方式为智能力构建长期记忆。