RAG技术演进的四大核心命题【阿里官方对RAG的理解认知】

RAG技术演进的四大核心命题【阿里官方对RAG的理解认知】随着技术的深入应用,如何高效利用大模型技术优化用户体验,同时应对其带来的诸多挑战?本文将从RAG的发展趋势、技术挑战、核心举措以及未来展望四个维度总结我们应对挑战的新的思路和方法。

随着技术的深入应用,如何高效利用大模型技术优化用户体验,同时应对其带来的诸多挑战?本文将从RAG的发展趋势、技术挑战、核心举措以及未来展望四个维度总结我们应对挑战的新的思路和方法。

AI:从提供事实到塑造思想。

作为一名从业七年的程序员,最近听到很多程序员朋友都喜提了n+1裁员大礼包。

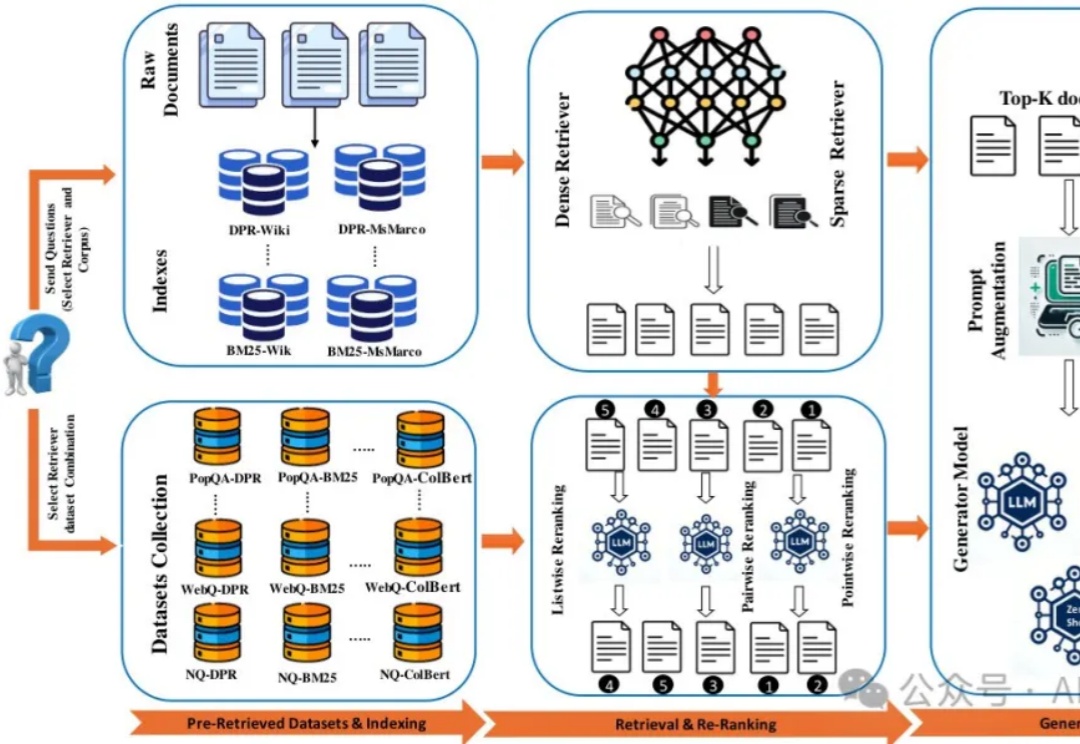

继昨天《RAG太折磨人啦,试下pip install rankify,检索、重排序、RAG三合一,完美》发布之后,有许多朋友向我询问Rankify的具体使用方法和部署细节,尤其是生产环境如何处理自定义数据集和本地数据集。

Spatial-RAG结合了空间数据库和大型语言模型(LLM)的能力,能够处理复杂的空间推理问题。通过稀疏和密集检索相结合的方式,Spatial-RAG可以高效地从空间数据库中检索出满足用户查询的空间对象,并利用LLM的语义理解能力对这些对象进行排序和生成最终答案。

现有RAG工具的碎片化和复杂性常常让开发者头疼不已。昨天我的Agent群里朋友们就Rerank问题展开激烈讨论,我想起之前看到的一篇论文,这项研究介绍了一个完美的开源python工具包Rankify,它将检索、重排序和RAG三大功能整合在一个统一框架中,大幅简化了开发流程。

RAG应用的一大复杂性体现在其多样的原始知识结构与表示。特别在企业场景下,混合多种媒体形式且具有复杂布局的文档随处可见,比如一份PPT:

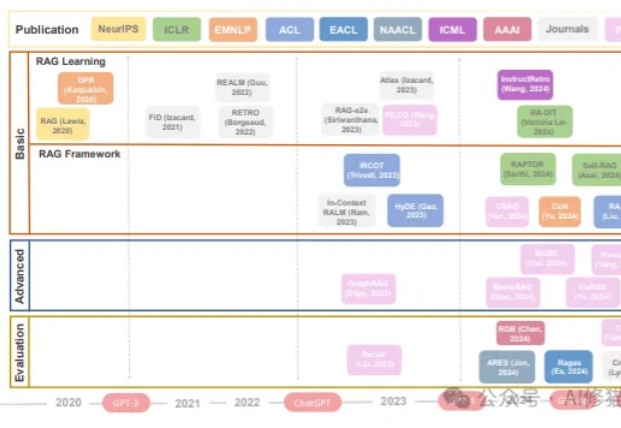

RAG工作发展时间线(2020年至今)。展示了RAG相关研究的三个主要领域:基础(包括RAG学习和RAG框架)、进阶和评估。关键的语言模型(GPT-3、GPT-4等)发展节点标注在时间线上。

通过收集六名志愿者一周的多模态生活数据,研究人员构建了300小时的第一视角数据集EgoLife,旨在开发一款基于智能眼镜的AI生活助手。项目提出了EgoButler系统,包含EgoGPT和EgoRAG两个模块,分别用于视频理解与长时记忆问答,助力AI深入理解日常生活并提供个性化帮助。

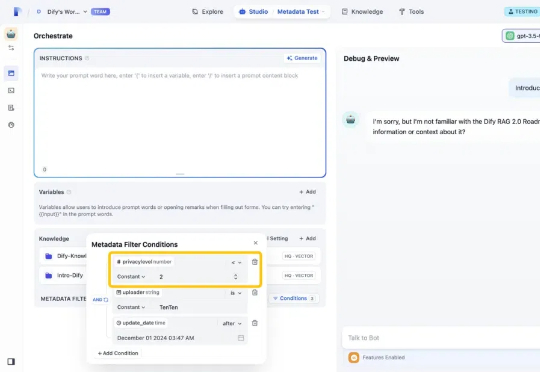

我是 Dify 产品团队的 Yawen。今天,我们很高兴地宣布发布 Dify v1.1.0,并推出了以“元数据”作为知识过滤器的新功能。通过利用自定义的元数据属性,元数据过滤能够提升知识库中相关数据的检索效率和准确度。过去,用户只能在庞大的数据集中进行搜索,无法根据特定需求进行筛选或控制访问,难以快速锁定最相关的信息。、