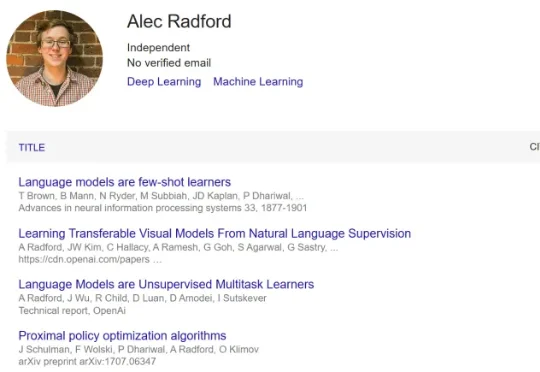

GPT之父Alec Radford新作:给大模型做「脑部手术」,危险知识重学成本暴增7000倍

GPT之父Alec Radford新作:给大模型做「脑部手术」,危险知识重学成本暴增7000倍近日, Anthropic 和斯坦福研究者 Neil Rathi 与这位传奇研究者联合发布了一篇新论文,并得到了一些相当惊人的新发现。在这项研究中,他们挑战了当前大模型安全领域的一个核心假设。长期以来,业界普遍认为要在模型发布后通过 RLHF 或微调来限制其危险行为。但 Neil Rathi 和 Alec Radford 提出了一种更本质的解法: