Nano Banana不会应试!指标拉垮,视觉效果惊艳,实测14个任务

Nano Banana不会应试!指标拉垮,视觉效果惊艳,实测14个任务最新报告探讨了生成式模型Nano Banana Pro在低层视觉任务中的表现,如去雾、超分等,传统上依赖PSNR/SSIM等像素级指标。研究发现,Nano Banana Pro在视觉效果上更佳,但传统指标表现欠佳,因生成式模型更追求语义合理而非像素对齐。

最新报告探讨了生成式模型Nano Banana Pro在低层视觉任务中的表现,如去雾、超分等,传统上依赖PSNR/SSIM等像素级指标。研究发现,Nano Banana Pro在视觉效果上更佳,但传统指标表现欠佳,因生成式模型更追求语义合理而非像素对齐。

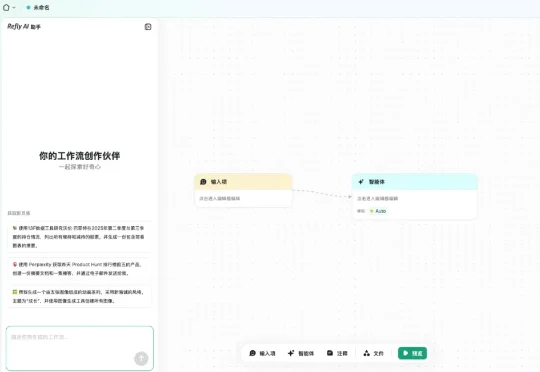

种子轮拿到数百万美元融资、估值近千万,朱啸虎的金沙江创投、高瓴创投和 Classin 共同投资。 Refly.AI 给自己的定位是更适合大众的 Vibe Workflow 产品。 为什么要做 Vibe

近日,Refly.ai宣布完成数百万美金的种子轮融资,估值近千万。本轮融资由金沙江创投、高瓴创投和Classin共同投资。据「暗涌Waves」了解,金沙江创投主管合伙人朱啸虎在接触项目后的一周内便锁定了TS。

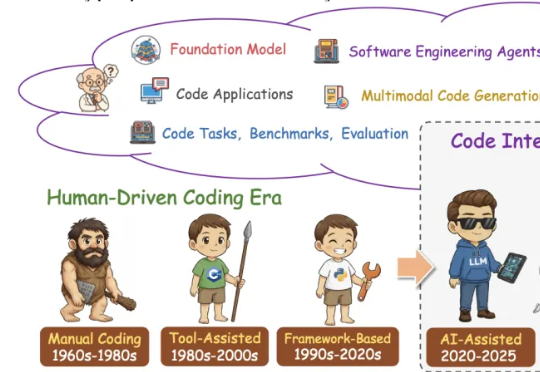

这篇学术论长文由北京航空航天大学复杂关键软件环境全国重点实验室领衔。《From Code Foundation Models to Agents and Applications》一文是对过去几年代码智能领域的一次系统梳理:模型、任务、训练、智能体、安全与应用都被串联成了一条完整、连贯的技术链路。

今天,谷歌生成式AI团队发布了Nano-Banana的首个官方教程——《The Complete Guide to Nano Banana Pro: 10 Tips for Professional Asset Production》。核心信息是如何用 Nano-Banana Pro 制作专业级的素材!

特朗普按下「创世纪」按钮之时,美国举国豪赌「AI曼哈顿计划」!白宫给它起名叫——美国创世纪计划(US Genesis Mission): 让AI直接参与提出科学假设、设计实验、分析数据,让「AI科学家」加速科研创新。

对初创公司来说,Superlinear(指数引力)的第一个业务 Deeplink 堪称成功:去年成立,今年的 ARR(年经常性收入) 就达到 500 万美元;且已经实现盈利。但创始人于北川并不打算在这个业务上继续重点投入,而是带领核心团队,全力转向了一款新产品 Lessie AI。

“What is meant often goes far beyond what is said, and that is what makes conversation possible.” ——H. P. Grice

在三维视觉领域,3D Gaussian Splatting (3DGS) 是近年来大热的三维场景建模方法。它通过成千上万的高斯球在空间中“泼洒”,拼合成一个高质量的三维世界,就像是把一片空白的舞台,用彩色的光斑和粒子逐渐铺满,最后呈现出一幅立体的画卷。

谷歌在第三天发布了《上下文工程:会话与记忆》(Context Engineering: Sessions & Memory) 白皮书。文中开篇指出,LLM模型本身是无状态的 (stateless)。如果要构建有状态的(stateful)和个性化的 AI,关键在于上下文工程。