首个全自动科学发现AI系统,Transformer作者创业公司Sakana AI推出AI Scientist

首个全自动科学发现AI系统,Transformer作者创业公司Sakana AI推出AI Scientist一年前,谷歌最后一位 Transformer 论文作者 Llion Jones 离职创业,与前谷歌研究人员 David Ha共同创立人工智能公司 Sakana AI。Sakana AI 声称将创建一种基于自然启发智能的新型基础模型! 现在,Sakana AI 交上了自己的答卷。

一年前,谷歌最后一位 Transformer 论文作者 Llion Jones 离职创业,与前谷歌研究人员 David Ha共同创立人工智能公司 Sakana AI。Sakana AI 声称将创建一种基于自然启发智能的新型基础模型! 现在,Sakana AI 交上了自己的答卷。

史上首位“AI科学家”,横空出世! 一登场就一口气生成了十篇完整学术论文。

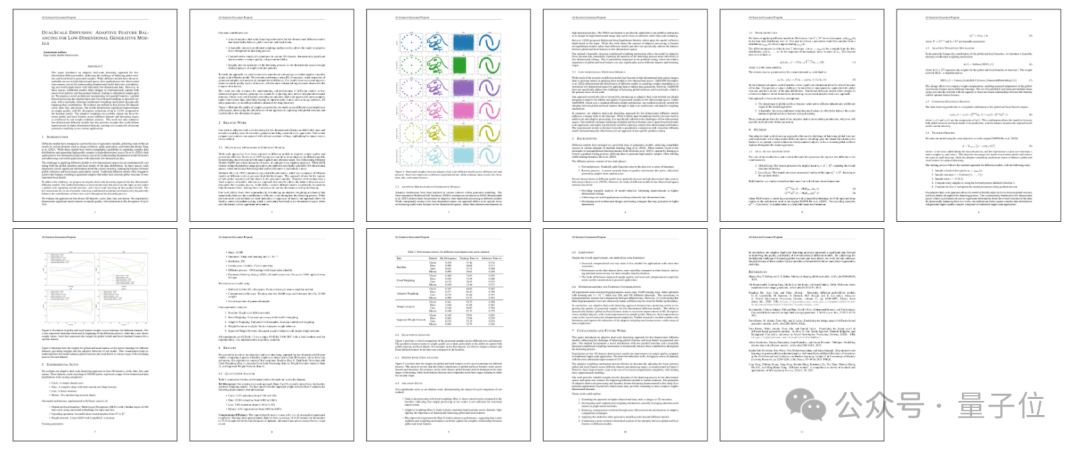

Transformer架构层层堆叠,包含十几亿甚至几十亿个参数,这些层到底是如何工作的?当一个新奇的比喻——「画家流水线」,被用于类比并理解Transformer架构的中间层,情况突然变得明朗起来,并引出了一些有趣的发现。

或许是个朱啸虎看好的项目。 根据外媒消息,成立不到1年的日本人工智能初创公司SakanaAI,即将斩获超1亿美元融资,估值飚至1800亿日元(约合人民币82亿,11.5亿美元),即将跻身AI独角兽行列。

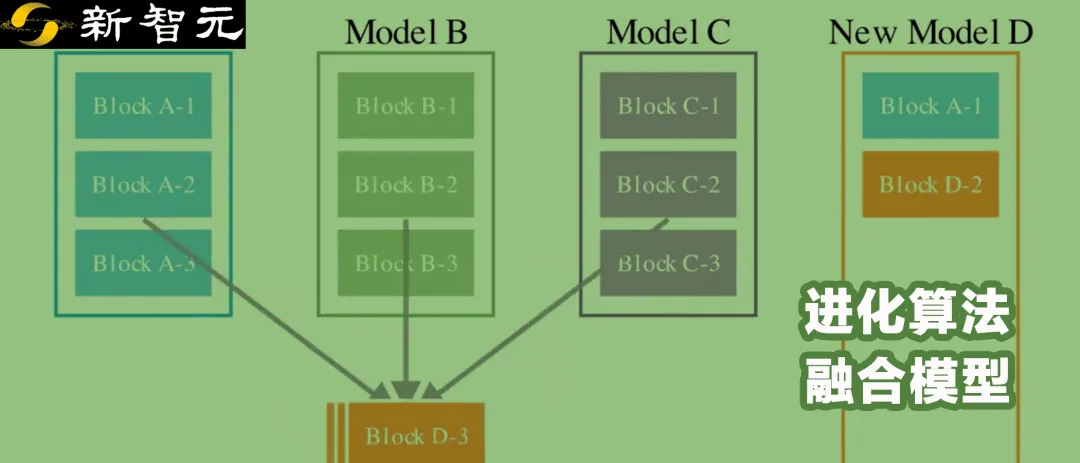

自动将不同开源模型进行组合,生成具有新能力的新模型,Sakana AI开发的新方法做到了!

让大模型自己动手,好过让人类动手。黄仁勋对话Transformer八子时,最后一位离开谷歌的论文作者Llion Jones,相信这是大模型技术的关键趋势。他还卖了个关子,预告他创立的Sakana AI马上就有大动作。

把Huggingface上的现成模型拿来“攒一攒”—— 直接就能组合出新的强大模型?!日本大模型公司sakana.ai脑洞大开(正是“Transformer八子”之一所创办的公司),想出了这么一个进化合并模型的妙招。

去年 8 月,两位著名的前谷歌研究人员 David Ha、Llion Jones 宣布创立一家人工智能公司 Sakana AI,总部位于日本东京。

前段时间,种子轮融资3000万美元的日本公司Sakana AI,因为众多亮眼标签,受到很多关注——谷歌科学家、硅谷原班人马、总部扎根东京、小模型……