突破单链思考上限,清华团队提出原生「并行思考」scale范式

突破单链思考上限,清华团队提出原生「并行思考」scale范式近年来,大语言模型(LLMs)在复杂推理任务上的能力突飞猛进,这在很大程度上得益于深度思考的策略,即通过增加测试时(test-time)的计算量,让模型生成更长的思维链(Chain-of-Thought)。

近年来,大语言模型(LLMs)在复杂推理任务上的能力突飞猛进,这在很大程度上得益于深度思考的策略,即通过增加测试时(test-time)的计算量,让模型生成更长的思维链(Chain-of-Thought)。

很多人认为,Scaling Law 正在面临收益递减,因此继续扩大计算规模训练模型的做法正在被质疑。最近的观察给出了不一样的结论。研究发现,哪怕模型在「单步任务」上的准确率提升越来越慢,这些小小的进步叠加起来,也能让模型完成的任务长度实现「指数级增长」,而这一点可能在现实中更有经济价值。

爱诗科技CEO王长虎告诉我们,过去两年,公司做对了两件事:不盲目烧钱扩张,不盲目对模型做Scaling。

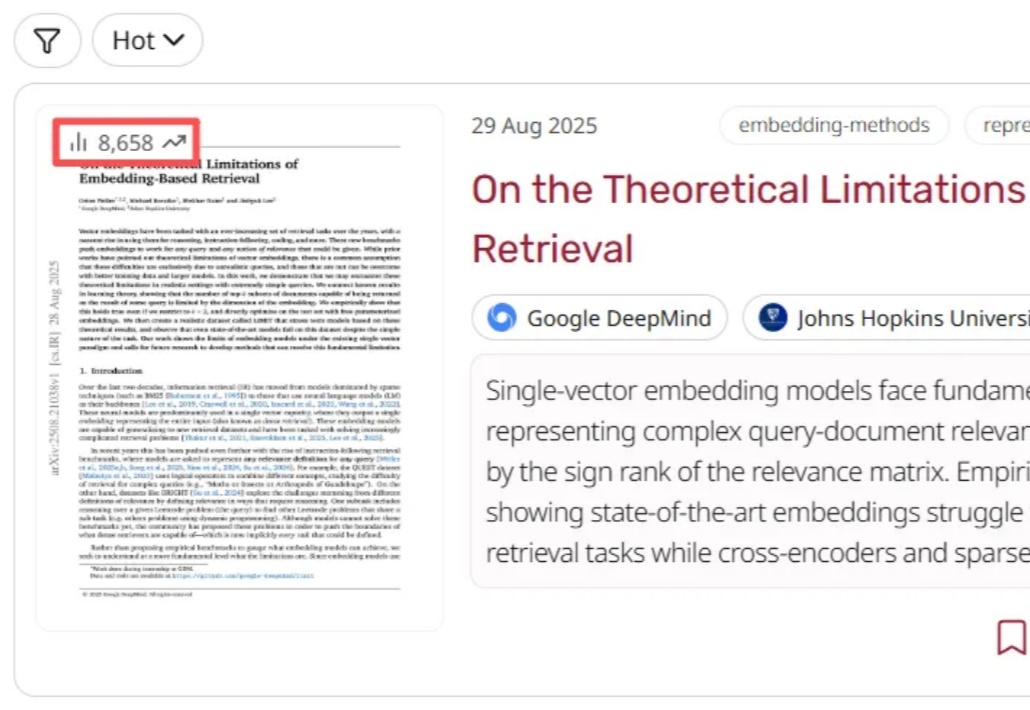

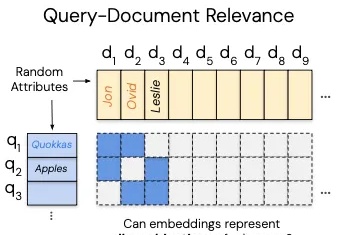

这几天,一篇关于向量嵌入(Vector Embeddings)局限性的论文在 AlphaXiv 上爆火,热度飙升到了近 9000。

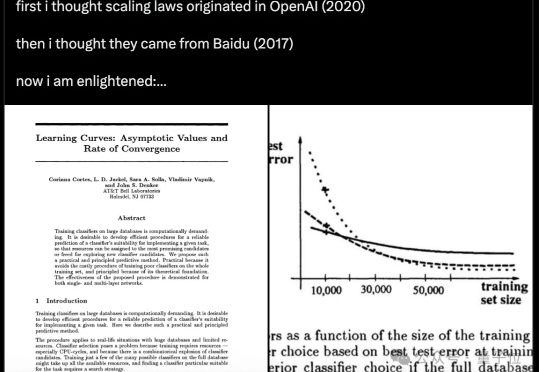

AI 也要「考古」式科研?

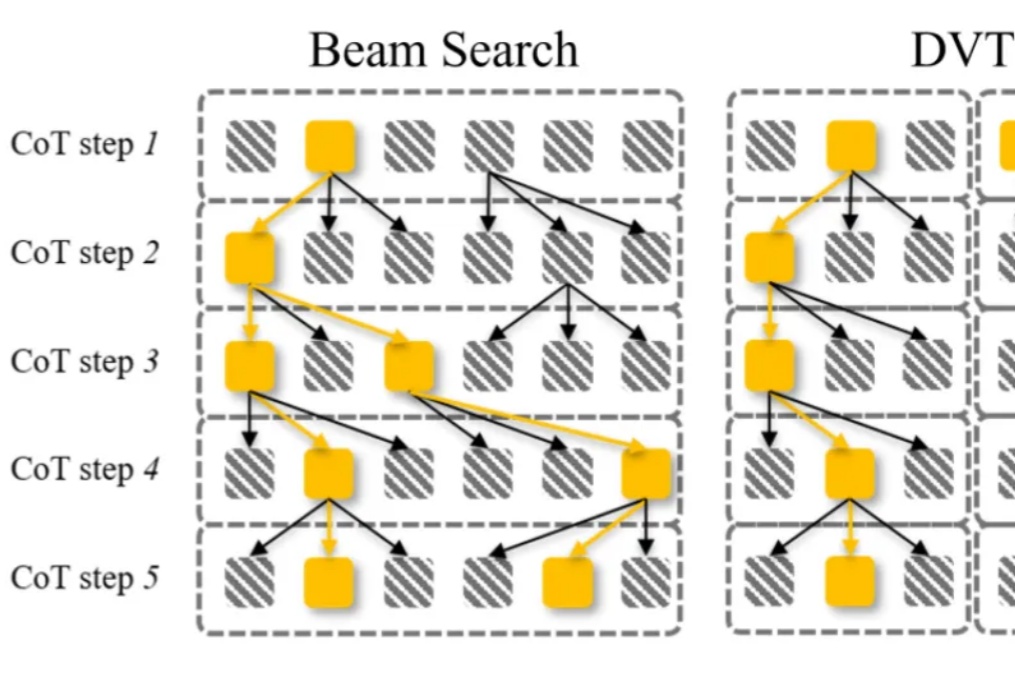

大语言模型通过 CoT 已具备强大的数学推理能力,而 Beam Search、DVTS 等测试时扩展(Test-Time Scaling, TTS)方法可通过分配额外计算资源进一步提升准确性。然而,现有方法存在两大关键缺陷:路径同质化(推理路径趋同)和中间结果利用不足(大量高质量推理分支被丢弃)。

最近,工业界“RAG已死”甚嚣尘上。过去几年,AI领域的主旋律是“规模定律”(Scaling Law),即更大的模型、更多的数据会带来更好的性能。即便偶然有瑕疵,也认为只是工程上的不足,并非数学上的不可能。

原来,Scaling Law在32年前就被提出了! 不是2020年的OpenAI、不是2017年的百度,而是1993年的贝尔实验室。

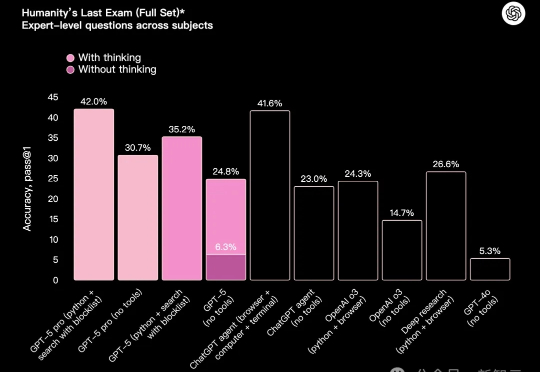

GPT-5发布半月,却被连连吐槽。如今,一张基准与GPT-4对比基准测试图,证明了Scaling Law没有撞墙。七年间,从GPT-1到GPT-5十四个花式Prompt对决,实力差一目了然。

奥特曼称GPT-5「比人聪明」,但OpenAI首席运营官Lightcap澄清:这不是AGI。这只是能力过剩的冰山一角——我们仍有十年产品可建,模型越智能,融合越要精妙。GPT-5标志着从纯智商到反思能力的全面跃进。