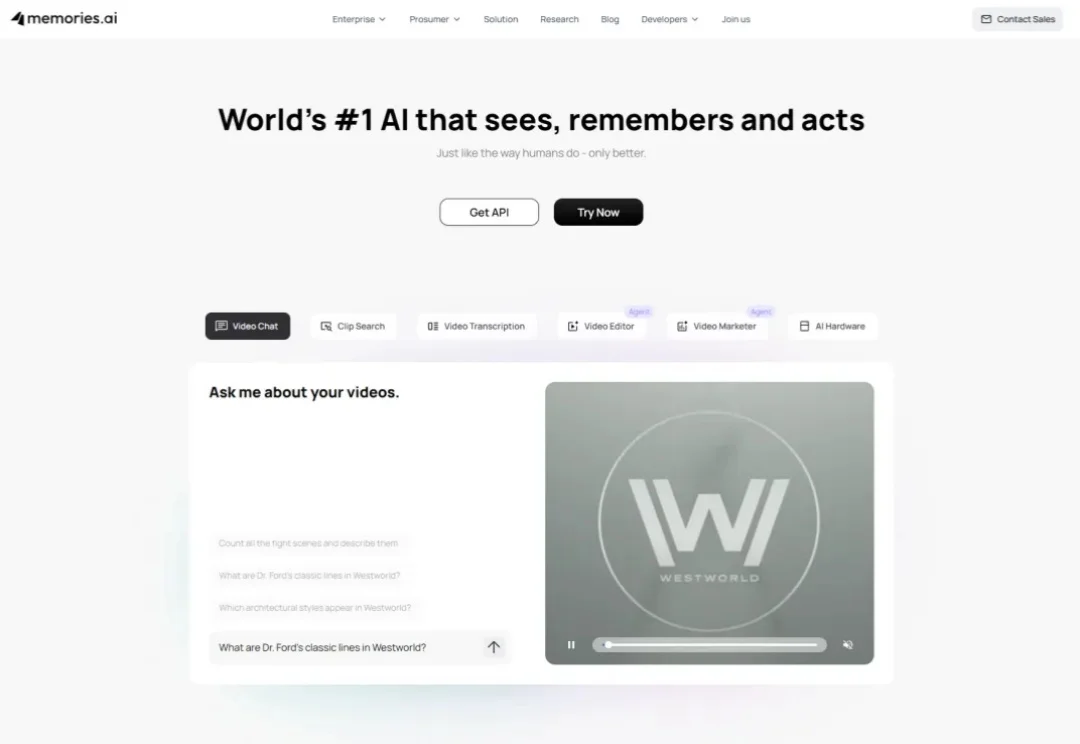

Z Potentials|沈俊潇:从 Meta 出走,剑桥博士创立 Memories.ai,获 Samsung Next、Susa Ventures 千万美元押注

Z Potentials|沈俊潇:从 Meta 出走,剑桥博士创立 Memories.ai,获 Samsung Next、Susa Ventures 千万美元押注过去几年,AI 行业几乎把所有注意力都投向了“会不会想”:更强的推理、更大的模型、更快的生成。但在真实世界里,很多问题并不是想不想得出来,而是你到底记不记得发生过什么——尤其是视频。