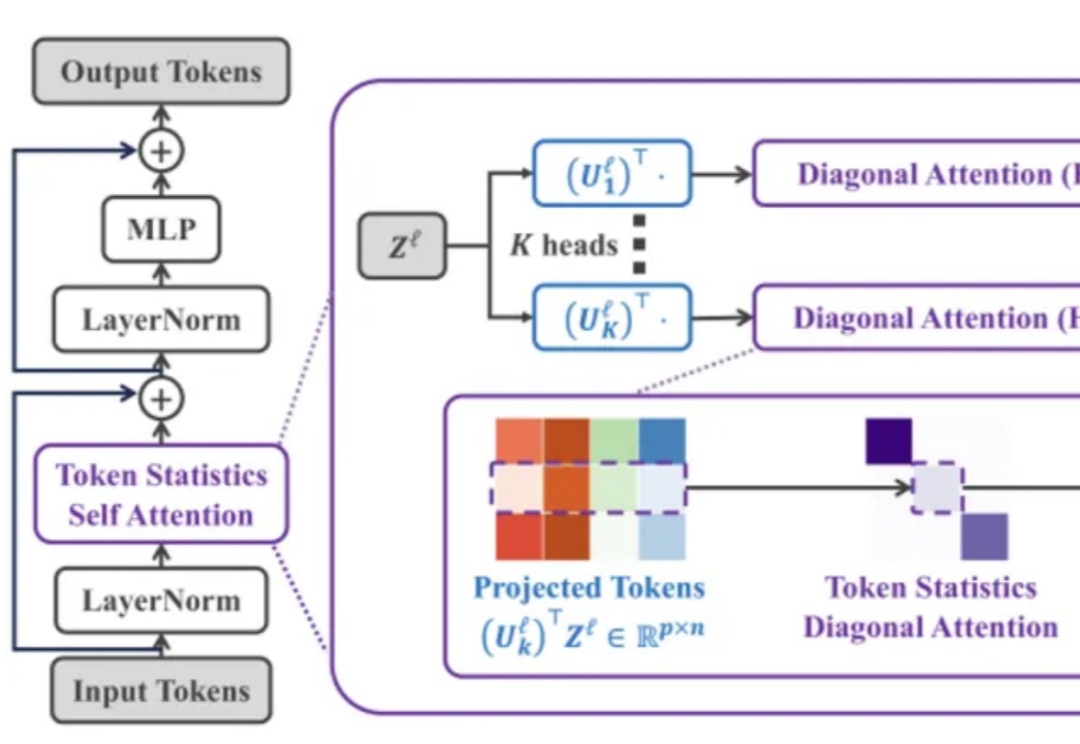

首个基于统计学的线性注意力机制ToST,高分拿下ICLR Spotlight

首个基于统计学的线性注意力机制ToST,高分拿下ICLR SpotlightTransformer 架构在过去几年中通过注意力机制在多个领域(如计算机视觉、自然语言处理和长序列任务)中取得了非凡的成就。然而,其核心组件「自注意力机制」 的计算复杂度随输入 token 数量呈二次方增长,导致资源消耗巨大,难以扩展到更长的序列或更大的模型。

来自主题: AI技术研报

8125 点击 2025-02-19 10:02