DeepSeek华为火线联手!硅基流动首发即限流,全国产API白菜价,零门槛部署

DeepSeek华为火线联手!硅基流动首发即限流,全国产API白菜价,零门槛部署国产大模型云服务平台SiliconCloud(硅基流动),首发上线了基于华为云昇腾云服务的DeepSeek-V3、DeepSeek-R1。 DeepSeek-V3:输入只需1块钱/M tokens,输出2块钱/M tokens

国产大模型云服务平台SiliconCloud(硅基流动),首发上线了基于华为云昇腾云服务的DeepSeek-V3、DeepSeek-R1。 DeepSeek-V3:输入只需1块钱/M tokens,输出2块钱/M tokens

眼看DeepSeek风头尽显,被逼急的OpenAI果然紧急发布了o3-mni。不光免费用户都能用,每百万输入和输出token价格更是疯狂跳水打骨折价!

VARGPT是一种新型多模态大模型,能够在单一框架内实现视觉理解和生成任务。通过预测下一个token完成视觉理解,预测下一个scale完成视觉生成,展现出强大的混合模态输入输出能力。

谈到大模型的“国货之光”,除了DeepSeek之外,阿里云Qwen这边也有新动作——首次将开源Qwen模型的上下文扩展到1M长度。

创立10年内估值超过10亿美元的创新公司,被称之为独角兽,它们是市场潜力无限的绩优股,是为行业带来技术创新、模式创新的佼佼者。

研究者提出了FAST,一种高效的动作Tokenizer。通过结合离散余弦变换(DCT)和字节对编码(BPE),FAST显著缩短了训练时间,并且能高效地学习和执行复杂任务,标志着机器人自回归Transformer训练的一个重要突破。

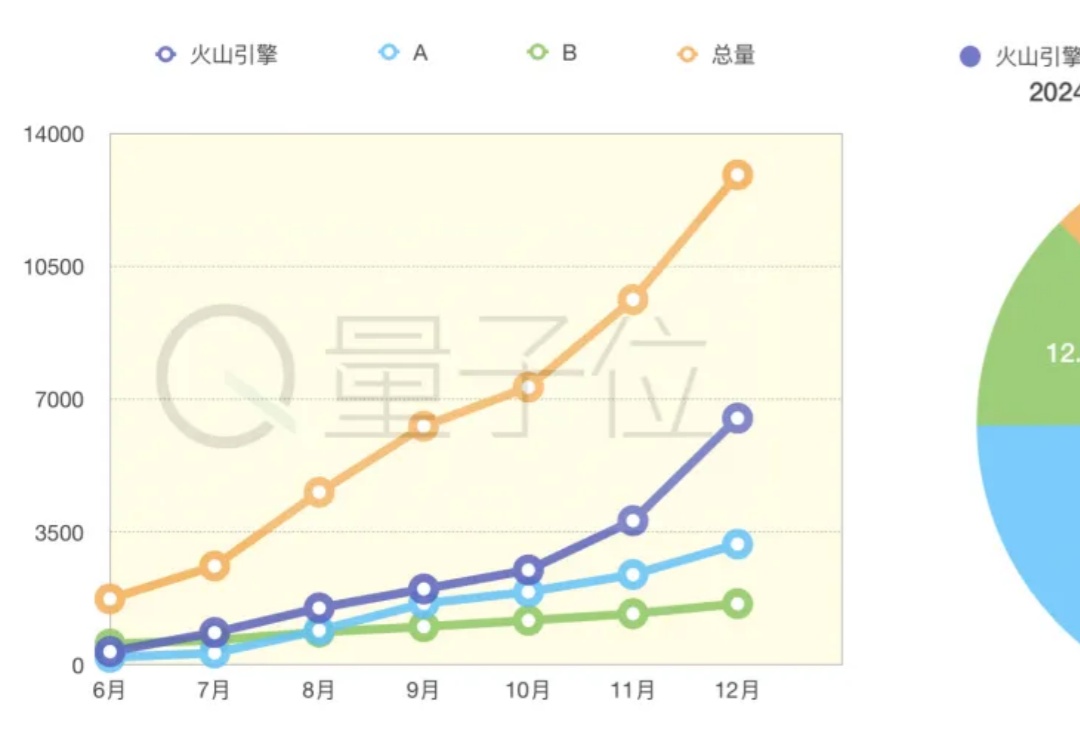

大模型应用落地元年,谁家业务更值得关注?

如果2023年给大模型的关键词是席卷,那么在2024,这个关键词应该是渗透。最常用的软件、手机PC本身、甚至厨卫/电源开源,都在被AI重塑。主观感受中,这一年,AI更加强大,以前所未有的速度嵌入各行各业。

很多大模型的官方参数都声称自己可以输出长达32K tokens的内容,但这数字实际上是存在水分的??

开源模型上下文窗口卷到超长,达400万token! 刚刚,“大模型六小强”之一MiniMax开源最新模型—— MiniMax-01系列,包含两个模型:基础语言模型MiniMax-Text-01、视觉多模态模型MiniMax-VL-01。