谷歌AI掌门人Jeff Dean对话Transformer作者:AI提速300%,1000万倍工程师要来了

谷歌AI掌门人Jeff Dean对话Transformer作者:AI提速300%,1000万倍工程师要来了谷歌首席科学家Jeff Dean与Transformer作者Noam Shazeer在一场访谈中不仅揭秘了让模型速度提升三倍的低精度计算技术,分享了「猫神经元」等早期AI突破的背后故事,还大胆畅想了AI处理万亿级别Token、实现「1000万倍工程师」的可能性。

谷歌首席科学家Jeff Dean与Transformer作者Noam Shazeer在一场访谈中不仅揭秘了让模型速度提升三倍的低精度计算技术,分享了「猫神经元」等早期AI突破的背后故事,还大胆畅想了AI处理万亿级别Token、实现「1000万倍工程师」的可能性。

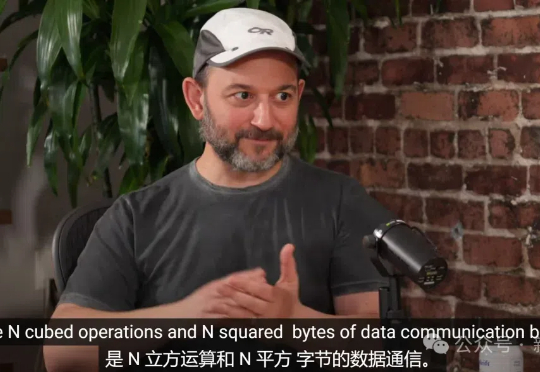

谷歌研究人员提出了一种创新的token拍卖模型,通过「竞拍」的方式,让智能体在文本生成过程中进行出价,确保最终输出能满足各方利益,实现最佳效果。这一机制优化了广告、内容创作等领域的协作。

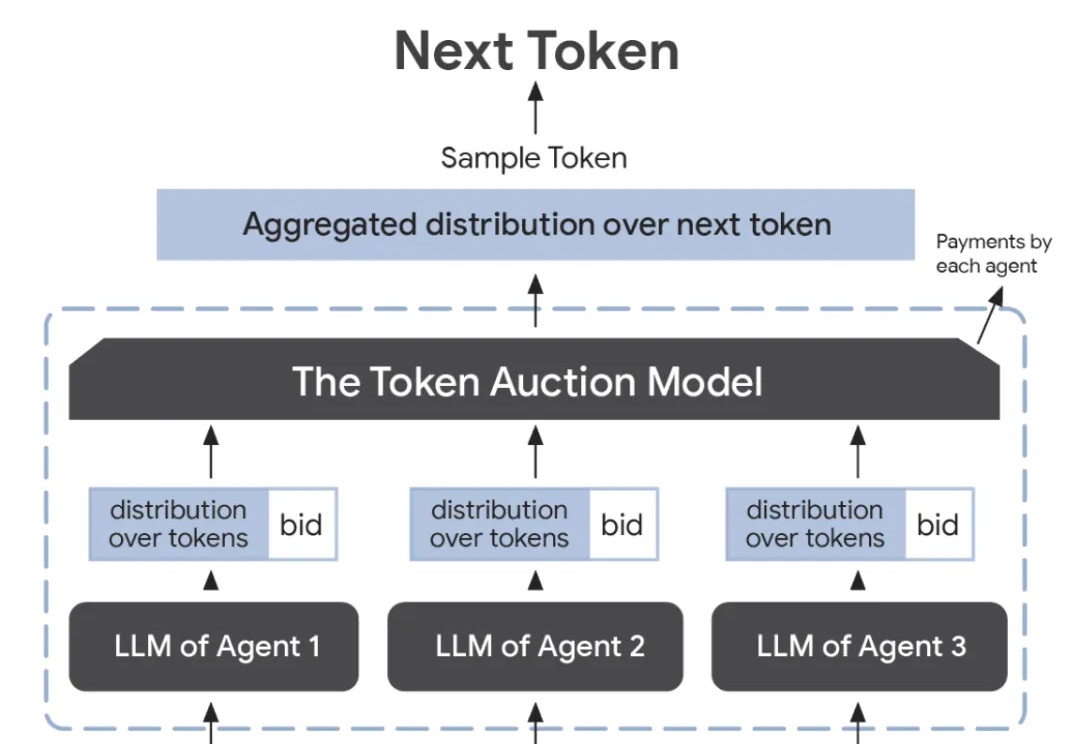

Transformer 架构在过去几年中通过注意力机制在多个领域(如计算机视觉、自然语言处理和长序列任务)中取得了非凡的成就。然而,其核心组件「自注意力机制」 的计算复杂度随输入 token 数量呈二次方增长,导致资源消耗巨大,难以扩展到更长的序列或更大的模型。

RedStone是一个高效构建大规模指定领域数据的处理管道,通过优化数据处理流程,从Common Crawl中提取了RedStone-Web、RedStone-Code、RedStone-Math和RedStone-QA等数据集,在多项任务中超越了现有开源数据集,显著提升了模型性能。

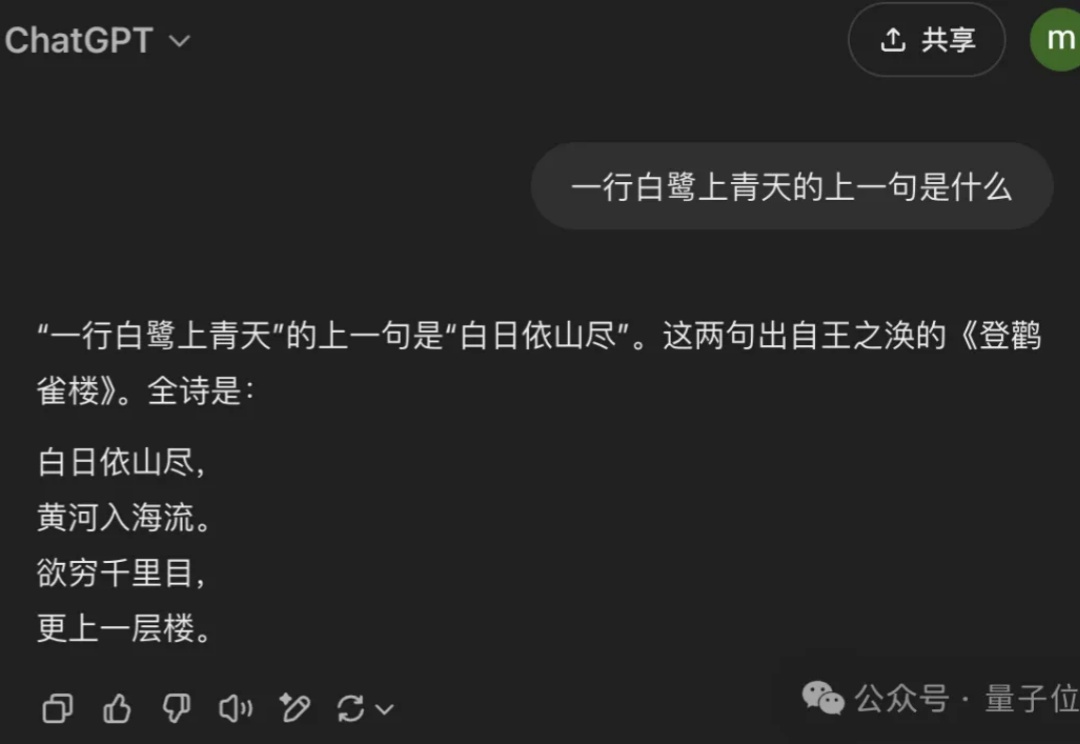

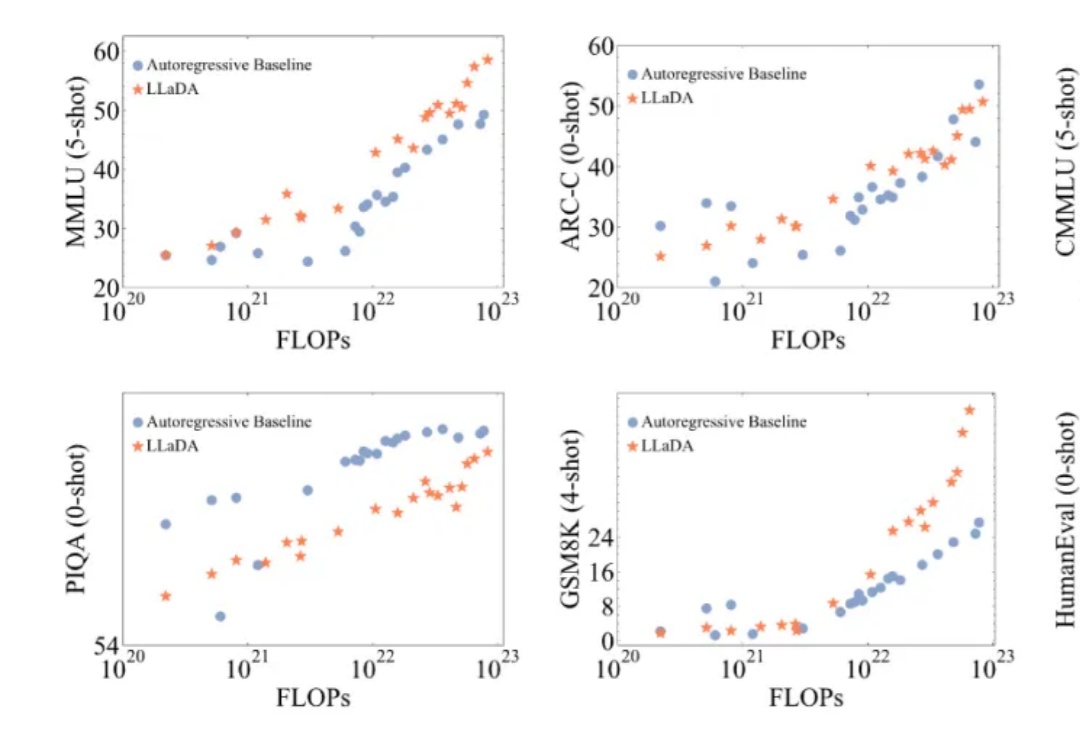

用扩散模型替代自回归,大模型的逆诅咒有解了!

近年来,大语言模型(LLMs)取得了突破性进展,展现了诸如上下文学习、指令遵循、推理和多轮对话等能力。目前,普遍的观点认为其成功依赖于自回归模型的「next token prediction」范式。

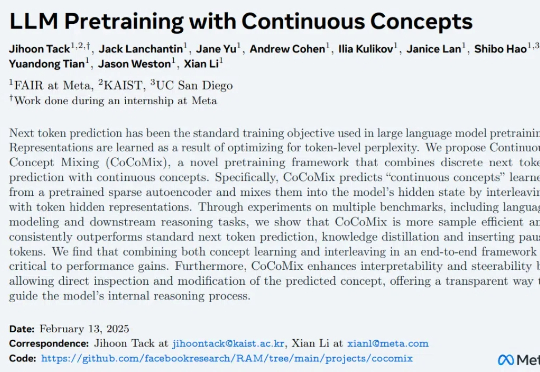

自然语言 token 代表的意思通常是表层的(例如 the 或 a 这样的功能性词汇),需要模型进行大量训练才能获得高级推理和对概念的理解能力,

一个简单的笑脸😀可能远不止这么简单?最近,AI大神Karpathy发现,一个😀竟然占用了多达53个token!这背后隐藏着Unicode编码的哪些秘密?如何利用这些「隐形字符」在文本中嵌入、传递甚至「隐藏」任意数据。更有趣的是,这种「数据隐藏术」甚至能对AI模型进行「提示注入」!

还在为 DeepSeek R1 官网的卡顿抓狂?无问芯穹大模型服务平台现已上线满血版 DeepSeek-R1、V3,无需邀请即可免费用 Token!另有异构算力鼎力相助,支持通过 Infini-AI 异构云平台一键获取 DeepSeek 系列模型与多元异构自主算力服务。

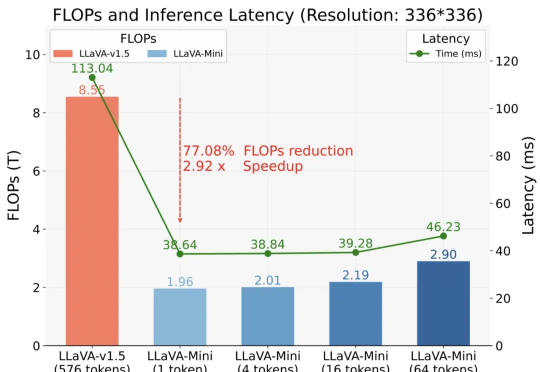

以 GPT-4o 为代表的实时交互多模态大模型(LMMs)引发了研究者对高效 LMM 的广泛关注。现有主流模型通过将视觉输入转化为大量视觉 tokens,并将其嵌入大语言模型(LLM)上下文来实现视觉信息理解。