思维链不存在了?纽约大学最新研究:推理步骤可「省略」

思维链不存在了?纽约大学最新研究:推理步骤可「省略」红极一时的思维链技术,可能要被推翻了!

红极一时的思维链技术,可能要被推翻了!

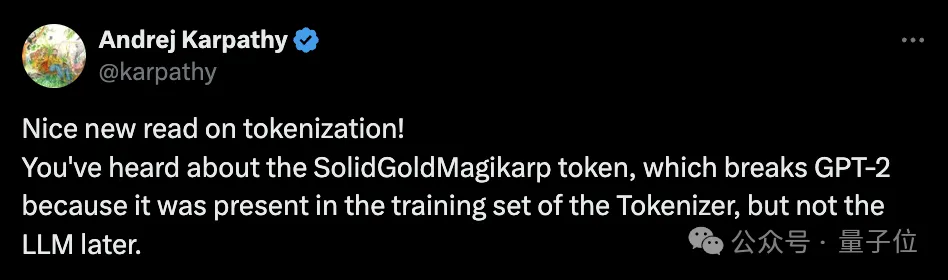

关于大模型分词(tokenization),大神Karpathy刚刚推荐了一篇必读新论文。

昨天刚刚在顶会ICLR作为特邀演讲(Invited Talk)中“国内唯一”的大模型玩家智谱AI,今天又放出了一个好消息

在刚刚举行的 ICLR 2024 大会上,智谱AI的大模型技术团队公布了面向激动人心的AGI通用人工智能前景的三大技术趋势,同时预告了GLM的后续升级版本。

传统上,大型语言模型(LLMs)被认为是顺序解码器,逐个解码每个token。

开源大模型领域,又迎来一位强有力的竞争者。

Meta最近开源的Llama 3模型再次证明了「数据」是提升性能的关键,但现状是,开源的大模型有一堆,可开源的大规模数据却没多少,而收集、清洗数据又是一项极其费时费力的工作,也导致了大模型预训练技术仍然掌握在少数高端机构的手中。

AI做数学题,真正的思考居然是暗中“心算”的?

“预测下一个token”被认为是大模型的基本范式,一次预测多个tokens又会怎样?

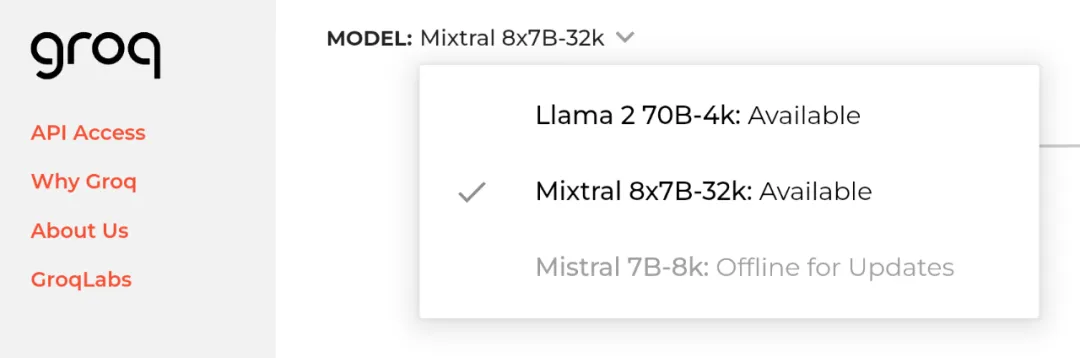

2024 年 4 月 20 日,即 Meta 开源 Llama 3 的隔天,初创公司 Groq 宣布其 LPU 推理引擎已部署 Llama 3 的 8B 和 70B 版本,每秒可输出token输提升至800。