百万tokens低至1元!大模型越来越卷了

百万tokens低至1元!大模型越来越卷了在刚刚举行的 ICLR 2024 大会上,智谱AI的大模型技术团队公布了面向激动人心的AGI通用人工智能前景的三大技术趋势,同时预告了GLM的后续升级版本。

在刚刚举行的 ICLR 2024 大会上,智谱AI的大模型技术团队公布了面向激动人心的AGI通用人工智能前景的三大技术趋势,同时预告了GLM的后续升级版本。

Meta最近开源的Llama 3模型再次证明了「数据」是提升性能的关键,但现状是,开源的大模型有一堆,可开源的大规模数据却没多少,而收集、清洗数据又是一项极其费时费力的工作,也导致了大模型预训练技术仍然掌握在少数高端机构的手中。

“预测下一个token”被认为是大模型的基本范式,一次预测多个tokens又会怎样?

百亿token补贴,4月起免费!这次的羊毛来自清华系AI公司无问芯穹,企业与个人皆可薅~这家公司成立于2023年5月,目标是打造大模型软硬件一体化最佳算力解决方案。

这两天,Groq惊艳亮相。它以号称“性价比高英伟达100倍”的芯片,实现每秒500tokens大模型生成,感受不到任何延迟。外加谷歌TPU团队这样一个高精尖人才Buff,让不少人直呼:英伟达要被碾压了……

大模型提速,抢走英伟达饭碗

一个体量仅为2B的大模型,能有什么用?答案可能超出你的想象。

2B性能小钢炮来了!刚刚,面壁智能重磅开源了旗舰级端侧多模态模型MiniCPM,2B就能赶超Mistral-7B,还能越级比肩Llama2-13B。成本更是低到炸裂,170万tokens成本仅为1元!

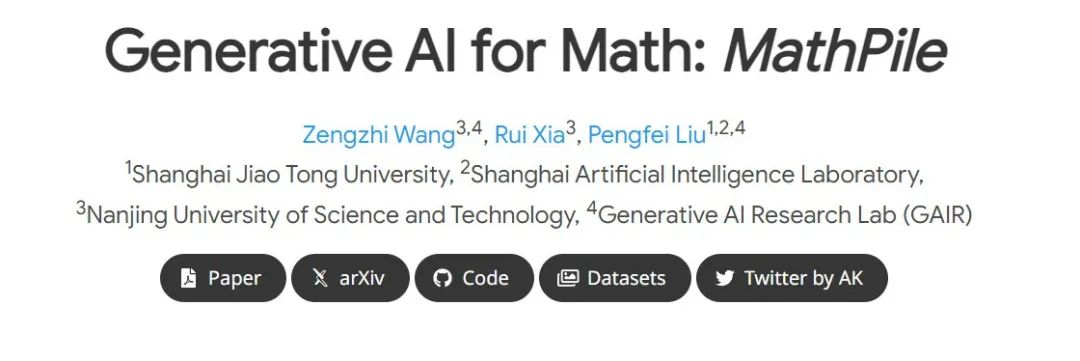

当前智能对话模型的发展中,强大的底层模型起着至关重要的作用。这些先进模型的预训练往往依赖于高质量且多样化的语料库,而如何构建这样的语料库,已成为行业中的一大挑战。

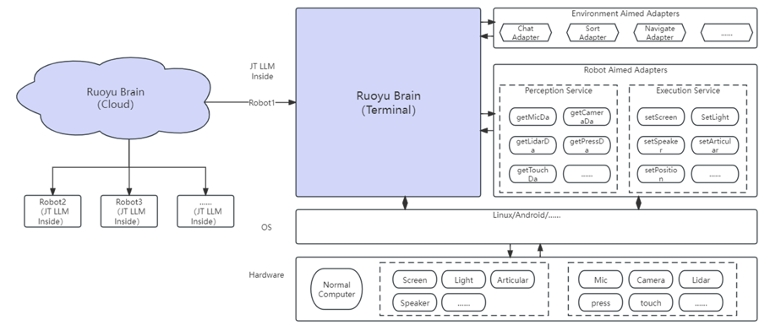

若愚科技与哈工深联合研发了语言大模型基座---立知和多模态大模型基座---九天,总参数规模达130亿,训练数据超1500B tokens, 能完成多任务、多轮对话、中英翻译、思维链、工具使用等多种类型的指令数据