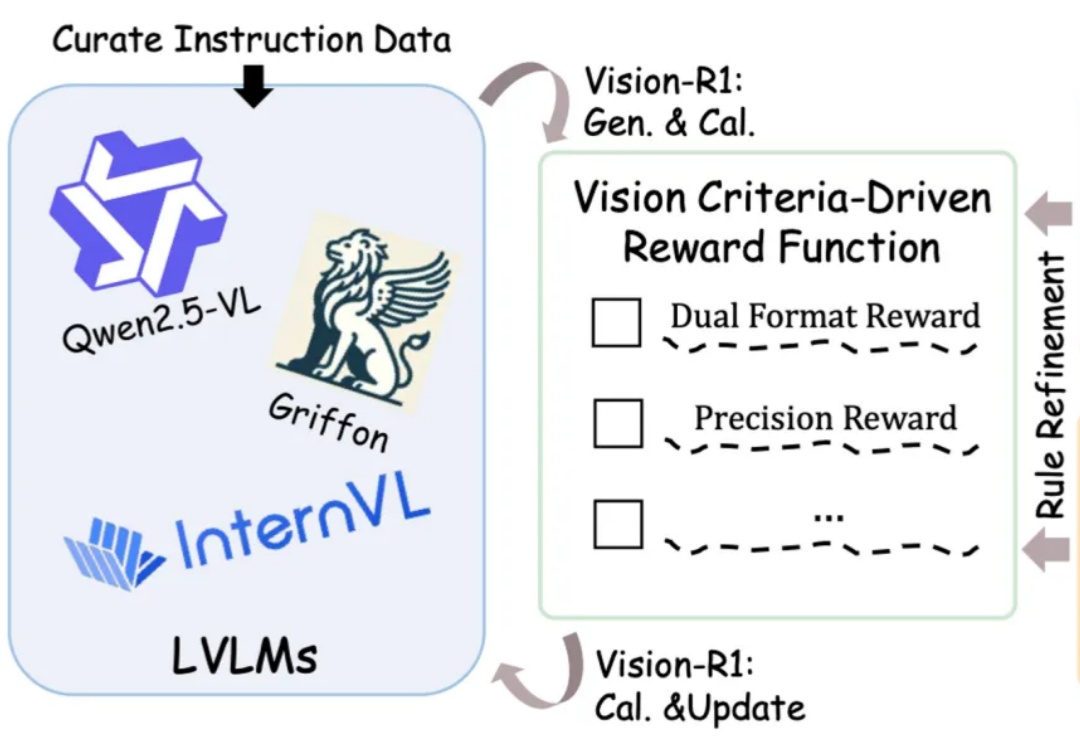

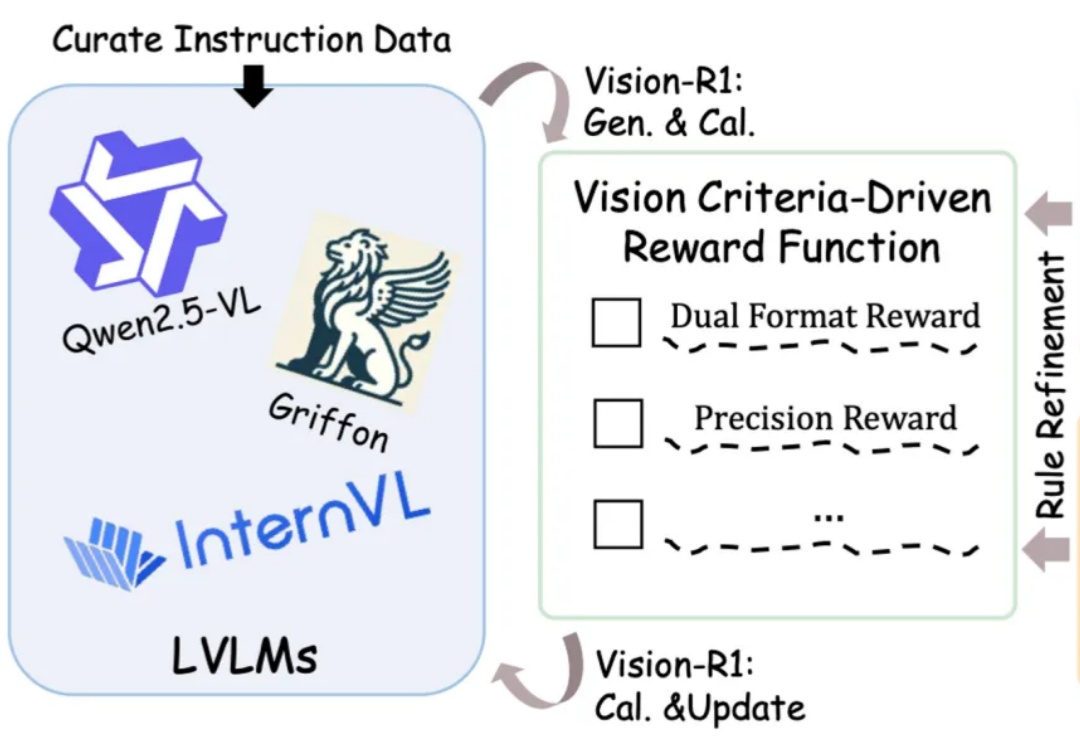

类R1强化学习迁移到视觉定位!全开源Vision-R1将图文大模型性能提升50%

类R1强化学习迁移到视觉定位!全开源Vision-R1将图文大模型性能提升50%图文大模型通常采用「预训练 + 监督微调」的两阶段范式进行训练,以强化其指令跟随能力。受语言领域的启发,多模态偏好优化技术凭借其在数据效率和性能增益方面的优势,被广泛用于对齐人类偏好。目前,该技术主要依赖高质量的偏好数据标注和精准的奖励模型训练来提升模型表现。然而,这一方法不仅资源消耗巨大,训练过程仍然极具挑战。

图文大模型通常采用「预训练 + 监督微调」的两阶段范式进行训练,以强化其指令跟随能力。受语言领域的启发,多模态偏好优化技术凭借其在数据效率和性能增益方面的优势,被广泛用于对齐人类偏好。目前,该技术主要依赖高质量的偏好数据标注和精准的奖励模型训练来提升模型表现。然而,这一方法不仅资源消耗巨大,训练过程仍然极具挑战。

据 The Information 报道,Glean,一家为企业开发搜索聊天机器人的公司 ,正在与投资者进行谈判,可能筹集数亿美元的新融资,包括用于在招标中回购员工股份的资金。

「未来,99% 的 attention 将是大模型 attention,而不是人类 attention。」这是 AI 大牛 Andrej Karpathy 前段时间的一个预言。这里的「attention」可以理解为对内容的需求、处理和分析。也就是说,他预测未来绝大多数资料的处理工作将由大模型来完成,而不是人类。

对新型药物疗法的发现和开发的需求不断增长,以及生命科学行业制造能力的不断提高,正在催生药物发现过程中对人工智能解决方案的需求。

就在刚刚,Higgsfiled AI推出Motion Controls AI视频生成,在模仿电影级别的动作捕捉删上取得了新进展!不论是是360度环绕拍摄还是子弹时间都是信手拈来,从此就像口袋里装着一个「摄影组」,电影级别的画面也可以由AI代劳。

本文介绍了 FoundationStereo,一种用于立体深度估计的基础模型,旨在实现强大的零样本泛化能力。

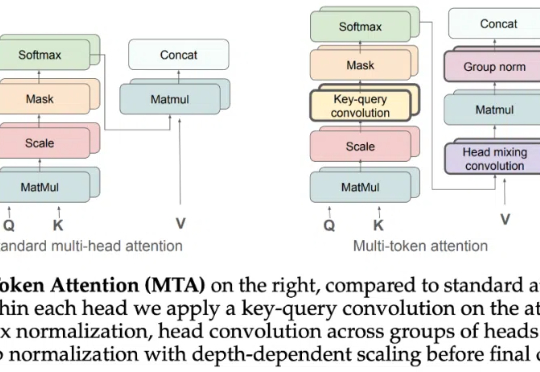

Attention 还在卷自己。

4 月 3 日消息,当地时间周三,Anthropic 发布了“Claude for Education”计划,宣布正式进军高等教育市场,以应对 OpenAI 的 ChatGPT Edu 方案。该计划将为高校师生和工作人员提供 Claude AI 聊天机器人,并额外配备一系列专门功能。

近来风头正盛的GPT-4.5,不仅在日常问答中展现出惊人的上下文连贯性,在设计、咨询等需要高度创造力的任务中也大放异彩。

之前靠AI作弊神器横扫大厂offer的小哥,最近有新后续了:创业成功,月入22.85万美元,走上人生巅峰。与此同时,大厂的面试官们可是被折腾惨了,直言技术面试已被摧毁!