一个极度实用的Prompt,帮你挖掘出自己的隐藏天赋。

一个极度实用的Prompt,帮你挖掘出自己的隐藏天赋。最绝望的事,莫过于,错过了自己那个本该精彩的人生。所以,我突然有一个想法,就是AI明明现在都这么强了。那,为什么不可以,帮我挖掘我们自己真正的天赋呢?说干就干,在花了一下午时间,迭代了好多版Prompt之后。

最绝望的事,莫过于,错过了自己那个本该精彩的人生。所以,我突然有一个想法,就是AI明明现在都这么强了。那,为什么不可以,帮我挖掘我们自己真正的天赋呢?说干就干,在花了一下午时间,迭代了好多版Prompt之后。

用零手写代码、零成本、零部署压力的“三无”AI生成应用,把Prompt换成真金白银的第一批“野生开发者”已经出现了。

正如奥特曼执意打造硬件,试图打破手机屏束缚,要让 AI 感受物理世界;Looki 的诞生也源于同样的渴望:补齐大模型「感官智能」的最后拼图,将现实场景实时转化为上下文,驱动人机交互从「被动问答」进化为「主动共鸣」。

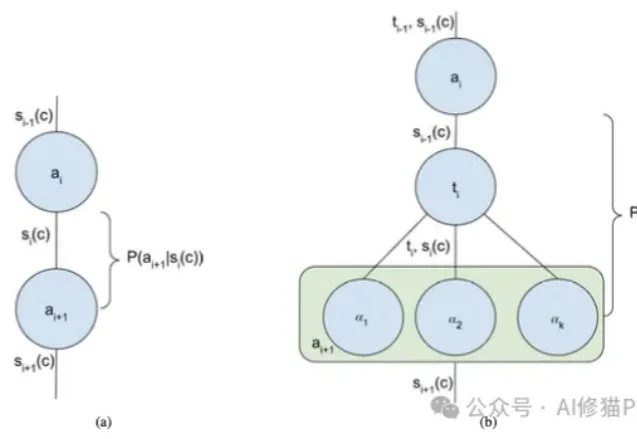

我们正处在一个AI Agent(智能体)爆发的时代。从简单的ReAct循环到复杂的Multi-Agent Swarm(多智能体蜂群),新的架构层出不穷。但在这些眼花缭乱的名词背后,开发者的工作往往更像是一门“玄学”,我们凭直觉调整提示词,凭经验增加Agent的数量,却很难说清楚为什么某个架构在特定任务上表现更好。

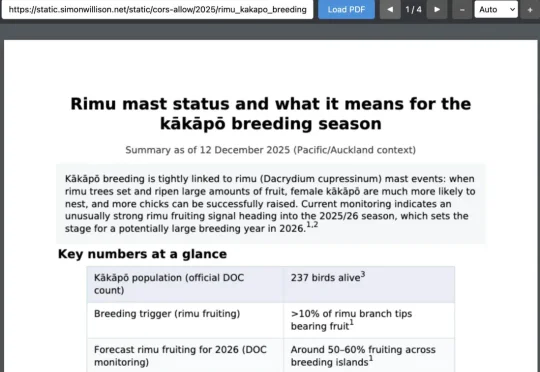

还在争论Skills是不是prompt?已经可以停下火了。因为,刚刚得到的消息消息,OpenAI已经悄悄地用上了Skills了。今天,知名博主、Django Web 框架联合创始人Simon Willson爆料:

宾夕法尼亚大学沃顿商学院(The Wharton School)今年发布了一系列名为《Prompting Science Reports》的重磅研究报告。他们选取了2024-2025最常用的模型(如GPT-4o, Claude 3.5 Sonnet, Gemini Pro/Flash等),在极高难度的博士级基准测试(GPQA Diamond)上进行了数万次的严谨测试。

最近口述采样很火。如果您经常使用经过“对齐”训练(如RLHF)的LLM,您可能已经注意到一个现象:模型虽然变得听话、安全了,但也变得巨“无聊”。

ChatGPT发布三周年,OpenAI没发布,各大AI玩家倒纷纷整出大活。

2025 年,AI 视频又把桌子掀了。手切金属、小猫做饭,甚至是那个火遍全网的「奥特曼宇宙」,对 AI 来说不过是几句 Prompt 的功夫。

如果告诉你,仅仅改变提示词(Prompt)的结构,就能让大模型在复杂推理任务上的表现暴涨 60%,你相信吗?