5 亿 ARR的Cursor,已经没人讨论它了?

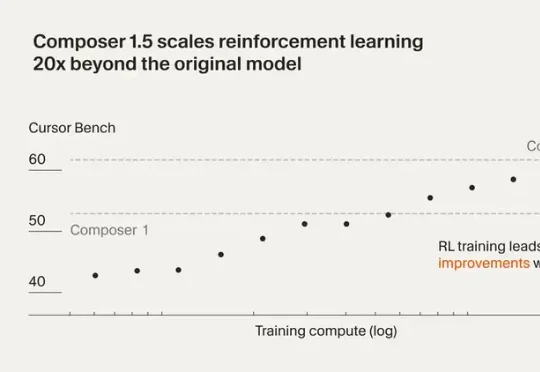

5 亿 ARR的Cursor,已经没人讨论它了?最近Cursor 发布了 Composer 1.5。这一版把强化学习规模扩大了 20 倍,后训练计算量甚至超过了基座模型的预训练投入。还加了 thinking tokens 和自我摘要机制,让模型能在复杂编程任务里做更深度的推理。

最近Cursor 发布了 Composer 1.5。这一版把强化学习规模扩大了 20 倍,后训练计算量甚至超过了基座模型的预训练投入。还加了 thinking tokens 和自我摘要机制,让模型能在复杂编程任务里做更深度的推理。

刚刚推出的一款最新芯片,直接冲上硅谷热榜。峰值推理速度高达每秒17000个token。什么概念呢?当前公认最强的Cerebras,速度约为2000 token/s。 速度直接快10倍,同时成本骤减20倍、功耗降低10倍。

这次是 Anthropic,率先发布了他们称之为「我们目前能力最强的 Sonnet 模型」Claude Sonnet 4.6。Claude 称,新模型对编码、计算机使用、长上下文推理、智能体规划、知识工作和设计进行了全面升级。

结果今天就等到豆包全家族了。Seedance 2.0都把贾樟柯干Fomo了,现在又上了个最全面的多模态Agent模型,还有人管管字节吗?Seed团队跳动得停不下来了💃烧的全是火山引擎上的Tokens,同时火山引擎上已经有豆包2.0系列的API了。

OpenAI深夜突袭,GPT-5.3-Codex-Spark正式炸场。核心卖点只有一个:快!每秒1000个token,让代码生成告别加载条。联手Cerebras怪兽级硬件,物理外挂直接拉满。这不再是简单的工具升级。而是一场关于速度的暴力美学。

确认了!DeepSeek昨晚官宣网页版、APP更新,支持100k token上下文。如今,全网都在蹲DeepSeek V4了。

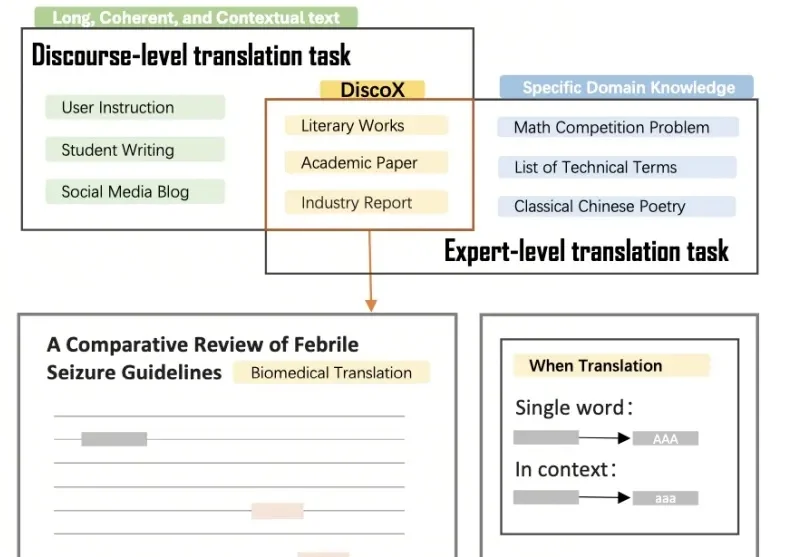

DiscoX构建了一套200题的长文翻译数据集,以平均长度1,712 tokens的长篇章做评测单元,要求整个长文文本作为一个整体来翻译,除翻译准确度外,重点考察跨段落的逻辑与风格一致性、上下文中的术语精确性、以及专业写作规范,贴合用户真实的使用场景。

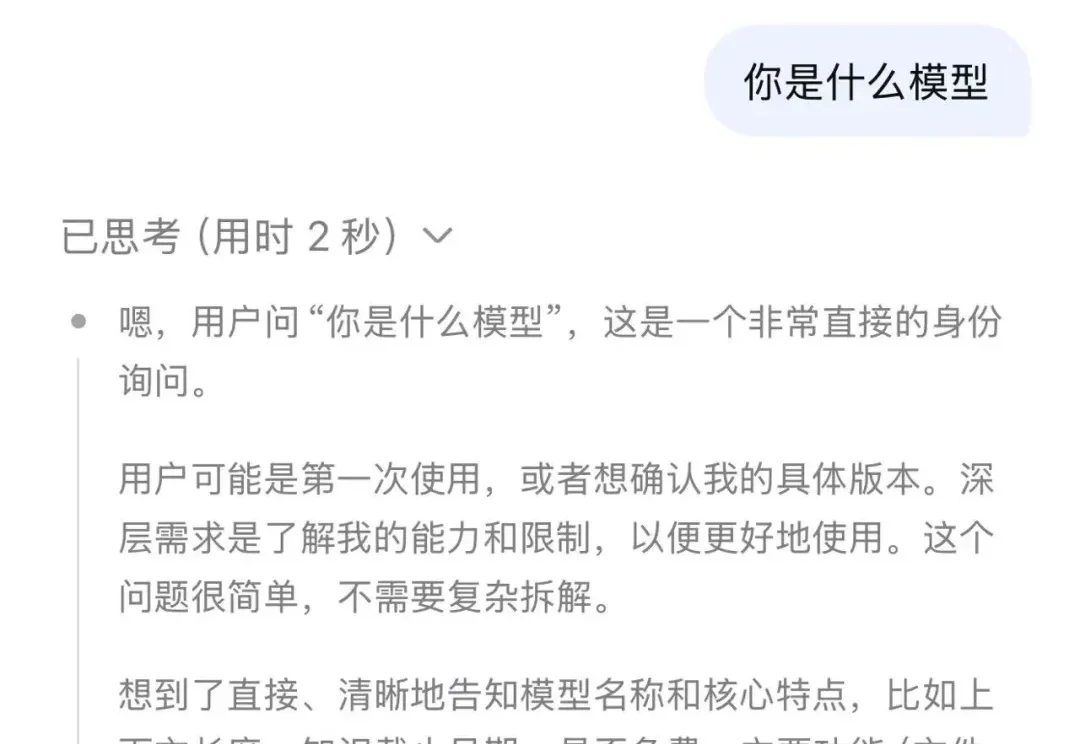

这两天 AI 圈真的太热闹了,就在网传 DeepSeek 要更新支持 100 万 Token 上下文的新模型时,MiniMax 率先冲锋,更新了他们的新旗舰模型:MiniMax-M2.5。更有意思的是,国外网友这段时间对国内 AI 大模型的更新节奏格外关注,他们甚至把这种争先更新的现象称为:Happy Chinese new year!

春节假期还没到,DeepSeek 就先把礼物拆了一半。

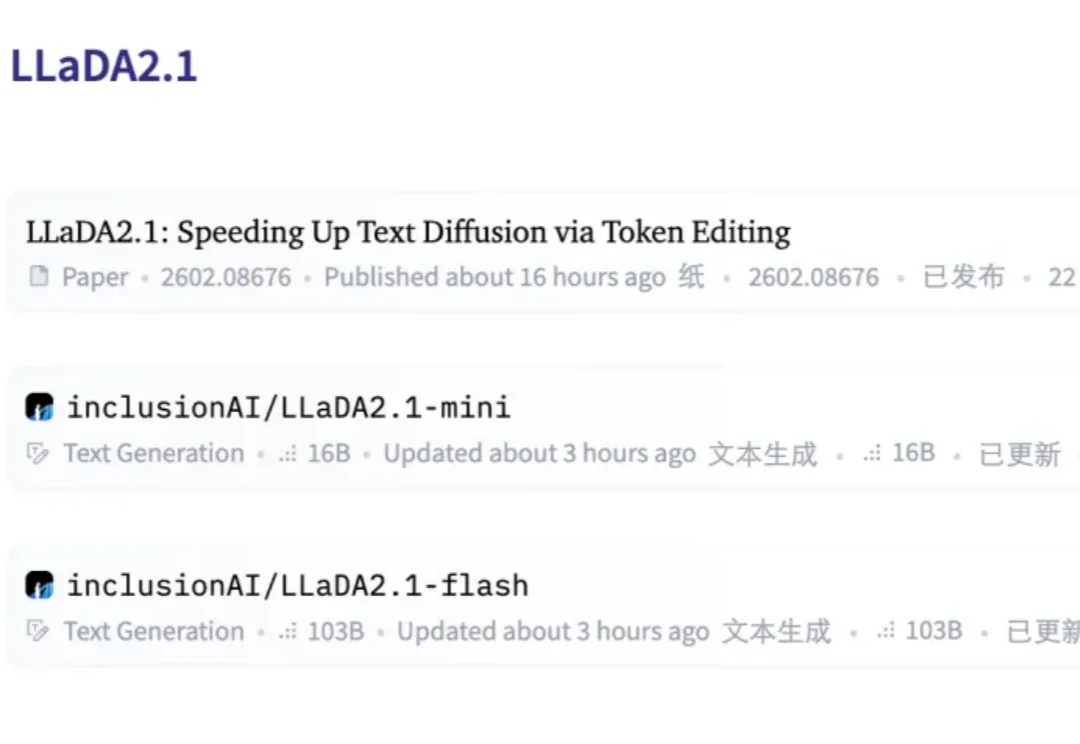

扩散语言模型(dLLM),这个曾被认为是「小众赛道」的研究方向,如今终于迎来了质变。