“最美产品经理”宋紫薇,创业AI硬件首款产品曝光

“最美产品经理”宋紫薇,创业AI硬件首款产品曝光前vivo「最美产品经理」宋紫薇,AI创业细节进一步曝光了。量子位获悉,已经入局AI智能硬件赛道创业的宋紫薇,瞄准的是「AI化妆镜」。公开信息显示,薇光点亮成立于2024年11月,自一开始便将目光瞄向了AI硬件——并且还是“时尚”和“年轻”的硬件。

前vivo「最美产品经理」宋紫薇,AI创业细节进一步曝光了。量子位获悉,已经入局AI智能硬件赛道创业的宋紫薇,瞄准的是「AI化妆镜」。公开信息显示,薇光点亮成立于2024年11月,自一开始便将目光瞄向了AI硬件——并且还是“时尚”和“年轻”的硬件。

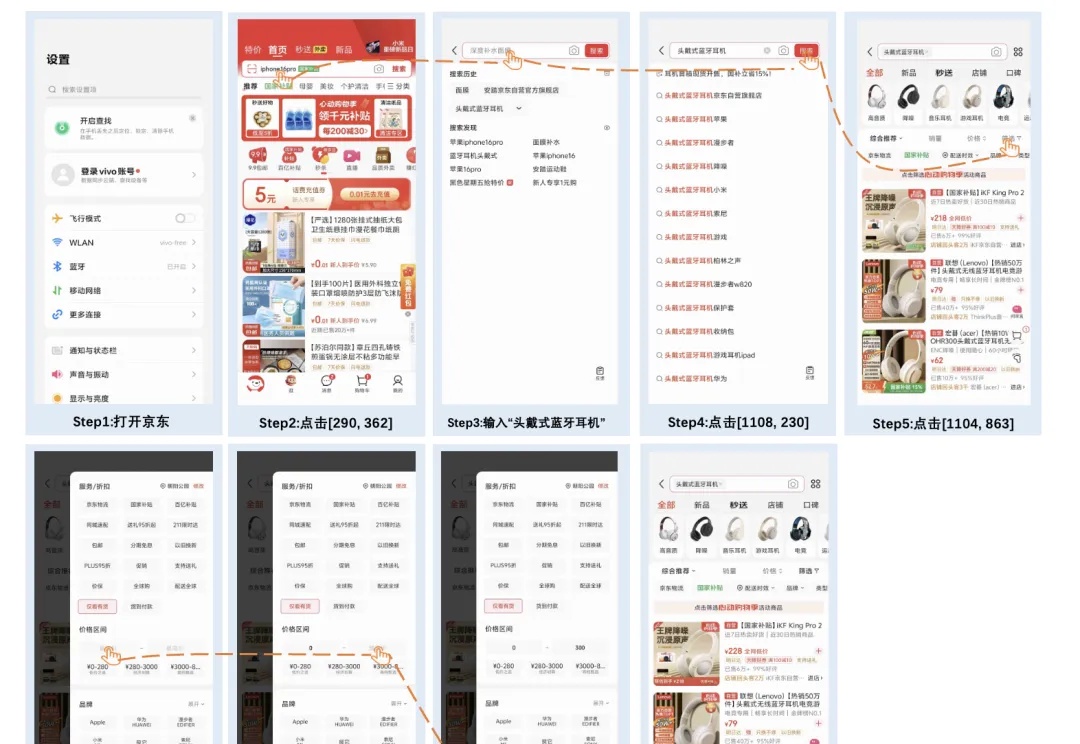

机器之心报道 编辑:泽南 真正实用化的生成式 AI,应该是这个样子 —— 作为助手可以帮你代打电话,根据你的选项进行应答,还能引导对方转人工: 功能覆盖多个场景,连接大量第三方应用,实现多智能体的一键

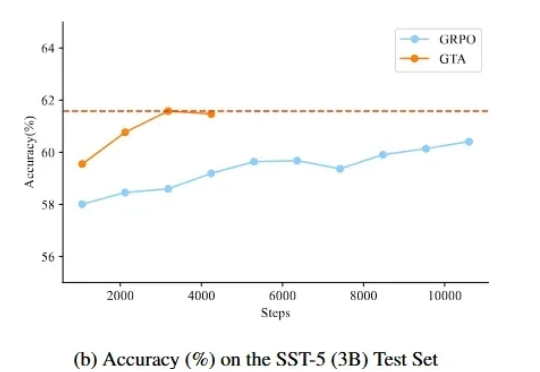

监督微调(SFT)和强化学习(RL)微调是大模型后训练常见的两种手段。通过强化学习微调大模型在众多 NLP 场景都取得了较好的进展,但是在文本分类场景,强化学习未取得较大的进展,其表现往往不如监督学习。

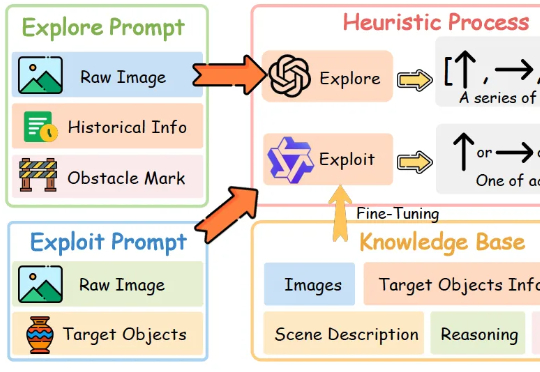

让机器人像人一样边看边理解,来自浙江大学和vivo人工智能实验室的研究团队带来了新进展。

vivo AI Lab发布AI多模态新模型了,专门面向端侧设计,紧凑高效~

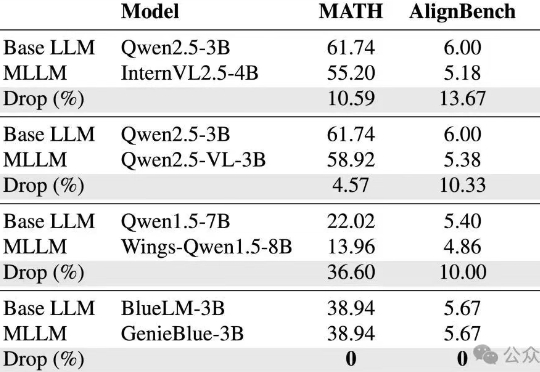

vivo AI研究院联合港中文以及上交团队为了攻克这些难题,从训练数据和模型结构两方面,系统性地分析了如何在MLLM训练中维持纯语言能力,并基于此提出了GenieBlue——专为移动端手机NPU设计的高效MLLM结构方案。

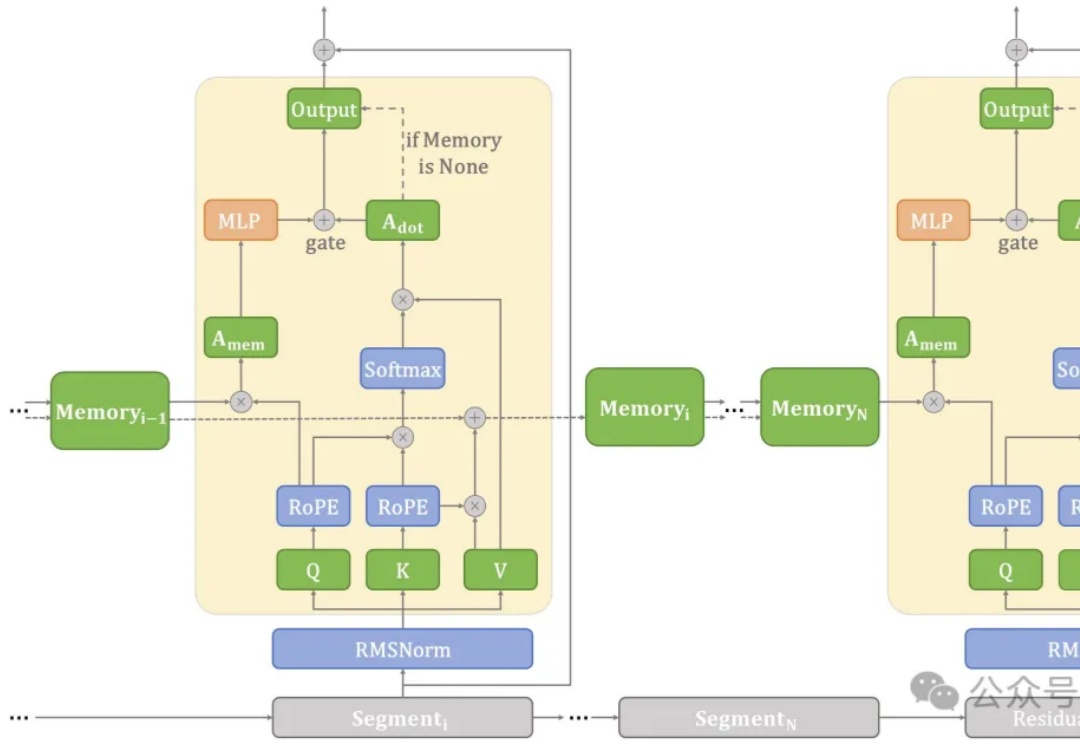

在端侧设备上处理长文本常常面临计算和内存瓶颈。

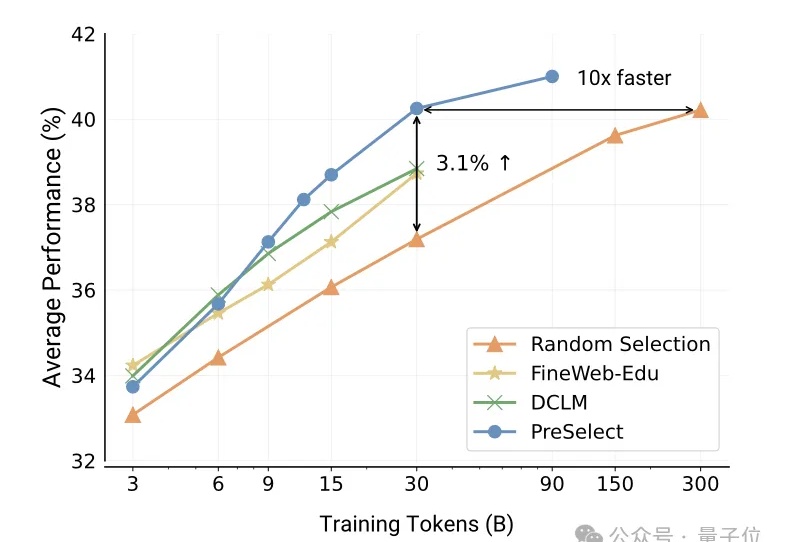

vivo自研大模型用的数据筛选方法,公开了。

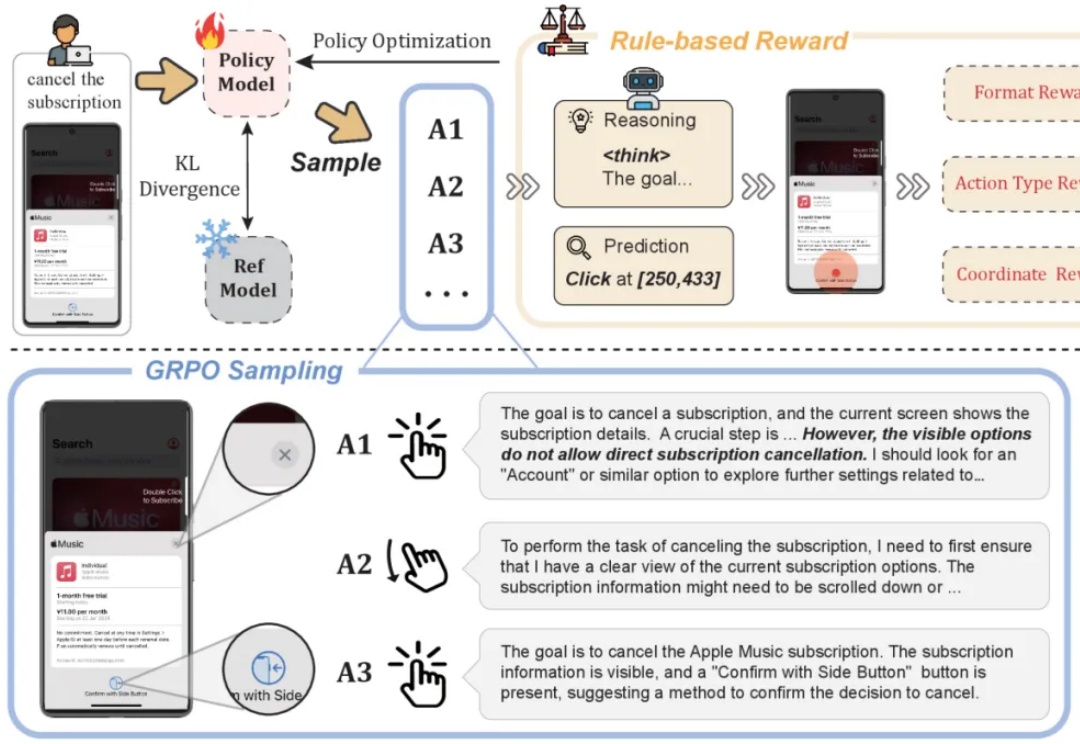

基于规则的强化学习(RL/RFT)已成为替代 SFT 的高效方案,仅需少量样本即可提升模型在特定任务中的表现。

构建机器人的「眼睛」和「大脑」,vivo 其实早有准备。