速度秒杀GPT-4o!Mistral开源首个22B代码模型破记录,支持80+编程语言

速度秒杀GPT-4o!Mistral开源首个22B代码模型破记录,支持80+编程语言就在刚刚,法国AI初创公司Mistral发布了自家首款代码生成模型Codestral。不仅支持32K长上下文窗口以及80多种编程语言,而且还用22B的参数量取得了与70B的Llama 3相近的性能。目前,已经开放API与IDE插件供用户使用。

就在刚刚,法国AI初创公司Mistral发布了自家首款代码生成模型Codestral。不仅支持32K长上下文窗口以及80多种编程语言,而且还用22B的参数量取得了与70B的Llama 3相近的性能。目前,已经开放API与IDE插件供用户使用。

GPT-4在为人类选股时,表现竟然超越了大部分人类分析师,和针对金融训练的专业模型?在没有任何上下文的情况下,它们直接就成功分析了财务报表,这一发现让许多业内大咖震惊了。然而好景不长,有AI大牛指出研究中的bug:之所以会这样,很可能是训练数据被污染了。

既能像 Transformer 一样并行训练,推理时内存需求又不随 token 数线性递增,长上下文又有新思路了?

起了个大早,赶了个晚集的谷歌,AI时代还有没有机会?

秀杀手级AI玩法、Gemini安卓合体截胡苹果、最强TPU,谷歌2小时提了121次AI。

昨天刚刚在顶会ICLR作为特邀演讲(Invited Talk)中“国内唯一”的大模型玩家智谱AI,今天又放出了一个好消息

在刚刚举行的 ICLR 2024 大会上,智谱AI的大模型技术团队公布了面向激动人心的AGI通用人工智能前景的三大技术趋势,同时预告了GLM的后续升级版本。

堂堂开源之王Llama 3,原版上下文窗口居然只有……8k,让到嘴边的一句“真香”又咽回去了。

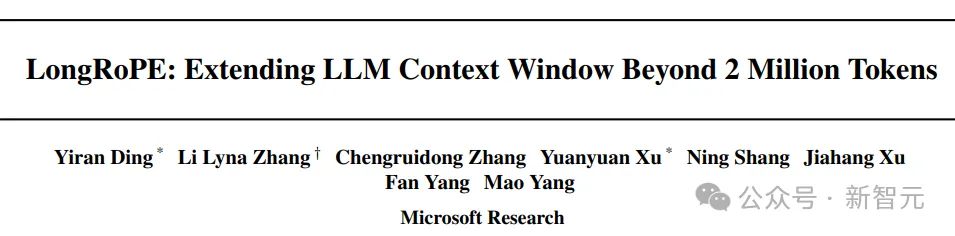

大型语言模型(LLM)往往会追求更长的「上下文窗口」,但由于微调成本高、长文本稀缺以及新token位置引入的灾难值(catastrophic values)等问题,目前模型的上下文窗口大多不超过128k个token

继Mamba之后,又一敢于挑战Transformer的架构诞生了!