“不是...而是...”刷屏的一年,我读内容的快乐被AI偷走了。

“不是...而是...”刷屏的一年,我读内容的快乐被AI偷走了。这两天有点摸鱼,因为我终于把《怪奇物语》第五季给补完了。

这两天有点摸鱼,因为我终于把《怪奇物语》第五季给补完了。

从夯到拉,给AI各环节排序!回顾2025年,科技成为A股的主线。在科技领域中,最亮眼的莫过于AI板块。其中,“易中天”(新易盛、中际旭创、天孚通信)、“纪连海”(寒武纪、工业富联、海光信息)等AI算力板块托起了科技投资的脊梁。而AI应用、AI端侧等涨幅不如AI算力。

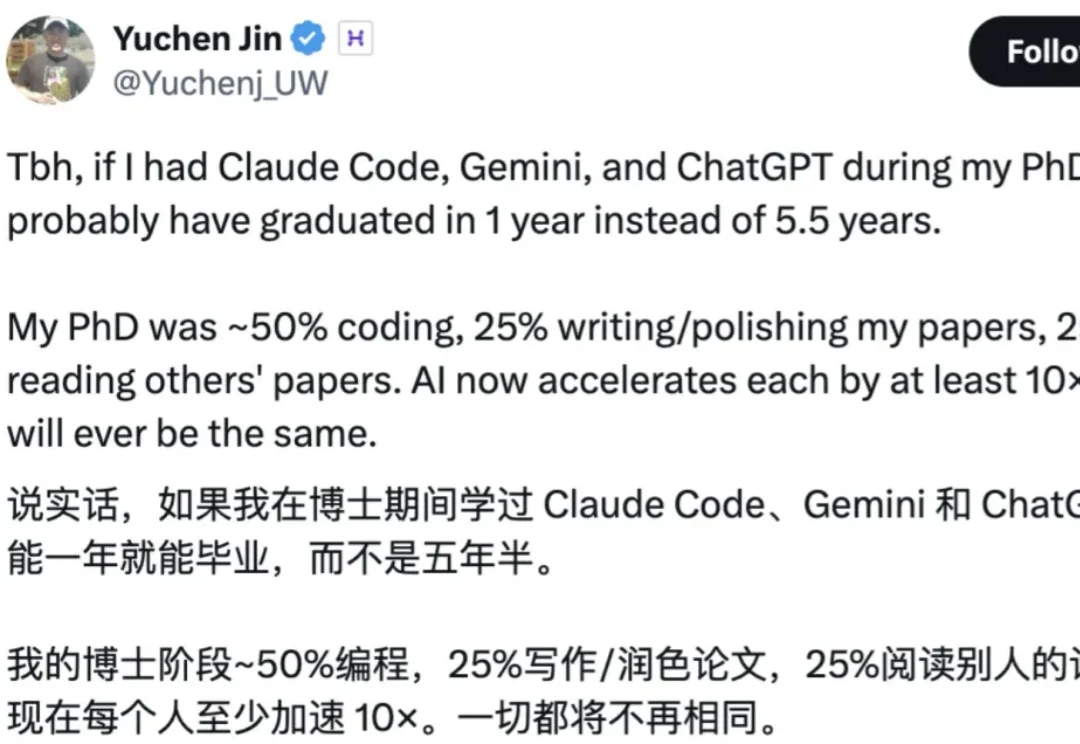

近日,X 知名博主、Hyperbolic 联创 & CEO Yuchen Jin 发帖称,如果在他读博士的时候就有 Claude Code、Gemini 和 ChatGPT 等各类 AI 工具出现,那么也许只要一年就能毕业,而不是用了 5.5 年。

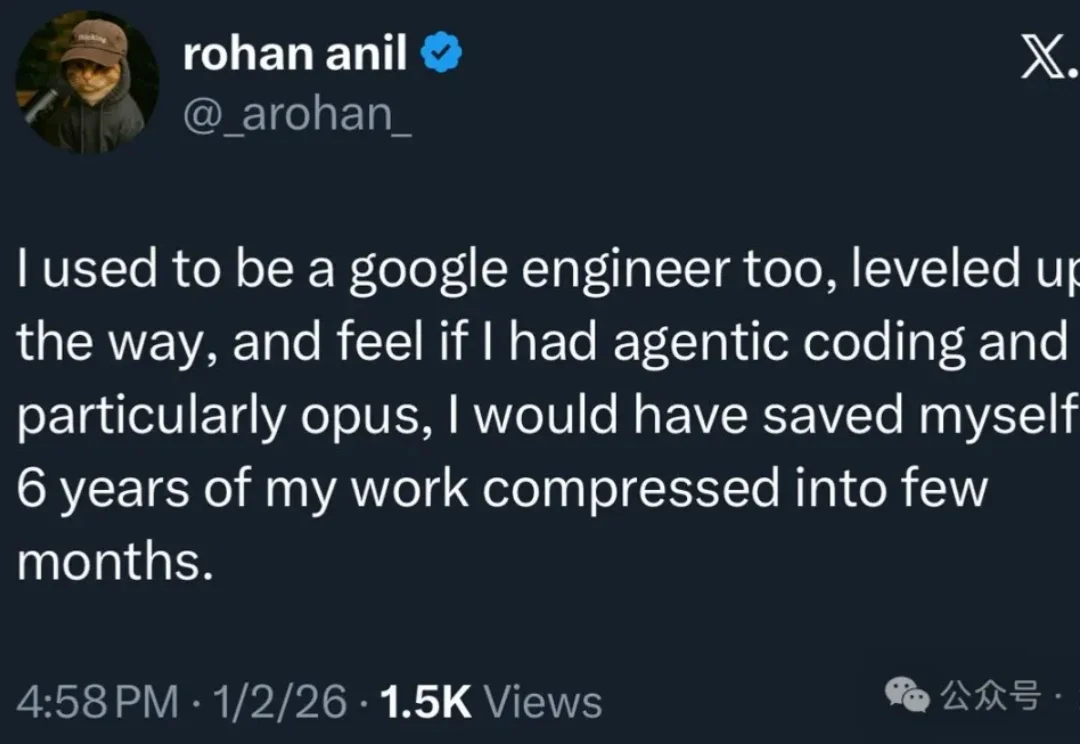

以防你不知道编程Agent现在有多强,硅谷大佬们新年收假回来,纷纷写起了小作文。

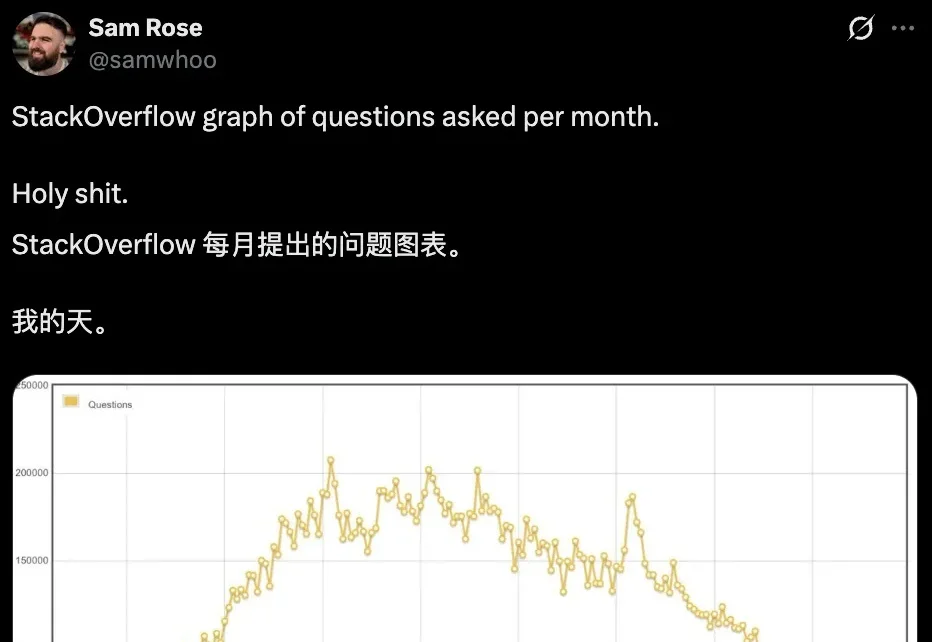

比诞生之初还冷清,Stack Overflow彻底凉透了!

不久前,Zilliz 研发VP栾小凡受邀做客英文播客节目Innovator Coffee,深度分享了 Zilliz 的创业历程、Milvus 产品的构建逻辑与核心设计思路,以下为本次分享的重点内容摘编。

DeepSeek-OCR的视觉文本压缩(VTC)技术通过将文本编码为视觉Token,实现高达10倍的压缩率,大幅降低大模型处理长文本的成本。但是,视觉语言模型能否理解压缩后的高密度信息?中科院自动化所等推出VTCBench基准测试,评估模型在视觉空间中的认知极限,包括信息检索、关联推理和长期记忆三大任务。

Shraman Kar 还记得那个改变一切的 Arduino 套件。那年他大概七八岁,哥哥 Shreyas 比他大一岁,两人在父母的客厅里拆开包装,第一次接触到可以用代码控制的电子元件。

AI进入“90后”领军时代。

昨天我在沈阳大街遗址和刀哥握手了,很开心,今天来锐评一下智谱和MiniMax的IPO。