100根内存条换一套房!AI疯狂吞噬全球内存,普通人电脑快买不起了

100根内存条换一套房!AI疯狂吞噬全球内存,普通人电脑快买不起了当巨头疯狂扫货、分析师开始囤iPhone17,你的钱包、电脑和AGI的未来,正在被同一堵看不见的墙悄悄卡住。

当巨头疯狂扫货、分析师开始囤iPhone17,你的钱包、电脑和AGI的未来,正在被同一堵看不见的墙悄悄卡住。

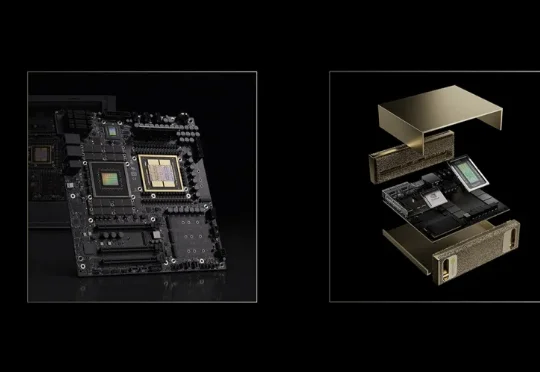

本次发布的核心——AIMesh,正是这场架构创新的集大成者。 它被定义为面向「AI工厂」的数据与内存网,核心思路是用一套「三网合一」的柔性网络,替代传统僵化的存储架构。

如果人类的大脑像现在的LLM Agent一样工作,记住每一句今天明天的废话,我们在五岁时就会因为内存溢出而宕机。真正的智能,核心不在于“存储”,而在于高效的“遗忘”与“重组”。

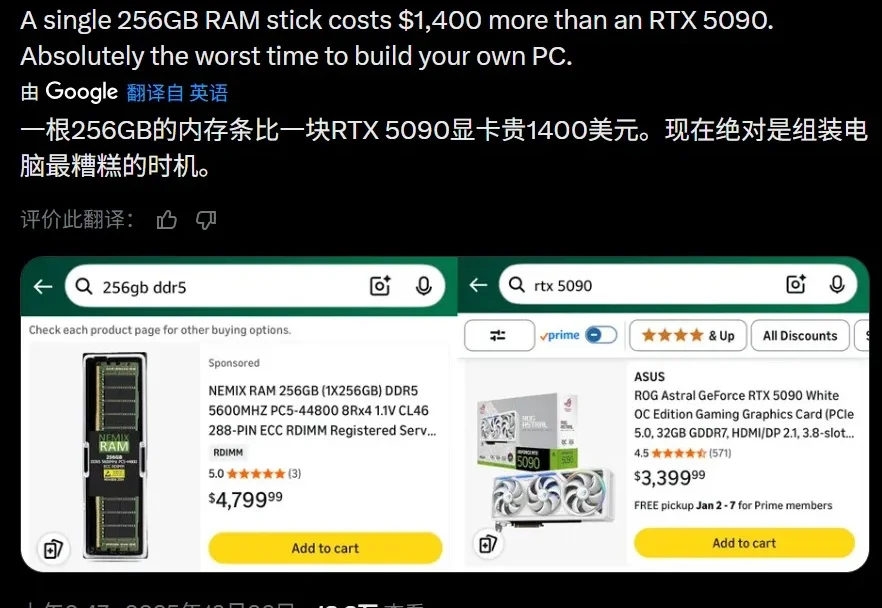

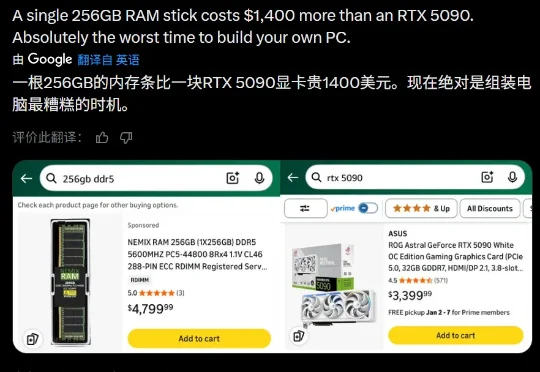

目前最新的消费级 GPU,还是去年在 CES 上正式发布的 RTX 50 系列。其中必然有内存全球大涨价的原因,当前市场的内存成本,一周之内就能涨价 50%-100%,并且多个分析机构表示,涨价会持续到 2027 年。

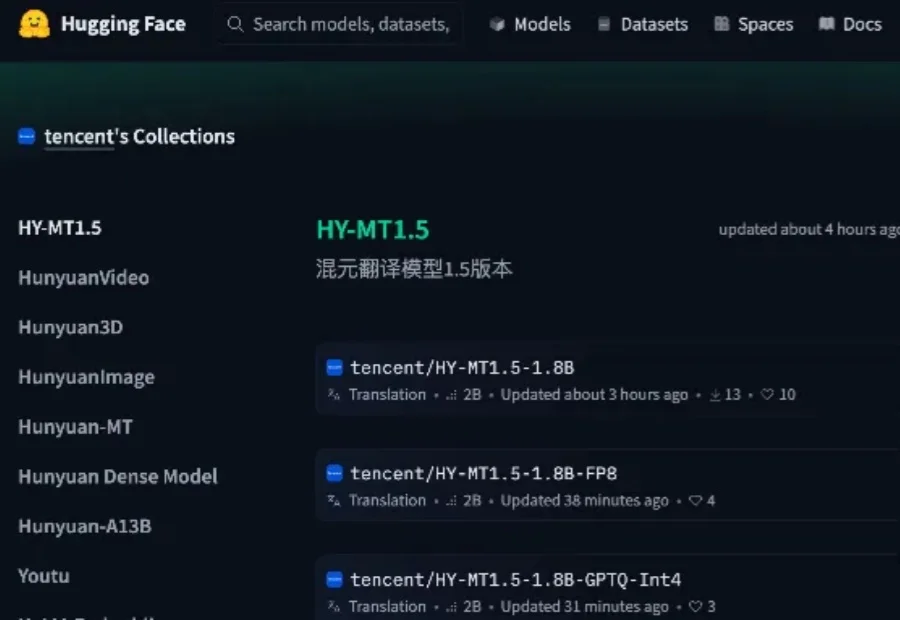

能翻译33语种+5方言,医学术语/粤语翻译实测“能打”。

「我一直在告诉大家,如果你想买(电子)设备,现在就买。我自己要买的 iPhone 17 就已经下手了。」这是咨询公司 TrendForce 高级研究副总裁 Avril Wu 在最近接受采访时说的一句话。

英伟达的顶配 GPU RTX 5090 官方起售价为 1999 美元(经过市场溢价可能达到了 3000 美元以上),而一根单条 256GB 的 DDR5 内存如今的市场价却也飙升到了 3500-5000 美元之间。

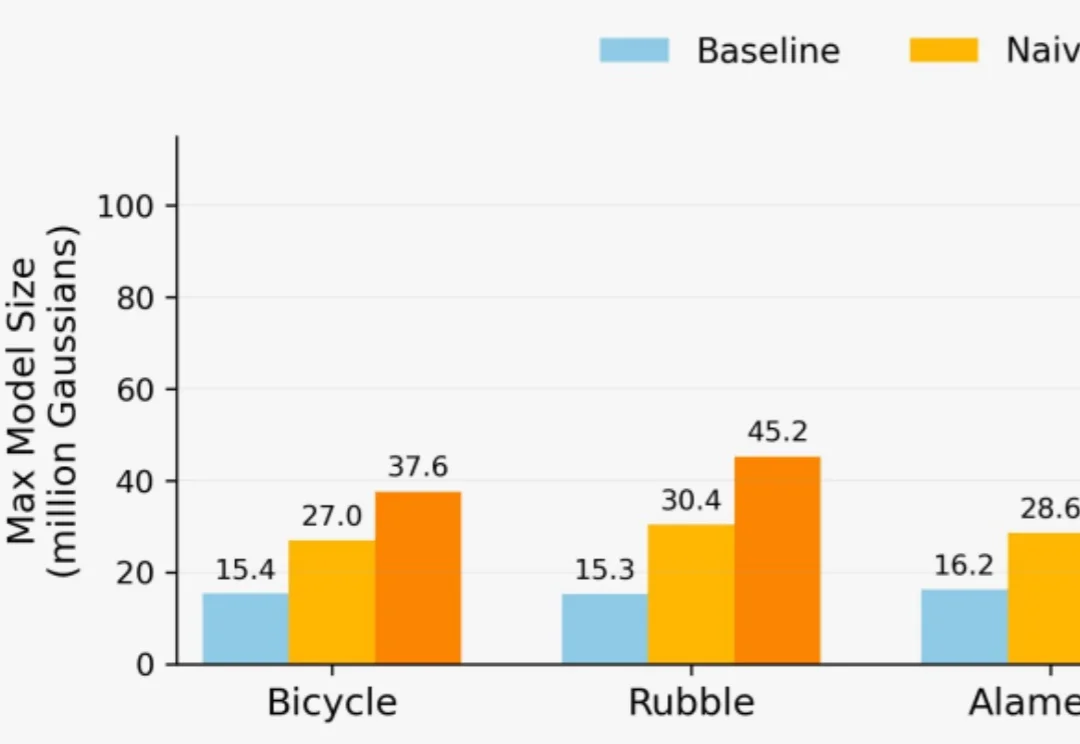

想用3D高斯泼溅(3DGS)重建一座城市?

最近,Google Research 发布了一篇 Blog《Titans + MIRAS:帮助人工智能拥有长期记忆》。它们允许 AI 模型在运行过程中更新其核心内存,从而更快地工作并处理海量上下文。

这个年末,存储行业过得不是很太平:AI巨头们不计成本地囤货,让存储行业迎来了一轮史诗级涨价。作为涨价潮的起点,内存(DRAM)与固态硬盘(SSD,核心为NAND闪存)的价格涨幅堪称惊人。相较于一年多前的市场低谷,如今大家要购买同款内存产品,价格已飙升至此前的三四倍。