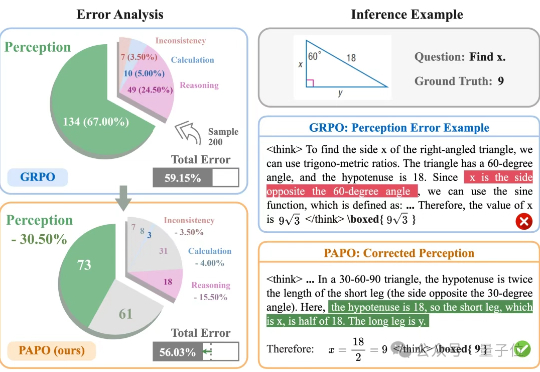

感知错误率降低30.5%:隐式感知损失让模型主动“睁大眼睛” | UIUC&阿里通义

感知错误率降低30.5%:隐式感知损失让模型主动“睁大眼睛” | UIUC&阿里通义让大模型在学习推理的同时学会感知。伊利诺伊大学香槟分校(UIUC)与阿里巴巴通义实验室联合推出了全新的专注于多模态推理的强化学习算法PAPO(Perception-Aware Policy Optimization)。

让大模型在学习推理的同时学会感知。伊利诺伊大学香槟分校(UIUC)与阿里巴巴通义实验室联合推出了全新的专注于多模态推理的强化学习算法PAPO(Perception-Aware Policy Optimization)。

当前,驱动科学研究的人工智能(AI for Science,AI4S)在单点取得了可观的进展,实现了工具层面的革新,然而要成为「革命的工具」,需要采用「通专融合 AGI」方式。

MoCa框架把单向视觉语言模型转化为双向多模态嵌入模型,通过持续预训练和异构对比微调,提升模型性能和泛化能力,在多模态基准测试中表现优异,尤其小规模模型性能突出。

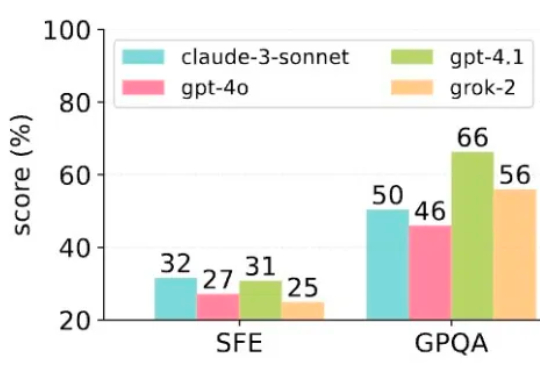

vivo AI Lab发布AI多模态新模型了,专门面向端侧设计,紧凑高效~

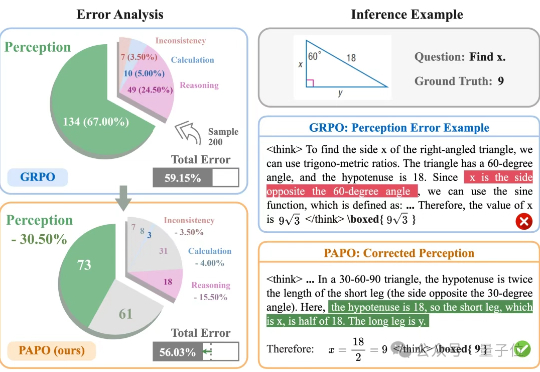

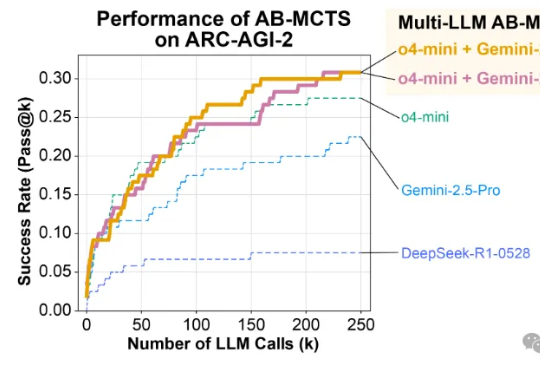

今日,昆仑万维重磅开源多模态推理模型Skywork-R1V 3.0,这是其迄今最强多模态推理模型,参数规模为38B,在多个多模态推理基准测试中取得了开源最佳(SOTA)性能。

ChatGPT的对话流畅性、Gemini的多模态能力、DeepSeek的长上下文分析……

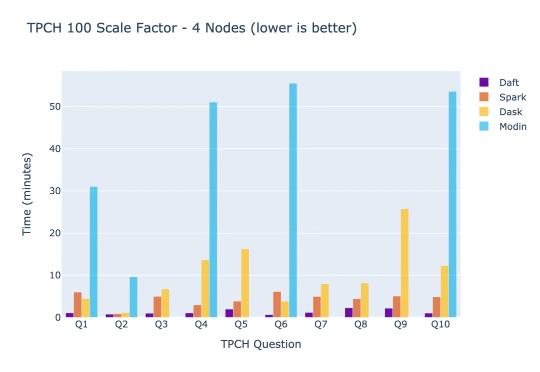

你有没有想过,为什么那些最聪明的AI工程师要把80%的时间浪费在修复数据基础设施上,而不是构建真正改变世界的AI应用?这个看似不合理的现象,正是Eventual创始人Sammy Sidhu和Jay Chia在Lyft自动驾驶部门工作时亲身经历的痛苦。

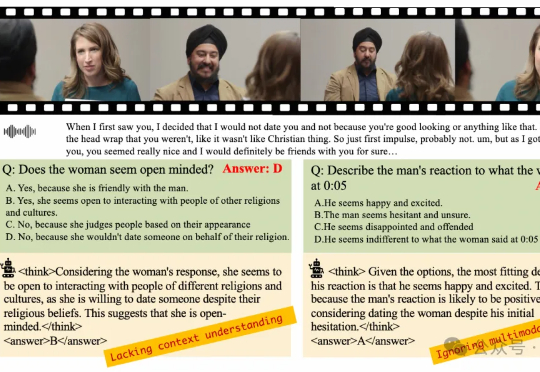

在多模态大语言模型(MLLMs)应用日益多元化的今天,对模型深度理解和分析人类意图的需求愈发迫切。尽管强化学习(RL)在增强大语言模型(LLMs)的推理能力方面已展现出巨大潜力,但将其有效应用于复杂的多模态数据和格式仍面临诸多挑战。

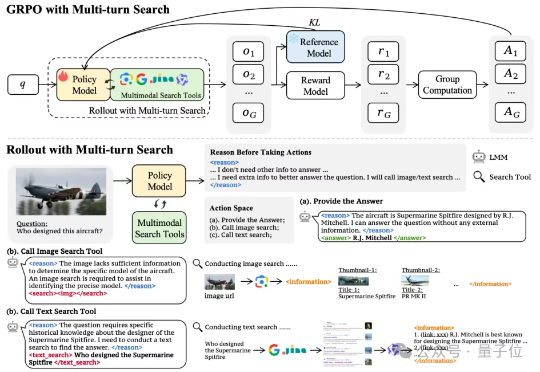

多模态模型学会“按需搜索”!字节&NTU最新研究,优化多模态模型搜索策略——通过搭建网络搜索工具、构建多模态搜索数据集以及涉及简单有效的奖励机制,首次尝试基于端到端强化学习的多模态模型自主搜索训练。

“上线 4 个月,DAU 破百万,累计用户破千万,用户日均对话次数超 9 次,跻身国内同类产品第一梯队 ——元石科技的‘问小白’用生成式推荐重新定义AI时代的信息获取与消费。