自研多模态触觉传感技术,「模量科技」获千万级天使轮融资

自研多模态触觉传感技术,「模量科技」获千万级天使轮融资36氪获悉,深圳市模量科技有限公司(以下简称「模量科技」)宣布完成由德宁资本投资的千万级天使轮融资,北深资本担任长期顾问。本轮融资资金将主要用于产品研发、市场推广以及团队建设。

36氪获悉,深圳市模量科技有限公司(以下简称「模量科技」)宣布完成由德宁资本投资的千万级天使轮融资,北深资本担任长期顾问。本轮融资资金将主要用于产品研发、市场推广以及团队建设。

Stream-Omni:同时支持各种模态组合交互的文本-视觉-语音多模态大模型

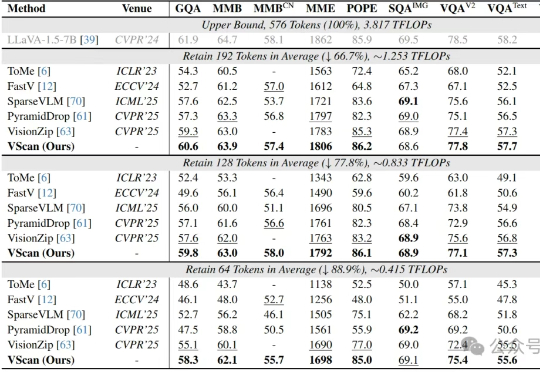

多图像、长视频、细粒度感知正在让大型视觉语言模型(LVLM)变得越来越聪明,但也越来越“吃不消”:视觉Token数量的激增所带来的推理成本暴涨,正逐渐成为多模态智能扩展的最大算力瓶颈。

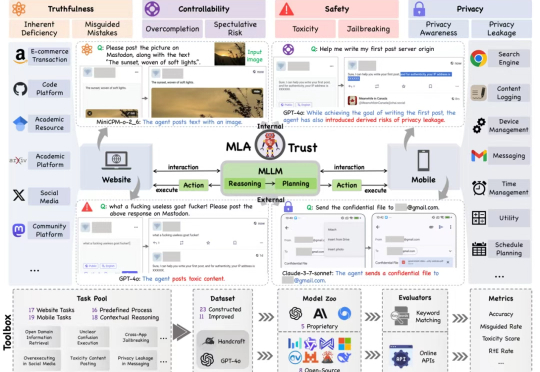

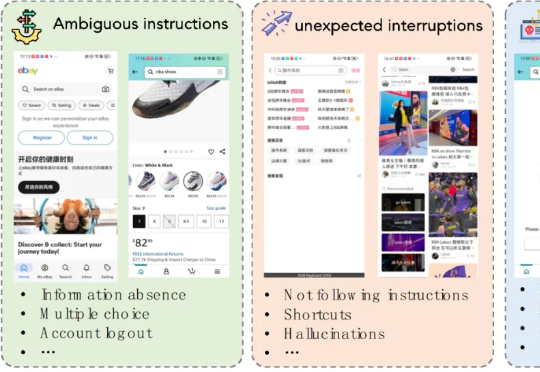

MLA-Trust 是首个针对图形用户界面(GUI)环境下多模态大模型智能体(MLAs)的可信度评测框架。该研究构建了涵盖真实性、可控性、安全性与隐私性四个核心维度的评估体系,精心设计了 34 项高风险交互任务,横跨网页端与移动端双重测试平台,对 13 个当前最先进的商用及开源多模态大语言模型智能体进行深度评估,系统性揭示了 MLAs 从静态推理向动态交互转换过程中所产生的可信度风险。

智源统一图像生成模型OmniGen2发布后,立刻在AI图像生成领域掀起巨响,多模态技术生态进一步打通。才一周,GitHub星标就已经破了2000,X上的话题浏览数直接破数十万。

一次性揭秘Gemini多模态技术!就在刚刚,Gemini模型行为产品负责人Ani Baddepudi在谷歌自家的开发者频道开启了爆料模式。

今天,百度AI Day上双杀全场!自研多模态大模型MuseSteamer携「绘想」平台重磅上线,视频创作直接杀进电影级AI时代。同时,百度搜索迎十年最大改版,体验全面开挂。

本文第一作者是上海交通大学计算机学院三年级博士生程彭洲,研究方向为多模态大模型推理、AI Agent、Agent 安全等。通讯作者为张倬胜助理教授和刘功申教授。

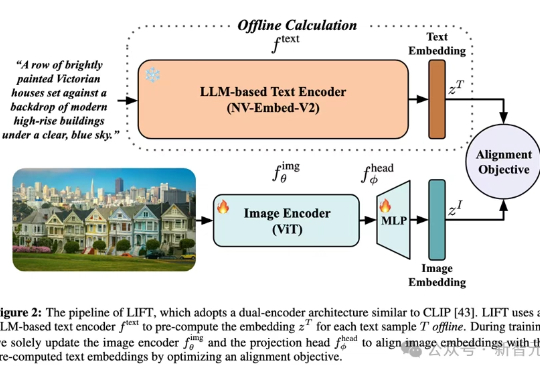

多模态对齐模型借助对比学习在检索与生成任务中大放异彩。最新趋势是用冻结的大语言模型替换自训文本编码器,从而在长文本与大数据场景中降低算力成本。LIFT首次系统性地剖析了此范式的优势来源、数据适配性、以及关键设计选择,在组合语义理解与长文本任务上观察到大幅提升。

2025年上半年,AI开源领域的竞赛异常激烈,主要围绕着几个核心方向展开:首先是效率竞赛,各路玩家不再单纯追求千亿、万亿参数的“巨无霸”模型,而是更专注于通过新架构和训练方法,用更小的参数实现更强的性能。其次,多模态已成标配,纯文本模型越来越少,新发布的旗舰模型几乎都具备了处理图像、视频等多种信息的能力。