5个月估值120亿!OpenAI前CTO自曝首个多模态AI,竟要免费开源

5个月估值120亿!OpenAI前CTO自曝首个多模态AI,竟要免费开源交易成了!OpenAI前CTO初创拿到了20亿种子轮融资,成立5个月公司估值冲到120亿美元。未来几个月,这个汇聚OpenAI顶尖大佬团队,将发布首个多模态AI产品,还会开源部分组件。

交易成了!OpenAI前CTO初创拿到了20亿种子轮融资,成立5个月公司估值冲到120亿美元。未来几个月,这个汇聚OpenAI顶尖大佬团队,将发布首个多模态AI产品,还会开源部分组件。

MIRIX,一个由 UCSD 和 NYU 团队主导的新系统,正在重新定义 AI 的记忆格局。

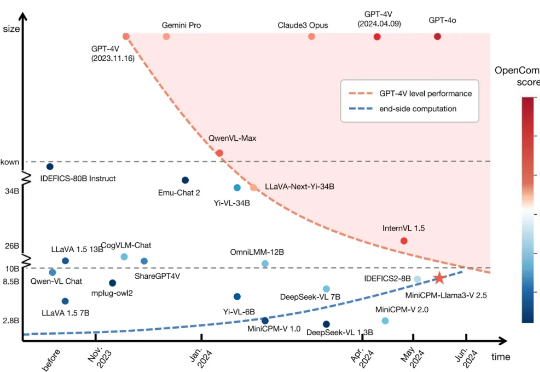

7 月 1 日,国际顶级学术期刊《Nature》旗下子刊《Nature Communications》正式刊登了来自清华、面壁等研究团队联合研发的高效端侧多模态大模型MiniCPM-V 核心研究成果。

Google双线出击!T5Gemma重燃encoder-decoder架构战火,性能暴涨12分;MedGemma坚守decoder-only路线,强攻医疗多模态,击穿闭源壁垒。Gemma体系完成「架构+落地」双重进化,打响Google开源反击战。

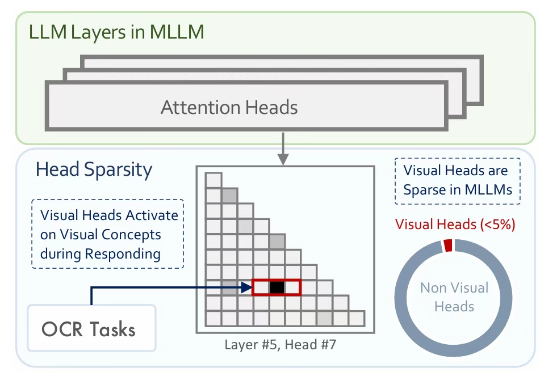

多模态大模型通常是在大型预训练语言模型(LLM)的基础上扩展而来。尽管原始的 LLM 并不具备视觉理解能力,但经过多模态训练后,这些模型却能在各类视觉相关任务中展现出强大的表现。

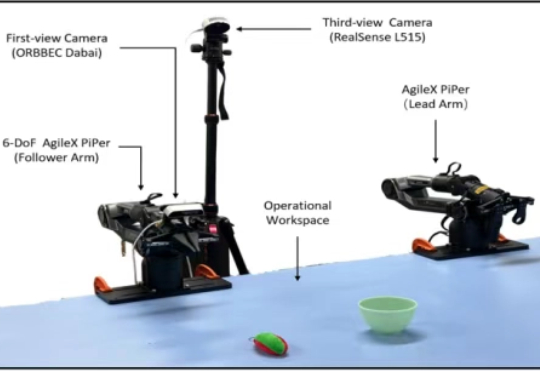

近年来,视觉 - 语言 - 动作(Vision-Language-Action, VLA)模型因其出色的多模态理解与泛化能力,已成为机器人领域的重要研究方向。尽管相关技术取得了显著进展,但在实际部署中,尤其是在高频率和精细操作等任务中,VLA 模型仍受到推理速度瓶颈的严重制约。

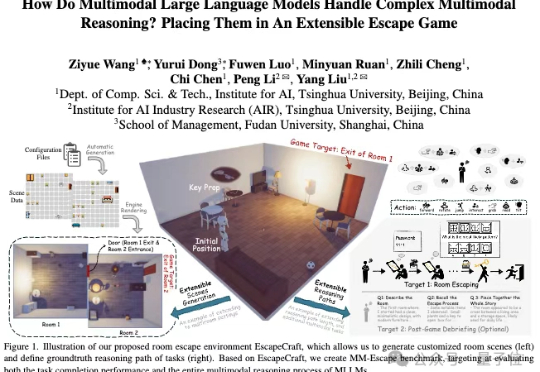

近年来,多模态大模型(MLLMs)发展迅猛,从看图说话到视频理解,似乎无所不能。

GPT-4o引爆全球「吉卜力风格」风潮后,其核心成员——华南理工学霸Lu Liu与伯克利博士Allan Jabri——双双跳槽Meta,两人曾在OpenAI主导多模态AI研究,与奥特曼同台展示关键功能。此次挖角再次凸显OpenAI内部动荡后的人才流失危机。

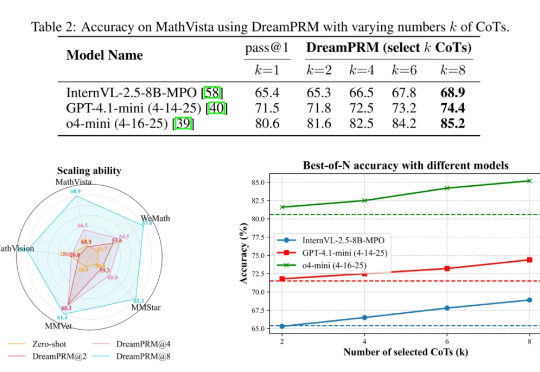

使用过程奖励模型(PRM)强化大语言模型的推理能力已在纯文本任务中取得显著成果,但将过程奖励模型扩展至多模态大语言模型(MLLMs)时,面临两大难题:

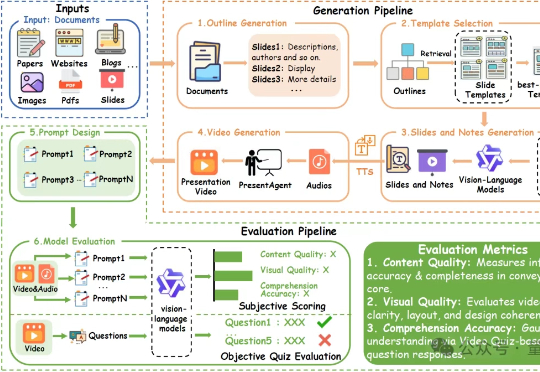

现在的AI Agent在文档生成PPT或视频方面,要想像人一样,把文字、图片、讲解、音视频全都串起来讲清楚,还真不太行。