“造假”齐白石的《虾》,被国产AI一眼识破!

“造假”齐白石的《虾》,被国产AI一眼识破!跟AI交互这事儿,商汤最新发布的大模型,是有点“够快、够准、够好”在身上的。

跟AI交互这事儿,商汤最新发布的大模型,是有点“够快、够准、够好”在身上的。

刚刚发布的豆包大模型1.5,不仅多模态能力全面提升,霸榜多个基准;更难得的是,它在训练过程中从未使用过任何其他模型生成的数据,坚决不走蒸馏「捷径」。

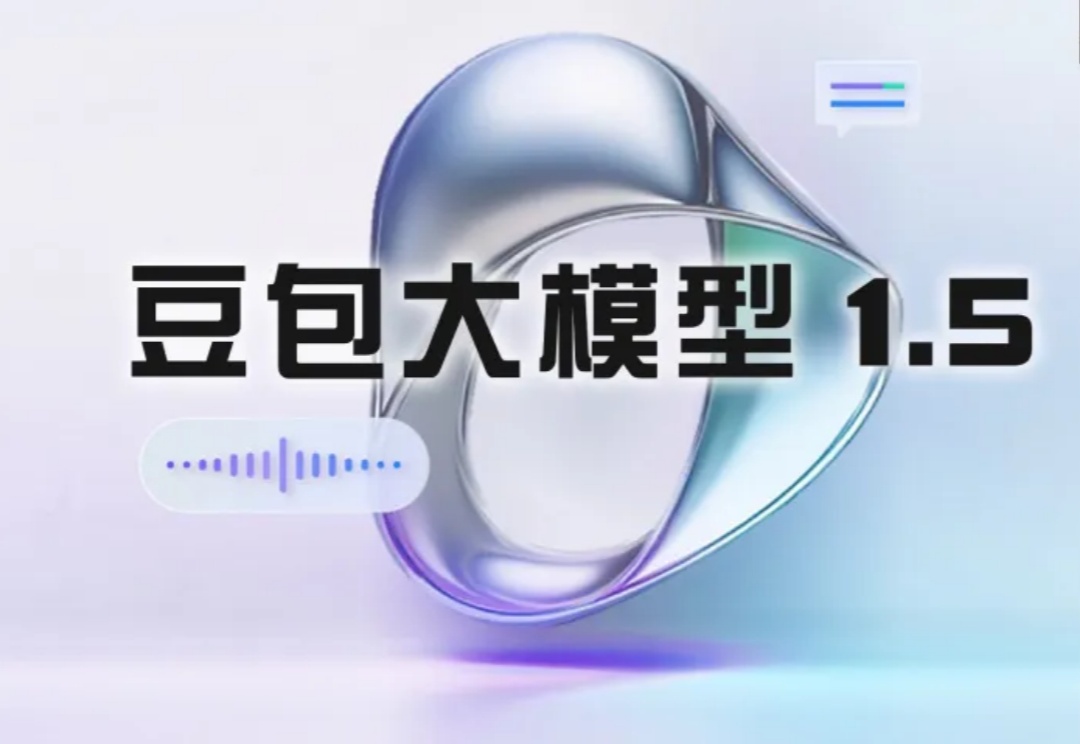

近年来视觉语⾔基础模型(Vision Language Models, VLMs)在多模态理解和⾼层次常识推理上⼤放异彩,如何将其应⽤于机器⼈以实现通⽤操作是具身智能领域的⼀个核⼼问题。这⼀⽬标的实现受两⼤关键挑战制约:

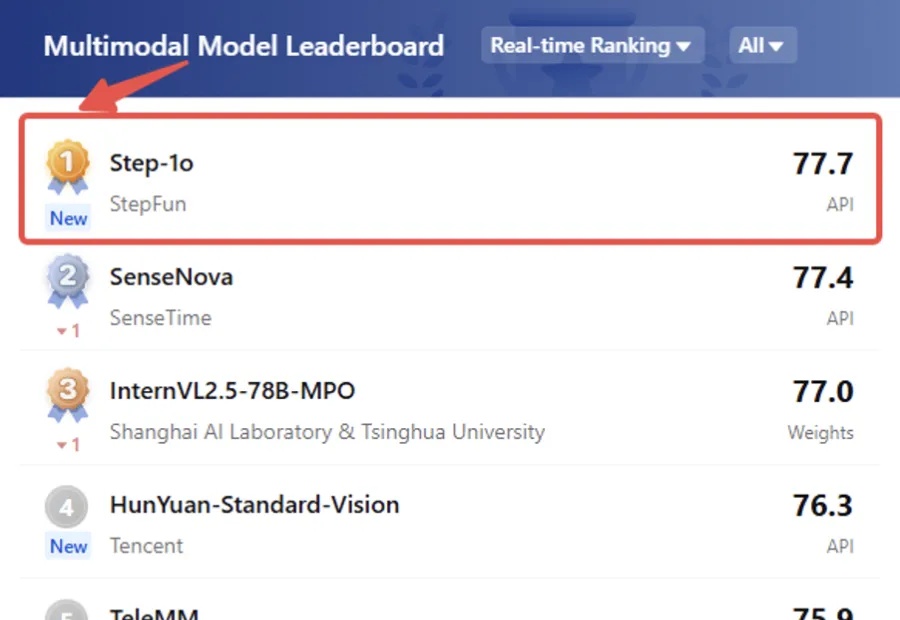

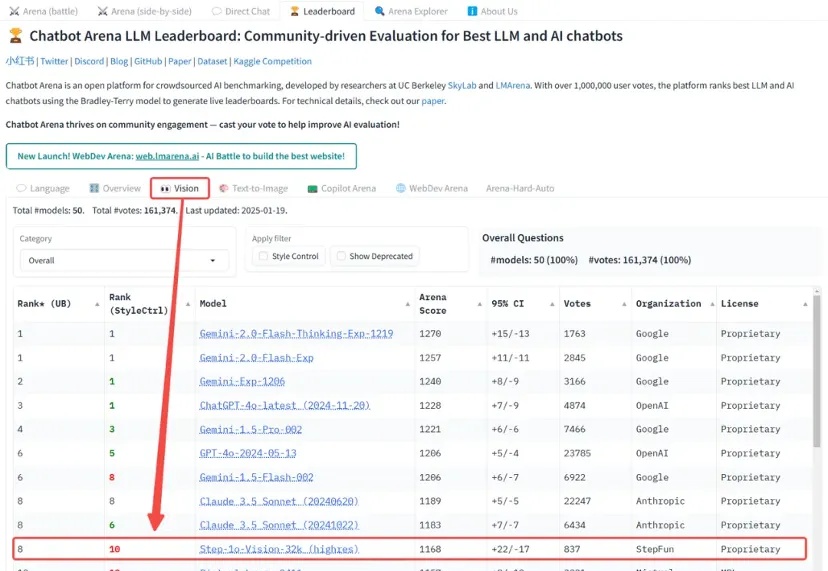

我勒个老天奶,大模型六小强之一的阶跃星辰,给大家拜早年的方式可真不一样——

提一个冷知识。

下一代 AI 的发展,似乎遇到了难以逾越的瓶颈。去年 12 月,OpenAI 在 ChatGPT 两周年期间连续发布了 12 天,我们期待的新一代大模型 GPT-5 却从头到尾没有踪影。

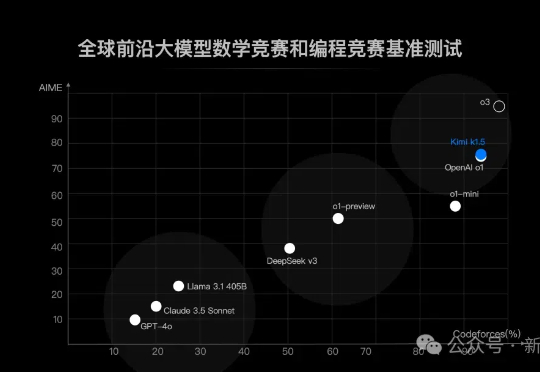

来了来了,月之暗面首个「满血版o1」来了!这是除OpenAI之外,首次有多模态模型在数学和代码能力上达到了满血版o1的水平。

近期关于 scaling law 的讨论甚嚣尘上,很多观点认为 scale law is dead. 然而,我们认为,高质量的 “无监督” 数据才是 scaling law 的关键,尤其是教科书级别的高质量的知识语料。此外,尽管传统的语料快枯竭了,但是互联网上还有海量的视频并没有被利用起来,它们囊括了丰富的多种模态的知识,可以帮助 VLMs 更好好地理解世界。

AI编程蓝皮书火了,发布3天,阅读量超过3万!

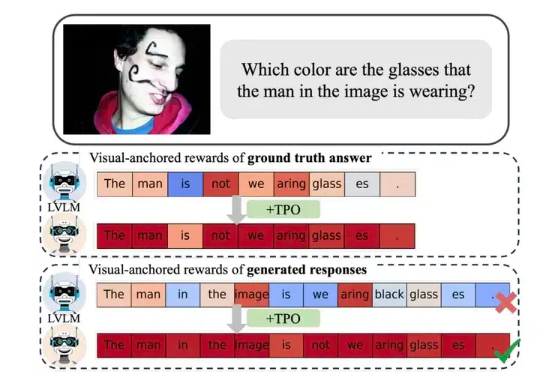

近年来,视觉大模型(Large Vision Language Models, LVLMs)领域经历了迅猛的发展,这些模型在图像理解、视觉对话以及其他跨模态任务中展现出了卓越的能力。然而,随着 LVLMs 复杂性和能力的增长,「幻觉现象」的挑战也日益凸显。