完全使用「自生成数据」实现LLM自我纠正,DeepMind新突破SCoRe:纠正性能提升15.9%

完全使用「自生成数据」实现LLM自我纠正,DeepMind新突破SCoRe:纠正性能提升15.9%Google DeepMind的SCoRe方法通过在线多轮强化学习,显著提升了大型语言模型在没有外部输入的情况下的自我修正能力。该方法在MATH和HumanEval基准测试中,分别将自我修正性能提高了15.6%和9.1%。

Google DeepMind的SCoRe方法通过在线多轮强化学习,显著提升了大型语言模型在没有外部输入的情况下的自我修正能力。该方法在MATH和HumanEval基准测试中,分别将自我修正性能提高了15.6%和9.1%。

科学技术的快速发展过程中,机器学习研究作为创新的核心驱动力,面临着实验过程复杂、耗时且易出错,研究进展缓慢以及对专门知识需求高的挑战。近年来,LLM 在生成文本和代码方面展现出了强大的能力,为科学研究带来了前所未有的可能性。然而,如何系统化地利用这些模型来加速机器学习研究仍然是一个有待解决的问题。

NVLM 1.0系列多模态大型语言模型在视觉语言任务上达到了与GPT-4o和其他开源模型相媲美的水平,其在纯文本性能甚至超过了LLM骨干模型,特别是在文本数学和编码基准测试中,平均准确率提高了4.3个百分点。

斯坦福大学的最新研究通过大规模实验发现,尽管大型语言模型(LLMs)在新颖性上优于人类专家的想法,但在可行性方面略逊一筹,还需要进一步研究以提高其实用性。

大型语言模型(LLMs)虽然进展很快,很强大,但是它们仍然存在会产生幻觉、生成有害内容和不遵守人类指令等问题。一种流行的解决方案就是基于【自我纠正】,大概就是看自己输出的结果,自己反思一下有没有错,如果有错就自己改正。目前自己纠正还是比较关注于让大模型从错误中进行学习。

近日 Aleph Alpha 开始将其商业重点从开发大型语言模型转向生成式 AI 操作系统和咨询服务。

当前的大型语言模型似乎能够通过一些公开的图灵测试。我们该如何衡量它们是否像人一样聪明呢?

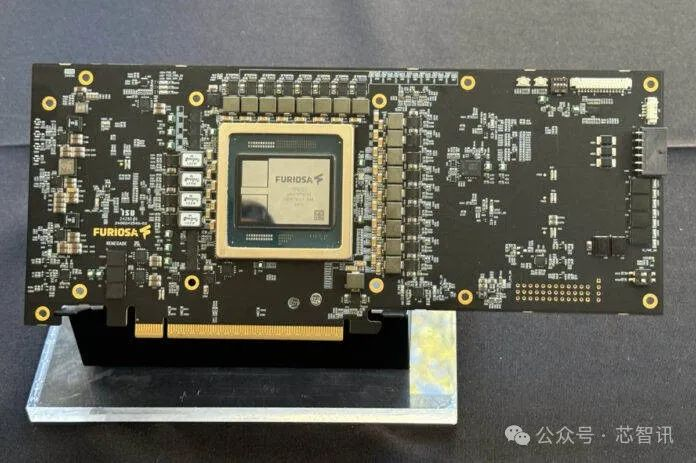

8月27日消息,在近日召开的Hot Chips 2024大会上,韩国AI芯片初创公司FuriosaAI 推出了一款面向高性能大型语言模型和多模态模型推理的高能效数据中心AI加速器 RNGD。

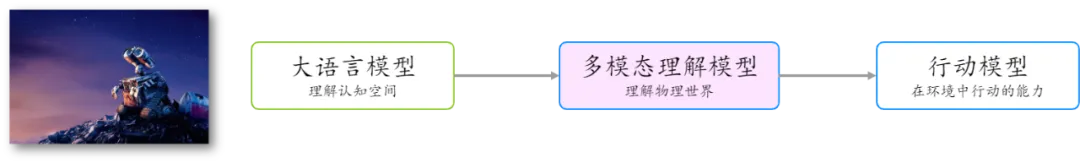

以 GPT 为代表的大型语言模型预示着数字认知空间中通用人工智能的曙光。这些模型通过处理和生成自然语言,展示了强大的理解和推理能力,已经在多个领域展现出广泛的应用前景。无论是在内容生成、自动化客服、生产力工具、AI 搜索、还是在教育和医疗等领域,大型语言模型都在不断推动技术的进步和应用的普及。

T-MAC是一种创新的基于查找表(LUT)的方法,专为在CPU上高效执行低比特大型语言模型(LLMs)推理而设计,无需权重反量化,支持混合精度矩阵乘法(mpGEMM),显著降低了推理开销并提升了计算速度。