告别RAG延迟!LLM首个即插即用“记忆解码器”问世!

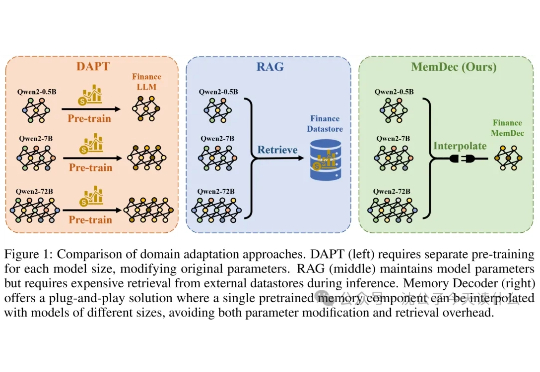

告别RAG延迟!LLM首个即插即用“记忆解码器”问世!一句话概括,还在嫌弃RAG太慢?这帮研究员直接把检索数据库"蒸馏"成了一个小模型,实现了不检索的检索增强,堪称懒人福音。

一句话概括,还在嫌弃RAG太慢?这帮研究员直接把检索数据库"蒸馏"成了一个小模型,实现了不检索的检索增强,堪称懒人福音。

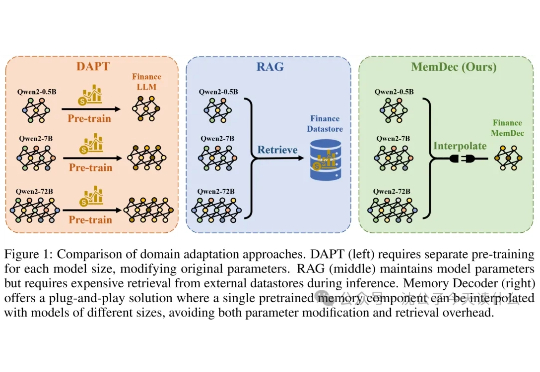

27M小模型超越o3-mini-high和DeepSeek-R1!推理还不靠思维链。 开发者是那位拒绝了马斯克、还要挑战Transformer的00后清华校友,Sapient Intelligence的创始人王冠。

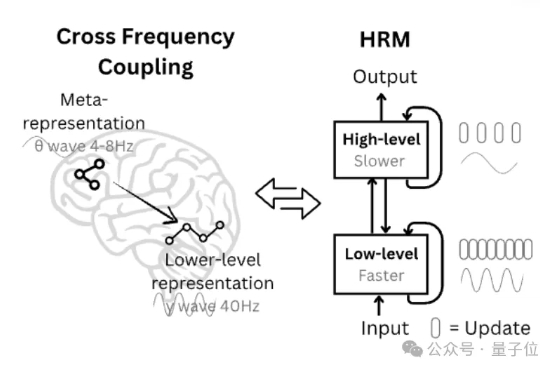

刚刚,腾讯混元团队宣布一口气开源了 4 款小模型 —— 最大的只有 7B,另外还包括 4B、1.8B 和 0.5B 三个型号。

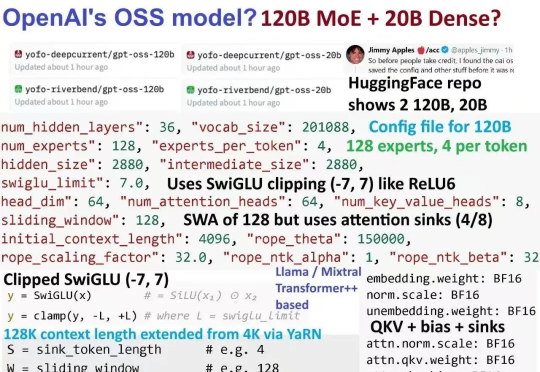

gpt5来临前夕,oai疑似发布的小模型gpt-oss 120B的架构图已经满天飞了。难得openai要open一次,自然调动了我的全部注意力机制。本来以为oai还要掏出gpt2意思意思,结果看到了一个120B moe。欸?!

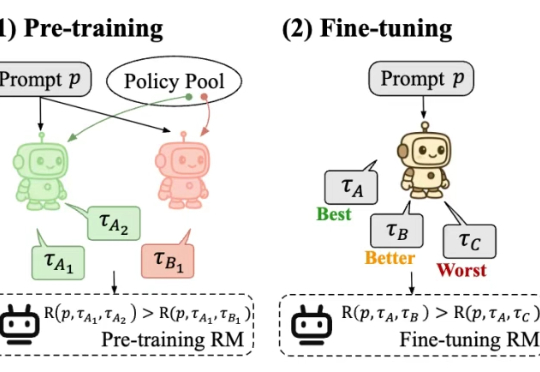

最近,一款全新的奖励模型「POLAR」横空出世。它开创性地采用了对比学习范式,通过衡量模型回复与参考答案的「距离」来给出精细分数。不仅摆脱了对海量人工标注的依赖,更展现出强大的Scaling潜力,让小模型也能超越规模大数十倍的对手。

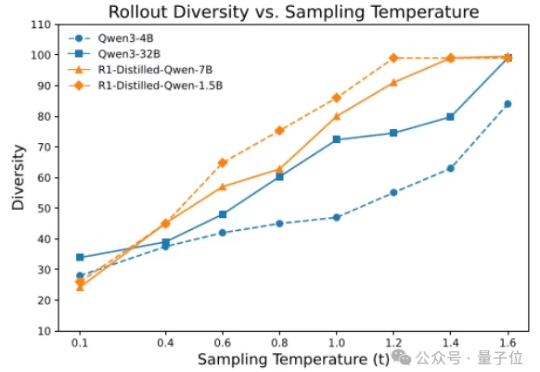

香港大学NLP团队联合字节跳动Seed、复旦大学发布名为Polaris的强化学习训练配方:通过Scaling RL,Polaris让4B模型的数学推理能力(AIME25上取得79.4,AIME24上取得81.2)超越了一众商业大模型,如Seed-1.5-thinking、Claude-4-Opus和o3-mini-high(25/01/31)。

如果一个视觉语言模型(VLM)只会“看”,那真的是已经不够看的了。

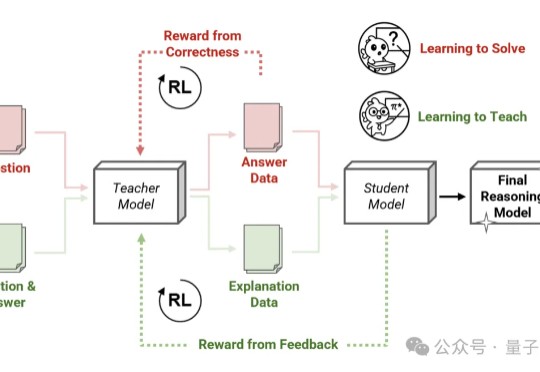

Thinking模式当道,教师模型也该学会“启发式”教学了—— 由Transformer作者之一Llion Jones创立的明星AI公司Sakana AI,带着他们的新方法来了!

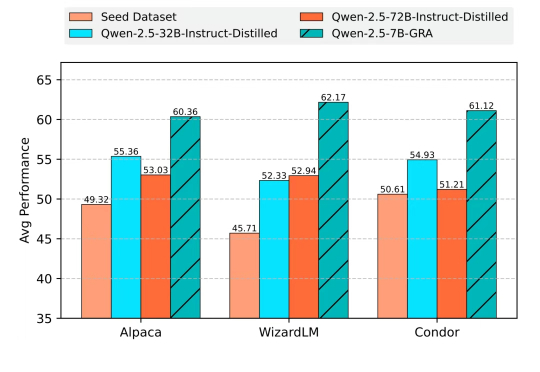

无需蒸馏任何大规模语言模型,小模型也能自给自足、联合提升?

NVIDIA等研究团队提出了一种革命性的AI训练范式——视觉游戏学习ViGaL。通过让7B参数的多模态模型玩贪吃蛇和3D旋转等街机游戏,AI不仅掌握了游戏技巧,还培养出强大的跨领域推理能力,在数学、几何等复杂任务上击败GPT-4o等顶级模型。