微软加码南非,投资 2.98 亿美元打造人工智能基础设施升级

微软加码南非,投资 2.98 亿美元打造人工智能基础设施升级微软宣布将在2027年底前追加投资54亿兰特(约2.97亿美元),扩大其在南非的云计算和人工智能(AI)基础设施,以满足Azure 云服务在该地区不断增长的需求。此外,该公司还计划为5万名南非学员提供云架构、人工智能和网络安全等高需求技能的认证考试费用,以助力本地人才发展。

微软宣布将在2027年底前追加投资54亿兰特(约2.97亿美元),扩大其在南非的云计算和人工智能(AI)基础设施,以满足Azure 云服务在该地区不断增长的需求。此外,该公司还计划为5万名南非学员提供云架构、人工智能和网络安全等高需求技能的认证考试费用,以助力本地人才发展。

微软研究院官宣开源多模态AI——Magma模型。首个能在所处环境中理解多模态输入并将其与实际情况相联系的基础模型。

思维链引发的战争。

OmniParser V2可将屏幕截图转换为结构化元素,帮助LLM理解和操作GUI;在检测小图标和推理速度上显著提升,延迟降低60%,与多种LLM结合后表现优异。

动辄百亿、千亿参数的大模型正在一路狂奔,但「小而美」的模型也在闪闪发光。

RedStone是一个高效构建大规模指定领域数据的处理管道,通过优化数据处理流程,从Common Crawl中提取了RedStone-Web、RedStone-Code、RedStone-Math和RedStone-QA等数据集,在多项任务中超越了现有开源数据集,显著提升了模型性能。

微软 ( NASDAQ: MSFT) 2025 年第一季度营收激增,同时还有大规模的人工智能投资(1000 亿美元)。此后,该股表现略逊于市场(标准普尔 500 指数,+3.65%),价格回报率为负 1%。几天前,该公司公布了第二季度业绩。

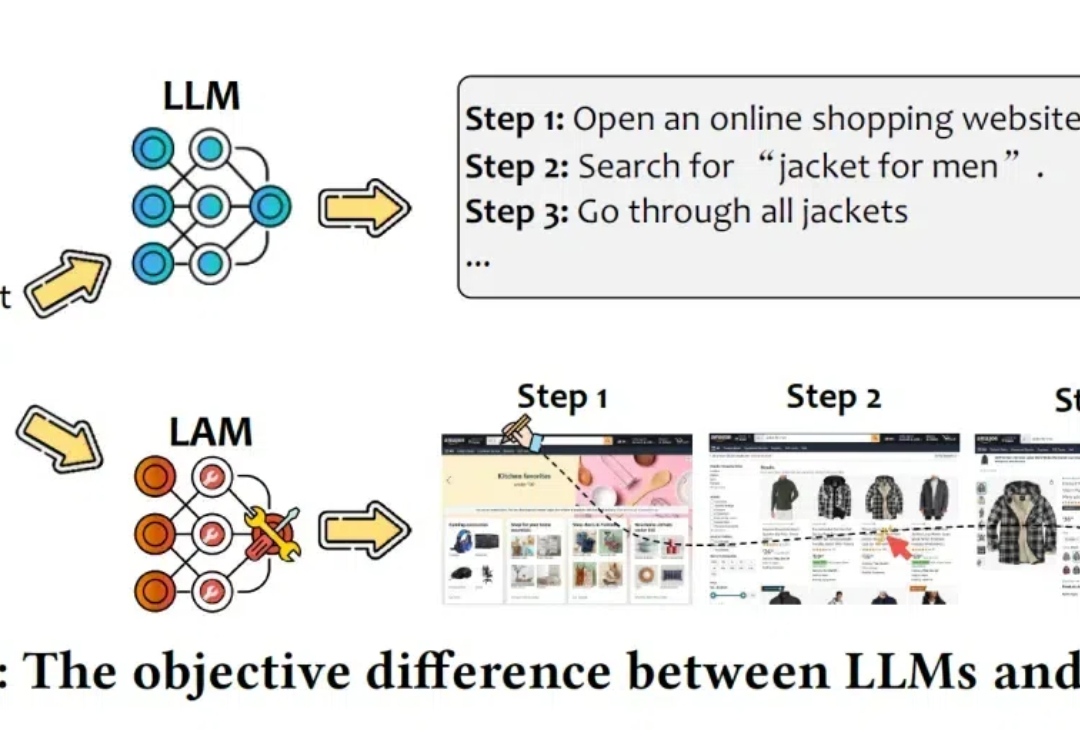

AI大模型正从仅会聊天的LLM进化为能够执行任务的大型行动模型LAM。它不仅能理解用户的指令,还能在软件环境中自主执行任务。

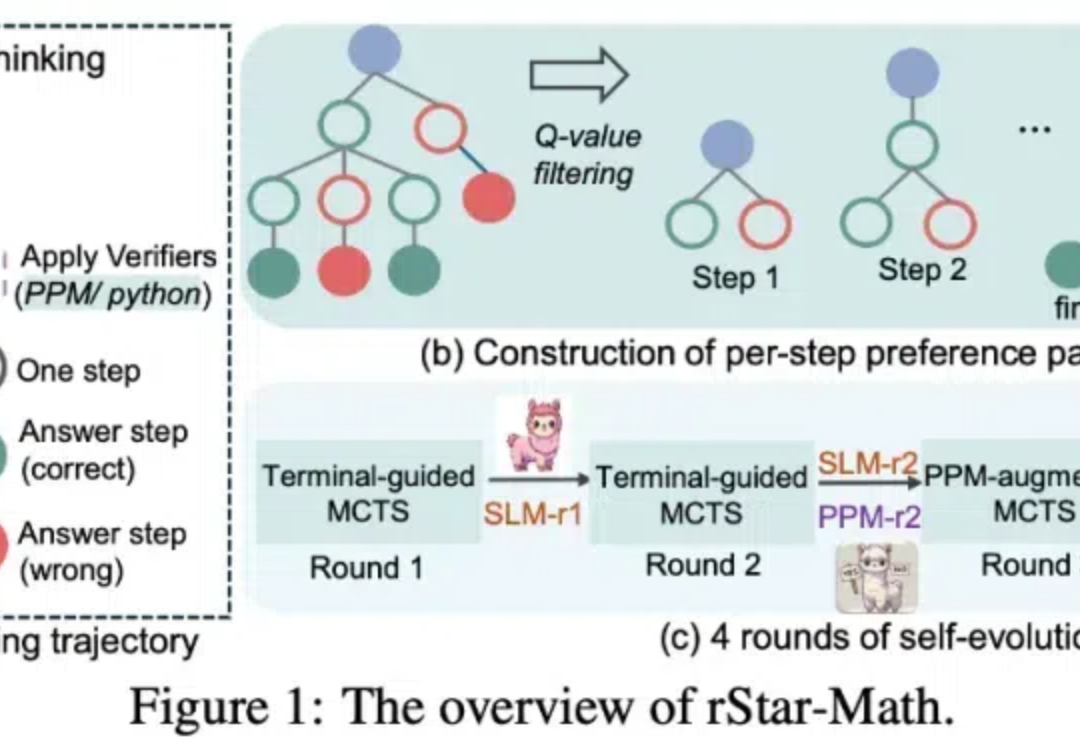

OpenAI o1 给大模型规模扩展 vs 性能的曲线带来了一次上翘。它在大模型领域重现了当年 AlphaGo 强化学习的成功 —— 给越多算力,就输出越多智能,一直到超越人类水平。

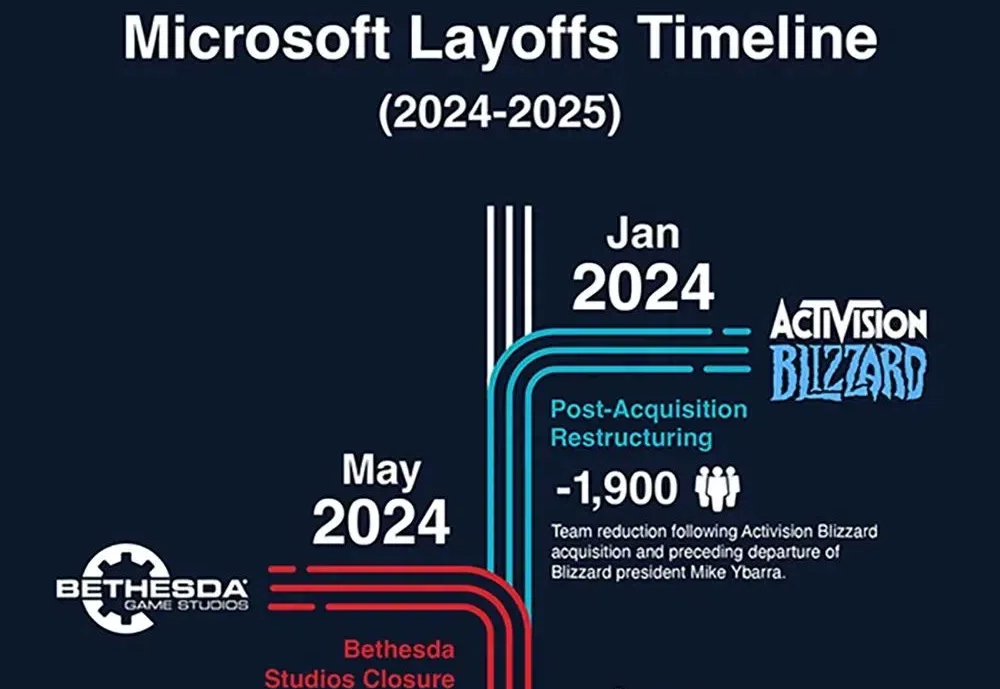

AI Agent 会是未来吗? 对于科技行业的从业者而言,很多人每天既为新技术的突破感到兴奋,又因自身和行业前景的未知而焦虑,尤其是最近一轮裁员风暴,更为整个行业蒙上了一层阴影。