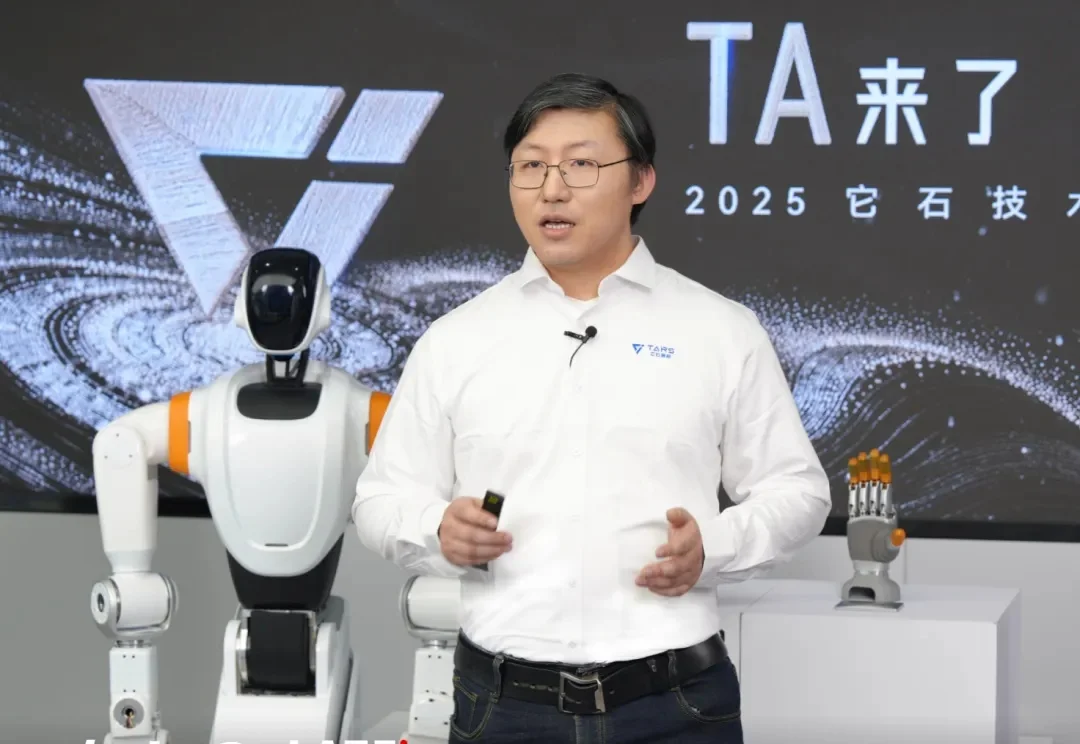

陈亦伦和李震宇创立的具身公司它石智航,不做 VLA、不仿真,不走主流路线

陈亦伦和李震宇创立的具身公司它石智航,不做 VLA、不仿真,不走主流路线不做 VLA;不做遥操,以可穿戴设备采真实数据。

不做 VLA;不做遥操,以可穿戴设备采真实数据。

AI 社交网络 Moltbook 数据库完全暴露,15 万 AI「居民」的密钥可被任意接管。

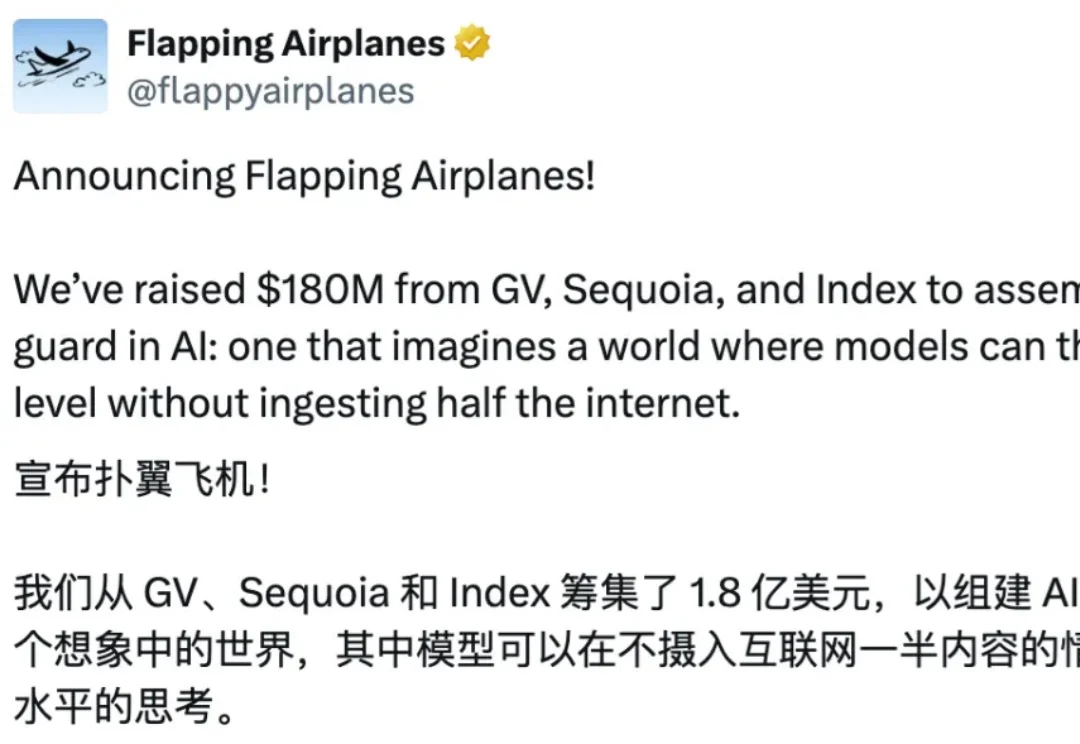

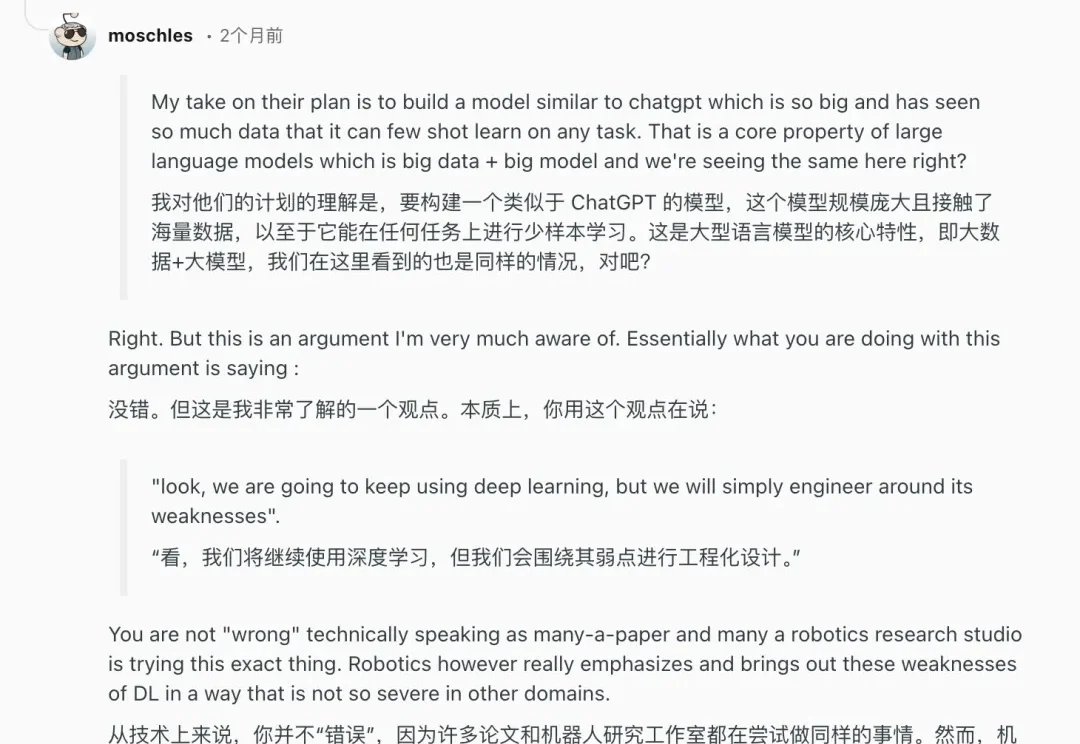

AI 需要整个互联网来学习,而人类只需要一个童年。人类在成年之前,所接触的语言、文本与符号,顶多只有几十亿 token,相差几个数量级。正是从这个问题出发,一家几乎没有产品、没有盈利、也不急于商业化的 AI 创业公司,从 GV、Sequoia 和 Index 拿到了 1.8 亿美元融资,并获得了 Andrej Karpathy 的公开力挺。

机器人领域是我们长期关注的赛道,而 Generalist 是当前机器人领域中极少数具备长期竞争潜力的公司,核心优势集中在数据规模、团队能力与清晰的 scaling 路径上。

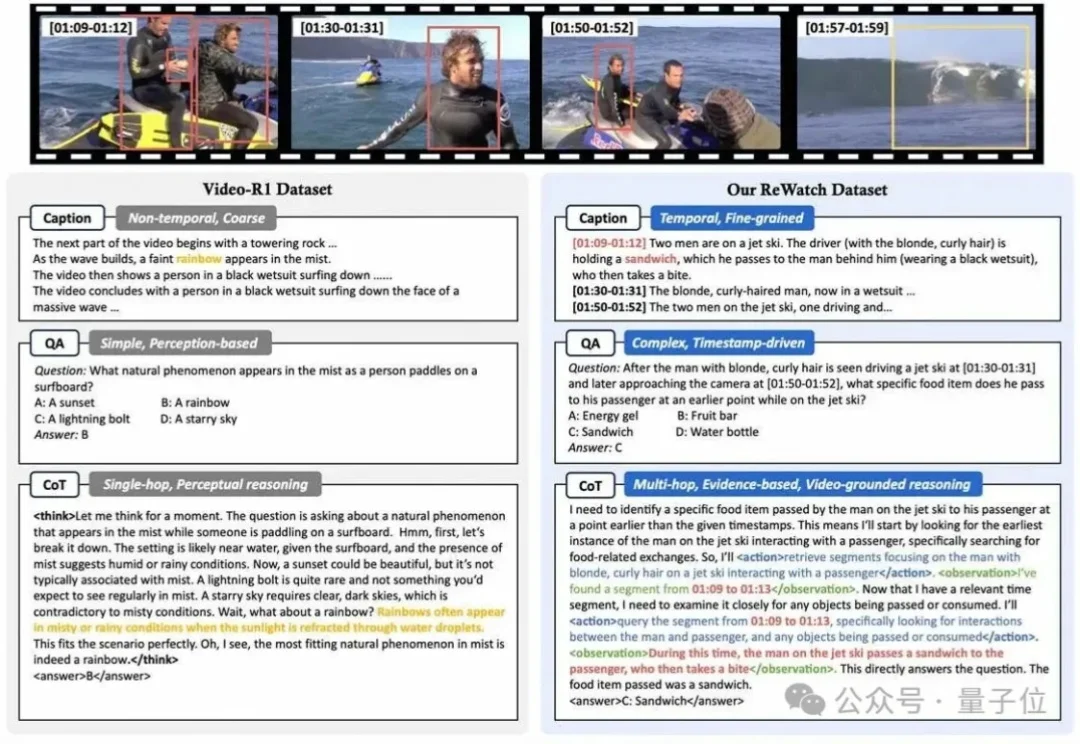

为什么让多模态大模型“一步一步思考”(”Let’s think step by step”)来回答视频问题,效果有时甚至还不如让它“直接回答”?

大模型的出现,给许多行业带来了颠覆性的改变,运维这个向来被视为稳定、保守的领域也不例外。虽然“AIOps”这个概念早在 2016 年由 Gartner 提出,但早期的智能运维更多是利用大数据和机器学习对传统运维流程进行效率上的提升。

最近Clawdbot(现:Moltbot)全网爆火。它能接管你的社交媒体,能发帖、能监听、能回复、能长期驻场。不是一次性回答,而是持续存在。

美国机器人界掌管demo的神,Figure,冷不丁又出一拳!

随着无需向云端发送敏感数据、以隐私为先的企业级人工智能需求日益增长,SpotDraft 已从高通风险投资公司获得 800 万美元战略 B 轮扩展融资,以扩展其面向受监管法律工作流程的端侧合同审评技术。

一夜爆红的ClawdBot,正在把无数公司和个人推向深渊:端口裸奔、无鉴权、可被远程接管。现在,暴力破解、数据清空已经真实发生了,这不是危言耸听。各位CEO纷纷预警:ClawdBot,正在酝酿一场全球灾难!