2025 AI巨头「全员恶人」:恩怨、爱恨与算计

2025 AI巨头「全员恶人」:恩怨、爱恨与算计OpenAI转身牵手AWS,苹果低头找谷歌续命,Meta开源翻车还内斗,马斯克直接把Macrohard挂上数据中心屋顶。2025年AI巨头们那些剪不断的纠葛。

OpenAI转身牵手AWS,苹果低头找谷歌续命,Meta开源翻车还内斗,马斯克直接把Macrohard挂上数据中心屋顶。2025年AI巨头们那些剪不断的纠葛。

想象一下,你正在训练一个未来的家庭机器人。你希望它能像人一样,轻松地叠好一件衬衫,整理杂乱的桌面,甚至系好一双鞋的鞋带。但最大的瓶颈是什么?不是算法,不是硬件,而是数据 —— 海量的、来自真实世界的、双手协同的、长程的、多模态的高质量数据。

2025 年,人工智能的发展重心正在发生一次根本性转移:从追求模型的规模,转向构建其理解与解决复杂现实问题的能力。在这一转型中,高质量数据正成为定义 AI 能力的新基石。作为人工智能数据服务的前沿探索者,数据堂深度参与并支撑着这场变革的每一个关键环节。本文将深入解读 2025 年 AI 五大技术趋势及其背后的数据需求变革。

在上一篇《全载录丨Xsignal 全球AI应用行业年度报告丨2025》中,我们俯瞰了全球AI从“震撼期”迈入“深水区”的宏观版图。如果说那是一张新大陆的地图,那么今天,我们将目光聚焦于这场变革的“风暴眼”——中国头部科技公司的战略棋局。

当全行业还在为昂贵的多视角数据焦头烂额时,中科院和CreateAI重磅推出NeoVerse,直接用百万单目视频砸开了4D世界模型的大门,让AI真正学会了理解开放世界。

大模型王座易主Anthropic,太空数据中心成真,「AI泡沫」反成创业红利?2025年底的Y Combinator博客中,谈到了2025 年 AI 领域的四大变局。

融资35亿后,Kimi的新模型紧跟着就要来了?!大模型竞技场上,一个名叫Kiwi-do的神秘模型悄然出现。发现这个新模型的推特网友询问了模型的身份,结果模型自报家门,表示自己来自月之暗面Kimi,训练数据截止到2025年1月。

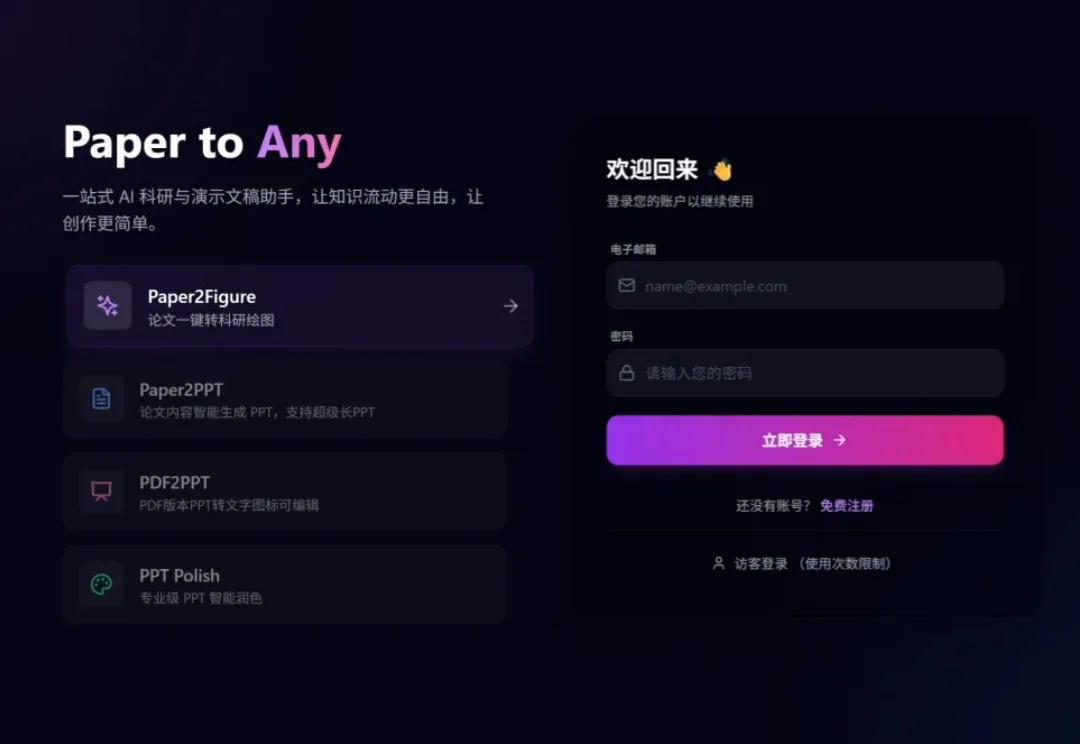

你是否经历过这样的至暗时刻: 明明实验数据已经跑通,核心逻辑也已梳理完毕,却在面对空白的 PPT 页面时陷入停滞; 明明脑海里有清晰的系统架构,却要在 Visio 或 Illustrator 里跟一根歪歪扭扭的线条较劲半小时; 好不容易用 AI 生成了一张精美的流程图,却发现上面的文字是乱码,或者为了改一个配色不得不重新生成几十次……

我国自主研发的“风清”“风雷”“风顺”“风和”等气象大模型,不仅在实战中并跑国际同类系统,更让气象服务走向个性化、精准化与智能化。在“风和”大模型的对话框输入上述问题,AI立刻展现出它的“思考轨迹”:先定位时间与地点,调取该时段温度、风力、湿度等数据,继而生成贴心的穿搭提醒——“内薄外厚,方便调节室内外温差”“早晚温差大,建议携带外套”“室内暖气较足

借势Agent浪潮,实时数据企业走上港股舞台。