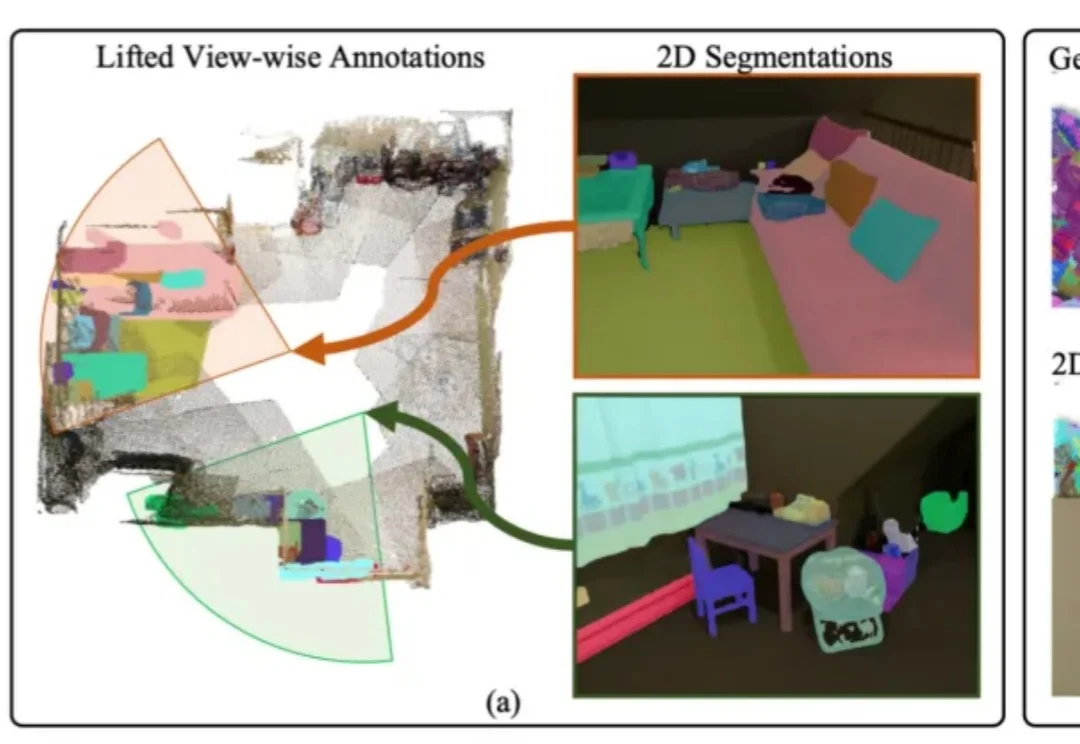

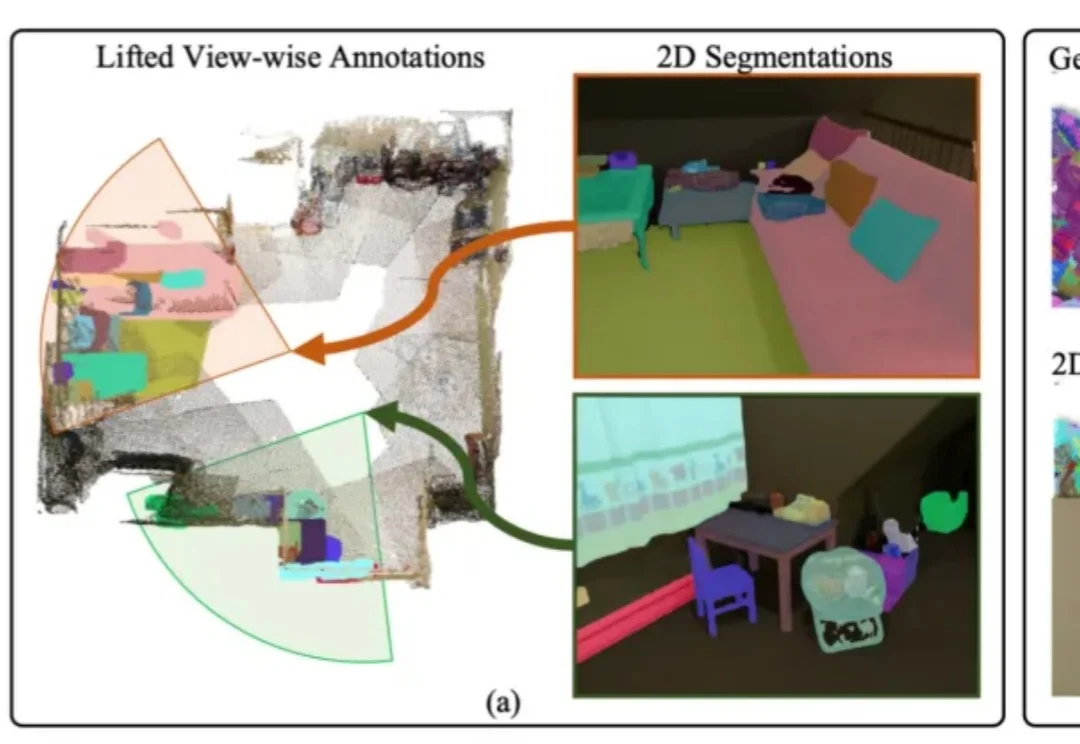

用2D先验自动生成3D标注,自动驾驶、具身智能有福了丨IDEA团队开源

用2D先验自动生成3D标注,自动驾驶、具身智能有福了丨IDEA团队开源3D模型的实例分割一直受限于稀缺的训练数据与高昂的标注成本,训练效果有待提升。

3D模型的实例分割一直受限于稀缺的训练数据与高昂的标注成本,训练效果有待提升。

来自 Player2 的研究员们提出了 Pixel2Play(P2P)模型,该模型以游戏画面和文本指令作为输入,直接输出对应的键盘与鼠标操作信号。在消费级显卡 RTX 5090 上,P2P 可以实现超过 20Hz 的端到端推理速度,从而能够真正像人类一样和游戏进行实时交互。P2P 作为通用游戏基座模型,在超过 40 款游戏、总计 8300 + 小时的游戏数据上进行了训练,

福布斯400新晋最年轻富豪——Edwin Chen,美裔华人,年仅37岁。在Edwin看来,在我们的世界里,人类,就是那批拥有超能力的外星人。而AI可以通过标注数据,学习我们的思维模式,最终获得独属于人类的超能力——智能。

注意看,眼前这个男人暂且叫他小帅。 你可能想不到,他只是在厨房里优雅地煎牛排做做家务,每小时最高能赚进1000多块(150美元)。 怪不得小帅天天上班喜笑颜开。

一个从谷歌「打工人」走出的数学怪才,靠着自掏腰包创业,五年把公司做到营收超12亿美元,估值300亿美金。他讨厌硅谷的浮夸,却意外登上《福布斯400》富豪榜,成为最年轻的成员。

人工智能初创公司Invisible Technologies 作为 Scale AI 的竞争对手,在新一轮融资中筹集 1 亿美元资金,这凸显了硅谷投资者对人工智能热潮基础构建模块的持续关注。

就在 Scale AI 公司的 95 后创始人 Alexandr Wang 在 Meta 挑大梁之际,他迎来了一位比他更小的 00 后劲敌。这名 00 后叫阿里·安萨里(Ali Ansari),是一名

AI 数据行业,总有新人出头。

Meta豪掷143亿收购Scale AI,意外成就了3名22岁青年的创业神话!他们靠着为OpenAI等顶级AI实验室输送模型专家训练师,干出百亿独角兽Mercor,年入1亿美金。目前,Mercor在《福布斯》Cloud 100 榜单中排名第89位。

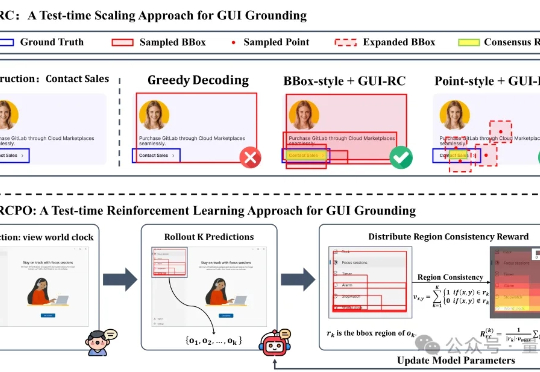

无需海量数据标注,智能体也能精确识别定位目标元素了! 来自浙大等机构的研究人员提出GUI-RCPO——一种自我监督的强化学习方法,可以让模型在没有标注的数据上自主提升GUI grounding(图形界面定位)能力。