一键下载Meta最大视频分割数据集,含50.9K真实世界视频,覆盖47个国家

一键下载Meta最大视频分割数据集,含50.9K真实世界视频,覆盖47个国家一键下载最大的视频分割数据集

一键下载最大的视频分割数据集

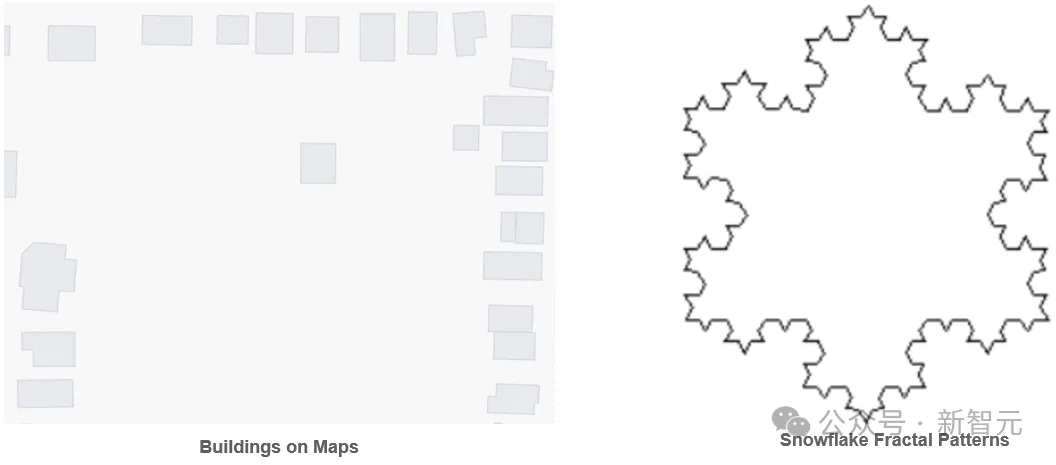

PolygonGNN是一种新型框架,用于学习包括单一和多重多边形在内的多边形几何体的表征,它通过异质可见图来捕捉多边形内外的空间关系,并利用图神经网络有效处理这些关系,以提高计算效率和泛化能力。该框架在五个数据集上表现出色,证明了其在捕捉多边形几何体有用表征方面的有效性。

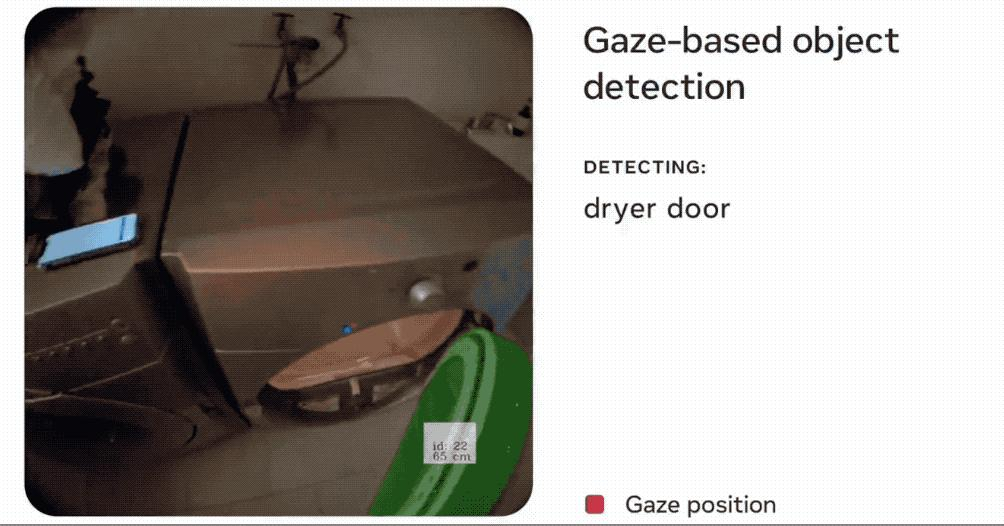

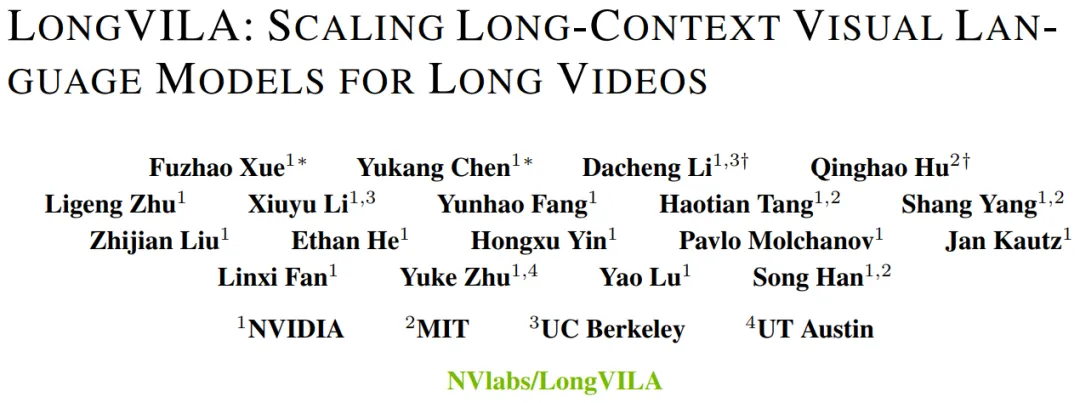

现在,长上下文视觉语言模型(VLM)有了新的全栈解决方案 ——LongVILA,它集系统、模型训练与数据集开发于一体。

“乱世”其实早已到来,只不过这次是公开承认了这个现实。

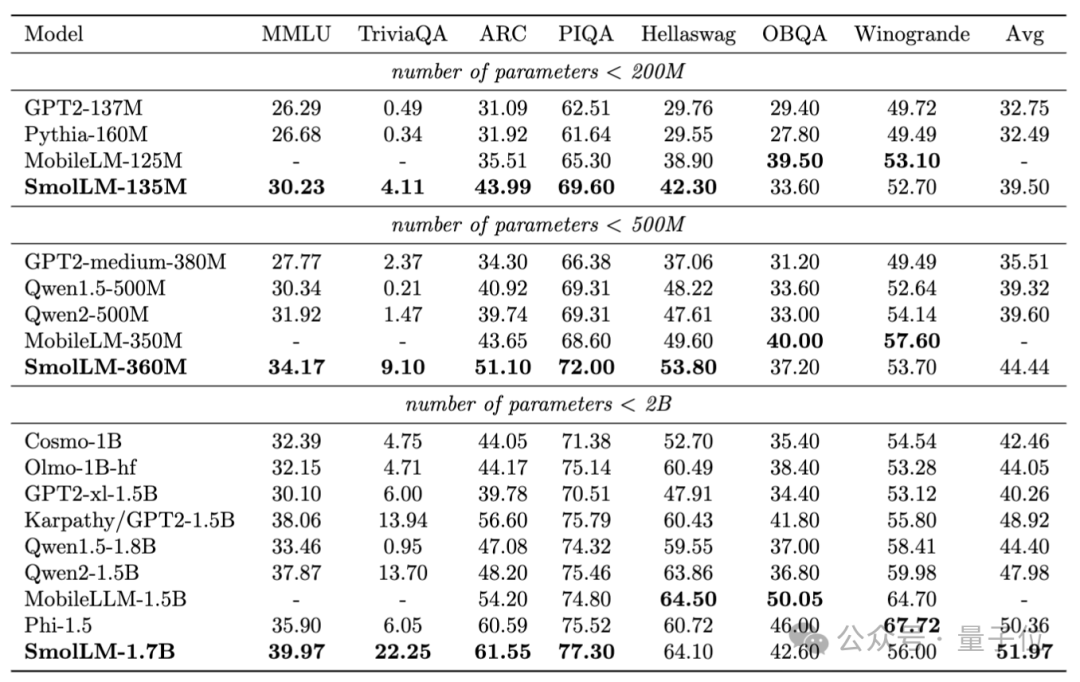

浏览器里直接能跑的SOTA小模型来了,分别在2亿、5亿和20亿级别获胜,抱抱脸出品。

近日,HCM领域的SaaS巨头Workday和全球排名第一的CRM企业Salesforce达成AI战略合作,意在结合Salesforce在客户关系管理领域方面的专业知识以及Workday在人力资源、财务管理方面的优势,试图通过当下先进的人工智能功能和统一的数据集成技术重新构想全新的企业软件。

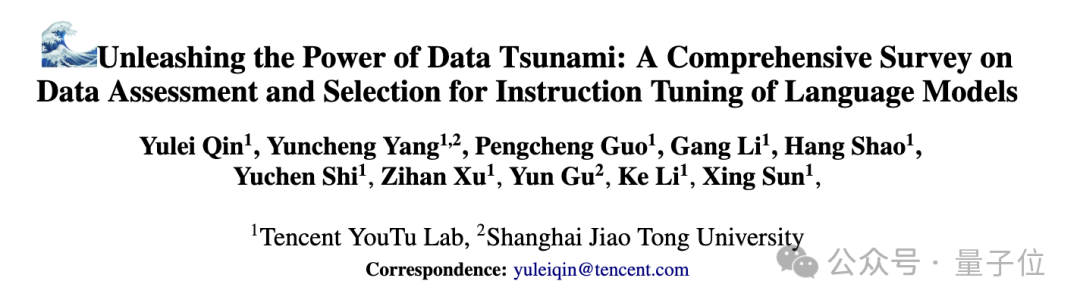

随着大模型的快速发展,指令调优在提升模型性能和泛化能力方面发挥着至关重要的作用。

人工智能系统依靠充足、高质量的训练数据来获得高性能,但MIT等机构最近的一项研究发现,曾经免费提供的数据在多个方面变得越来越难获取。

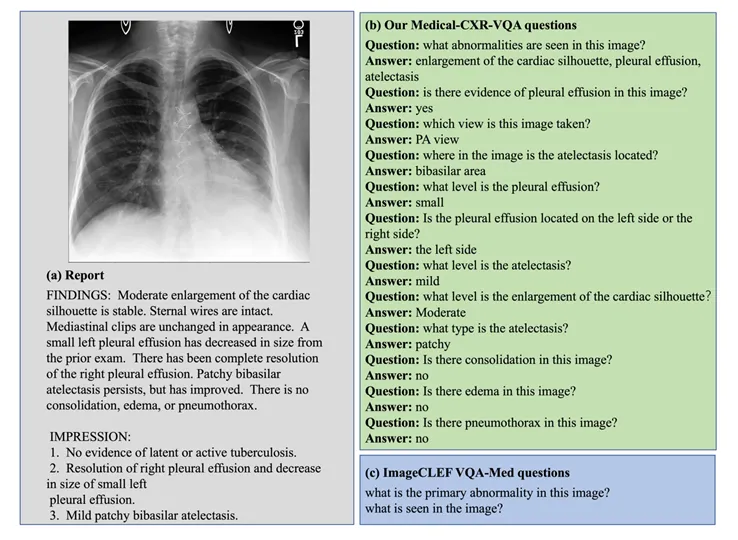

多模态大语言模型 (Multimodal Large Language Moodel, MLLM) 以其强大的语言理解能力和生成能力,在各个领域取得了巨大成功。

最近的英伟达似乎步入了多事之秋。