CVPR 2024满分论文|英伟达开源大模型FoundationPose称霸BOP排行榜

CVPR 2024满分论文|英伟达开源大模型FoundationPose称霸BOP排行榜FoundationPose模型使用RGBD图像对新颖物体进行姿态估计和跟踪,支持基于模型和无模型设置,在多个公共数据集上大幅优于针对每个任务专门化的现有方法.

FoundationPose模型使用RGBD图像对新颖物体进行姿态估计和跟踪,支持基于模型和无模型设置,在多个公共数据集上大幅优于针对每个任务专门化的现有方法.

在探索人工智能边界时,我们时常惊叹于人类孩童的学习能力 —— 可以轻易地将他人的动作映射到自己的视角,进而模仿并创新。当我们追求更高阶的人工智能的时候,无非是希望赋予机器这种与生俱来的天赋。

3月29日,以“数据驱动,智绘未来”为主题的2024北京AI原生产业创新大会暨北京数据基础制度先行区成果发布会举办。会上,北京国际大数据交易所(以下简称“北数所”)牵头正式发布首批100个人工智能大模型高质量训练数据集,经联盟牵头推荐,中关村数字媒体产业联盟成员单位新华网、山东工艺美术学院、中国搜索、中文在线、北京服装学院、硅星人等院校、企业的高质量数据集入选。

如果让你在互联网上给大模型选一本中文教材,你会去哪里取材?是知乎,是豆瓣,还是微博?一个研究团队为了构建高质量的中文指令微调数据集,对这些社交媒体进行了测试,想找到训练大模型最好的中文预料,结果答案保证让你大跌眼镜——

「被门夹过的核桃,还能补脑吗?」

离大谱了,弱智吧登上正经AI论文,还成了最好的中文训练数据??

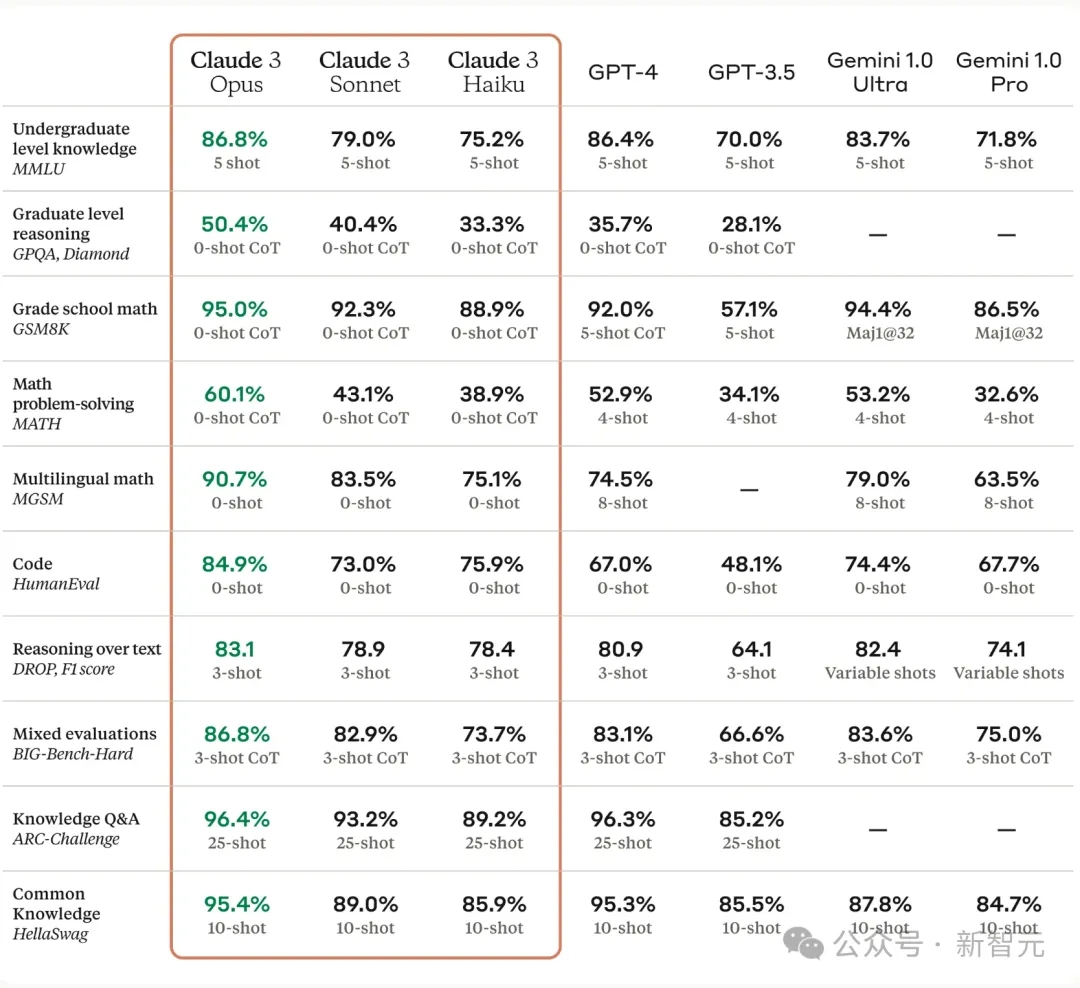

Claude 3不但数据集跑分领先,用户体验上也将成为最强大的LLM,GPT-5在哪里?

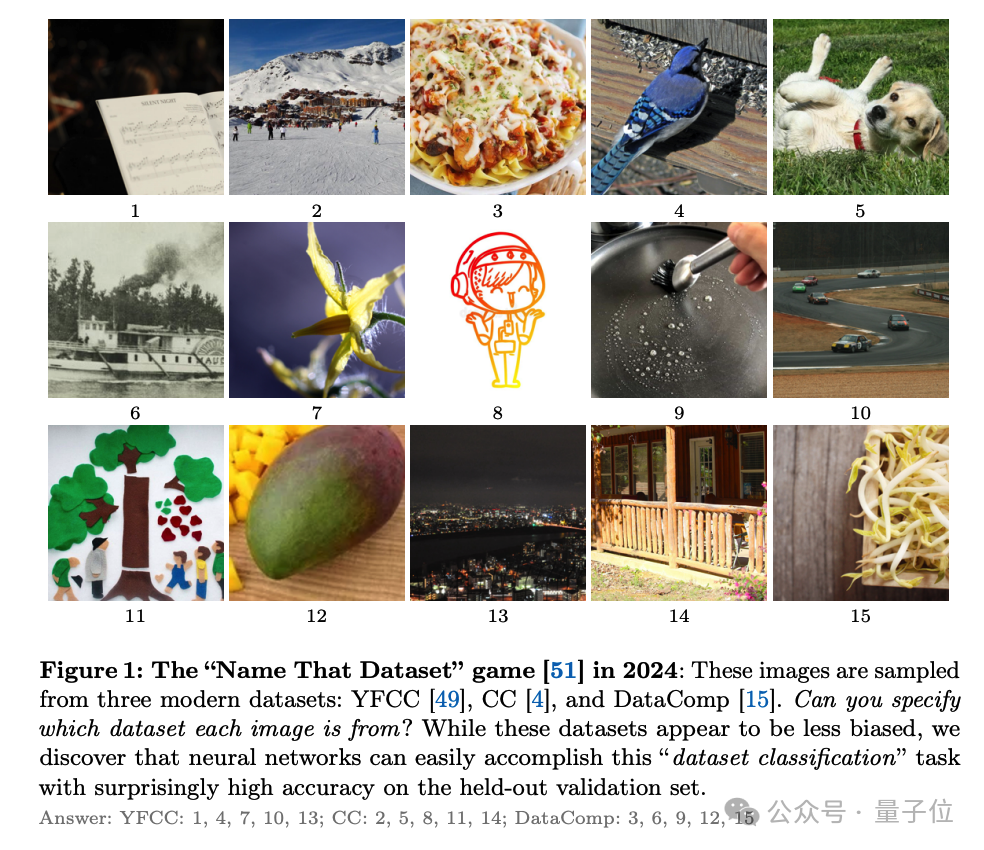

MIT新晋副教授何恺明,新作新鲜出炉:瞄准一个横亘在AI发展之路上十年之久的问题:数据集偏差。数据集偏差之战,在2011年由知名学者Antonio Torralba和Alyosha Efros提出——

StepCoder将长序列代码生成任务分解为代码完成子任务课程来缓解强化学习探索难题,对未执行的代码段以细粒度优化;还开源了可用于强化学习训练的APPS+数据集。

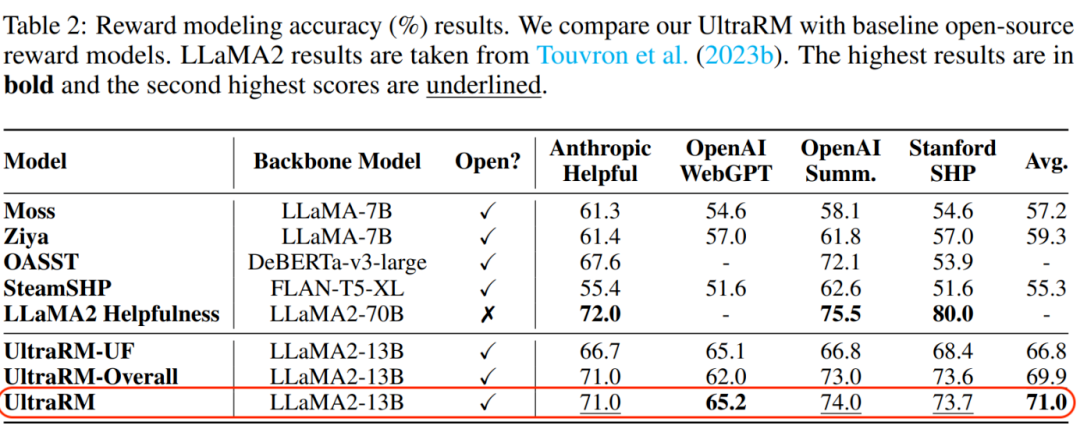

迄今,全球超 200 个模型基于来自 OpenBMB 开源社区的 Ultra Series 数据集(面壁 Ultra 对齐数据集)对齐,数据集包括 UltraFeedback 和 UltraChat,共计月均下载量超 100 万。