昆仑万维开源最强多模态推理模型!性能逼近人类专家,还超了OpenAI、Anthropic

昆仑万维开源最强多模态推理模型!性能逼近人类专家,还超了OpenAI、Anthropic今日,昆仑万维重磅开源多模态推理模型Skywork-R1V 3.0,这是其迄今最强多模态推理模型,参数规模为38B,在多个多模态推理基准测试中取得了开源最佳(SOTA)性能。

今日,昆仑万维重磅开源多模态推理模型Skywork-R1V 3.0,这是其迄今最强多模态推理模型,参数规模为38B,在多个多模态推理基准测试中取得了开源最佳(SOTA)性能。

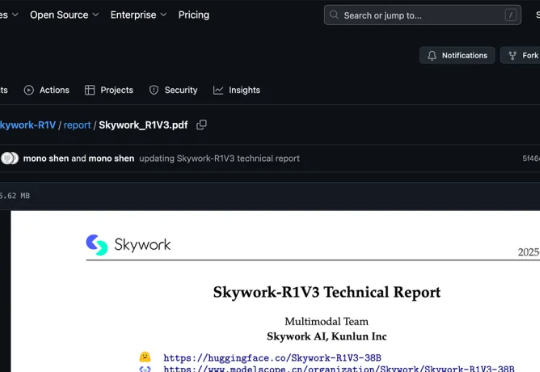

Skywork-Reward-V2全新发布!巧妙构建超高质量的千万级人类偏好样本,刷新七大评测基准SOTA表现。8款模型覆盖6亿至80亿参数,小体积也能媲美大模型性能。

大语言模型(LLM)以生成能力强而著称,但如何能让它「听话」,是一门很深的学问。 基于人类反馈的强化学习(RLHF)就是用来解决这个问题的,其中的奖励模型 (Reward Model, RM)扮演着重要的裁判作用,它专门负责给 LLM 生成的内容打分,告诉模型什么是好,什么是不好,可以保证大模型的「三观」正确。

国内大厂探索AI变现呈现四类方式:模型产品(订阅)、模型服务(MaaS)、AI功能嵌入主业、算力基础设施。百度、阿里、腾讯、华为处于第一梯队,AI显著拉动营收增长;快手、字节、美图属第二梯队,AI提效主业或打造爆款应用初见成效;科大讯飞、昆仑万维尚处投入期。虽部分路径初步盈利,但巨额研发投入远超当前回报,尚无企业实现AI正现金流,技术投入更多带来市值提升效应。

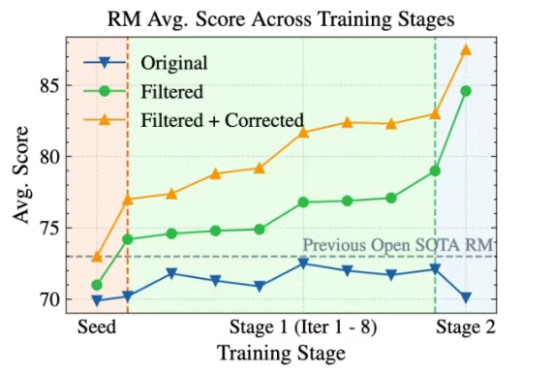

左超Manus,右跨Genspark,GAIA榜单上又一家中国公司登顶!

我一直说,每个行业,都一定会有专门优化的垂直领域的Agent。

世界模型的进度条,最近坐上了火箭。

「矩阵」不再是科幻!Matrix-Game震撼来袭,突破边界带来交互式引擎。只需一句话,沙漠森林等任意场景可控生成,动作丝滑操控,360°视角自由切换,沉浸感爆棚。

昆仑自研的AI模型(SOTA)就像是“最好的锄头”,正在助力公司开采AIGC领域那片“最肥沃的金矿”。

4月25日,昆仑万维发布最新财报,2024年营收56.62亿元,同比增长15.2%,净利润亏损15.95亿元,同比下跌226.8%。这也是上市十年,昆仑万维首度亏损的一年。