刚刚,DeepSeek又探索新架构了,开源OCR 2

刚刚,DeepSeek又探索新架构了,开源OCR 2嘿!刚刚,DeepSeek 又更新了!这次是更新了十月份推出的 DeepSeek-OCR 模型。刚刚发布的 DeepSeek-OCR 2 通过引入 DeepEncoder V2 架构,实现了视觉编码从「固定扫描」向「语义推理」的范式转变!

嘿!刚刚,DeepSeek 又更新了!这次是更新了十月份推出的 DeepSeek-OCR 模型。刚刚发布的 DeepSeek-OCR 2 通过引入 DeepEncoder V2 架构,实现了视觉编码从「固定扫描」向「语义推理」的范式转变!

过去一年,AI的主战场几乎被大模型、生图和生视频占满。2026年伊始,市场终于开始把目光投向一个更难、也更关键的领域:3D生成。

大模型能写代码、聊八卦,但敢不敢让它直接接管网络运维?一项最新评测显示,面对真实网络故障,头部模型平均准确率竟不足50%!为此,GSMA联手全球巨头开启「地狱级」难度挑战赛,通往MWC 2026的门票已备好,3.5万欧元大奖等你来拿!

DeepSeek开源DeepSeek-OCR2,引入了全新的DeepEncoder V2视觉编码器。该架构打破了传统模型按固定顺序(从左上到右下)扫描图像的限制,转而模仿人类视觉的「因果流(Causal Flow)」逻辑。

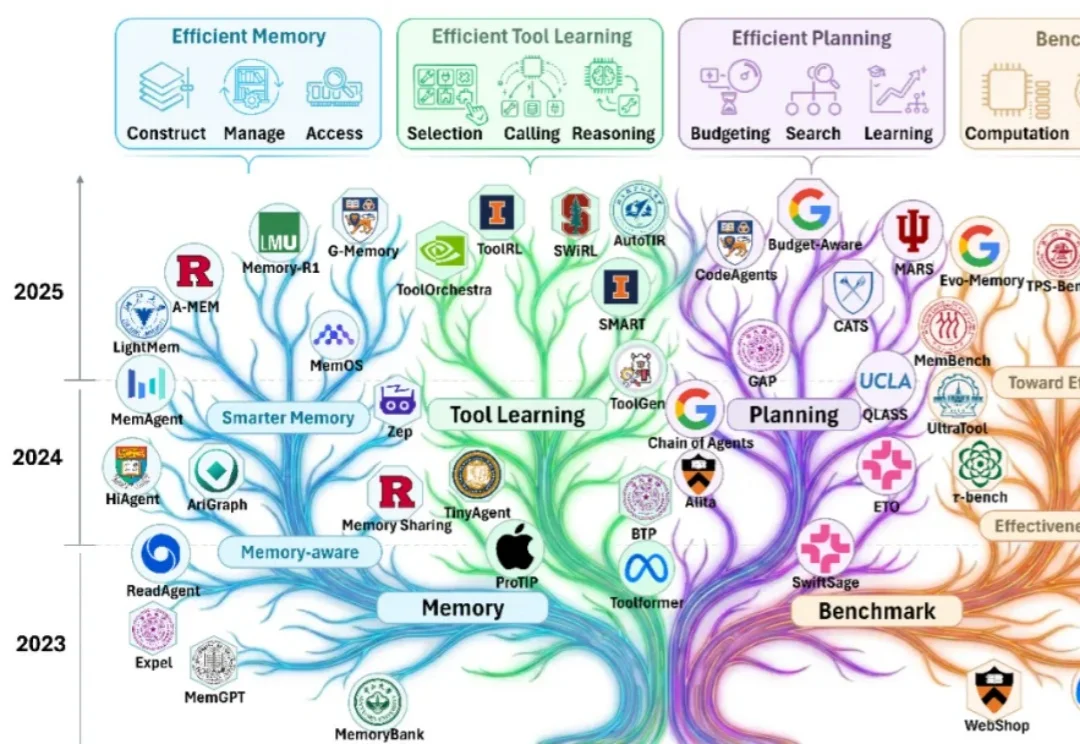

随着大模型能力的跃迁,业界关注点正在从 “模型能不能做” 快速转向 “智能体能不能落地”。过去一年可以看到大量工作在提升智能体的有效性(effectiveness):如何让它更聪明、更稳、更会用工具、更能完成复杂任务。

Attention真的可靠吗?

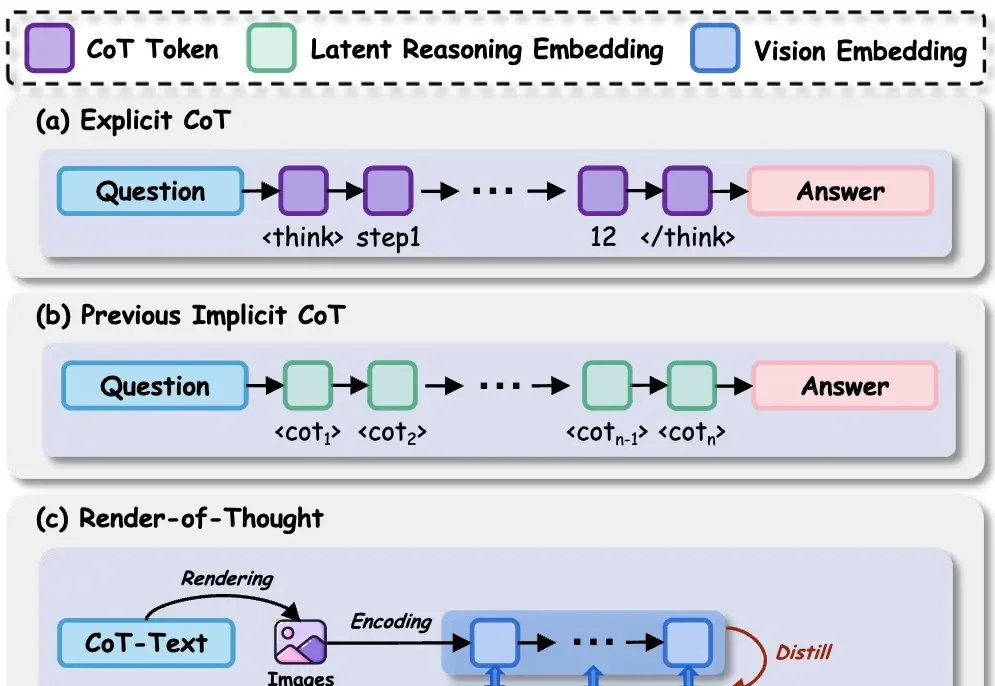

在 LLM 时代,思维链( CoT)已成为解锁模型复杂推理能力的关键钥匙。然而,CoT 的冗长问题一直困扰着研究者——中间推理步骤和解码操作带来了巨大的计算开销和显存占用,严重制约了模型的推理效率。

在达沃斯论坛之后,谷歌Deepmind CEO Demis Hassabis又连续上了两个播客,放出了不少谷歌的新动向!

大模型持续学习,又有新进展!

这一框架可用于集成额外文本、语音和视觉等多种模态。