谢赛宁新作:VAE退役,RAE当立

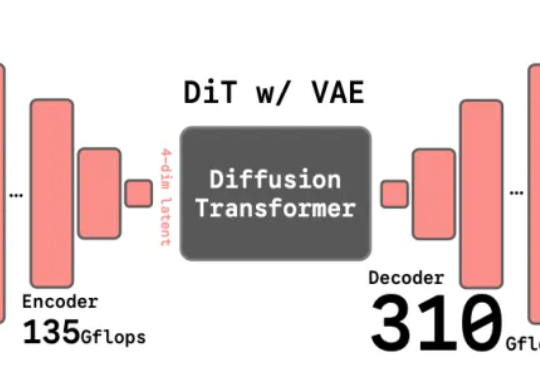

谢赛宁新作:VAE退役,RAE当立谢赛宁团队最新研究给出了答案——VAE的时代结束,RAE将接力前行。其中表征自编码器RAE(Representation Autoencoders)是一种用于扩散Transformer(DiT)训练的新型自动编码器,其核心设计是用预训练的表征编码器(如DINO、SigLIP、MAE 等)与训练后的轻量级解码器配对,从而替代传统扩散模型中依赖的VAE(变分自动编码器)。

谢赛宁团队最新研究给出了答案——VAE的时代结束,RAE将接力前行。其中表征自编码器RAE(Representation Autoencoders)是一种用于扩散Transformer(DiT)训练的新型自动编码器,其核心设计是用预训练的表征编码器(如DINO、SigLIP、MAE 等)与训练后的轻量级解码器配对,从而替代传统扩散模型中依赖的VAE(变分自动编码器)。

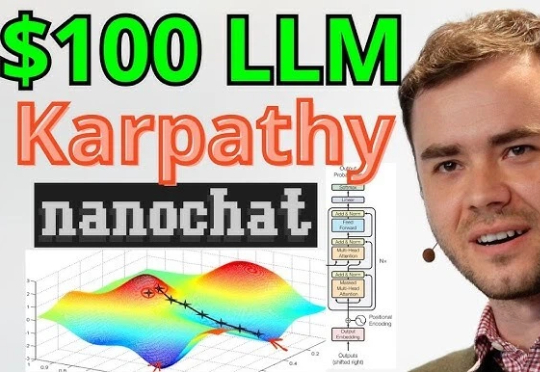

AI传奇人物、前特斯拉AI总监Karpathy重磅推出全新开源项目「nanochat」,以不到8000行代码复现ChatGPT全流程,只需一台GPU、约4小时、成本仅百美元。该项目在GitHub上线不到12小时即获4.2k星标!

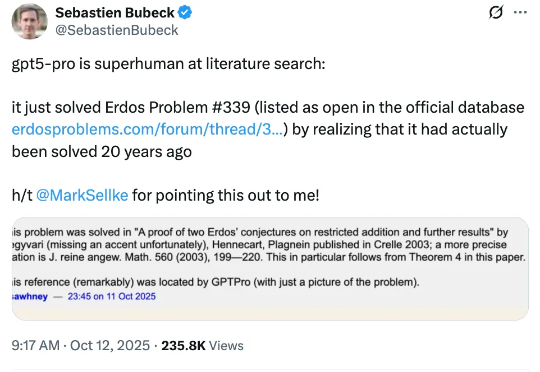

人类遗忘的难题解法,被GPT-5 Pro重新找出来了!这事儿聚焦于埃尔德什问题#339,这是著名数学家保罗・埃尔德什提出或转述的近千道问题之一,收录于erdosproblems.com网站。该网站记录了每道题目的当前状态,其中约三分之一已解决,大部分仍待解。

嗨大家好!我是阿真! 7月份我写了一篇关于每个AI生图模型的优劣势的总结,因为工作需要,我针对不同需求会切换很多工具,另外产品更新需要及时测评时不时买个月度会员,单月买的不算在内,当时我经常消费的几个

为什么大模型,在执行长时任务时容易翻车?这让一些专家,开始质疑大模型的推理能力,认为它们是否只是提供了「思考的幻觉」。近日,剑桥大学等机构的一项研究证明:问题不是出现在推理上,而是出在大模型的执行能力上。

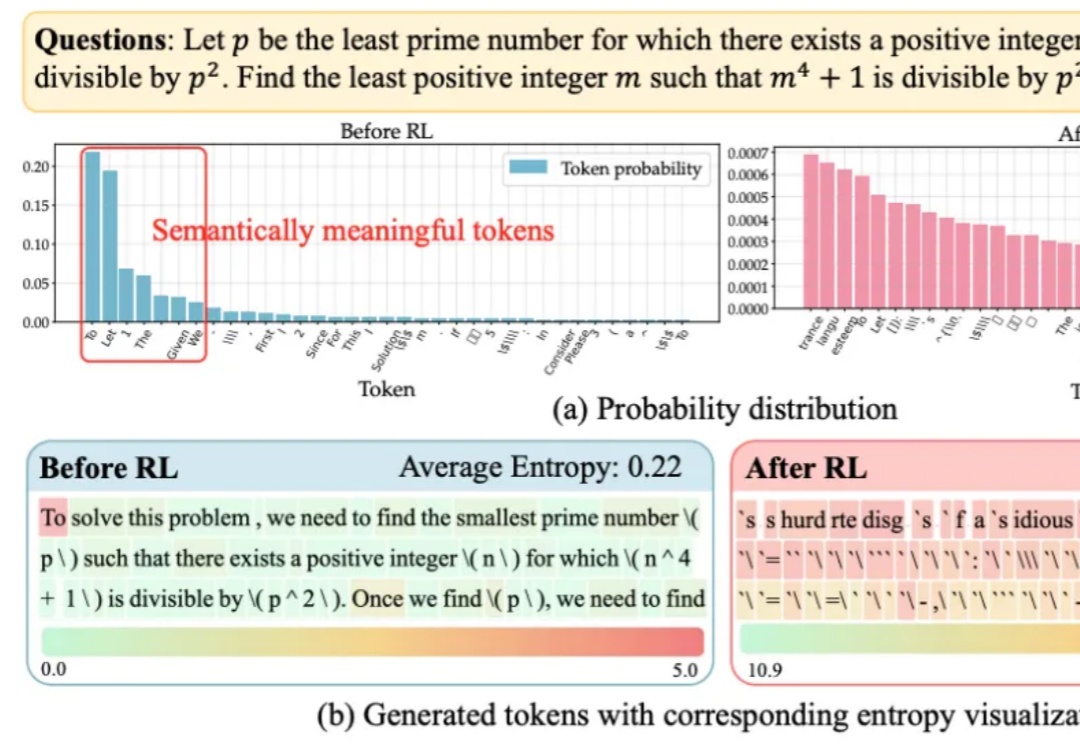

大语言模型在RLVR训练中面临的“熵困境”,有解了!

当全球的目光还在聚焦基座模型的参数竞赛时,一场更为深刻的变革正在悄然发生——后训练(Post-Training)。

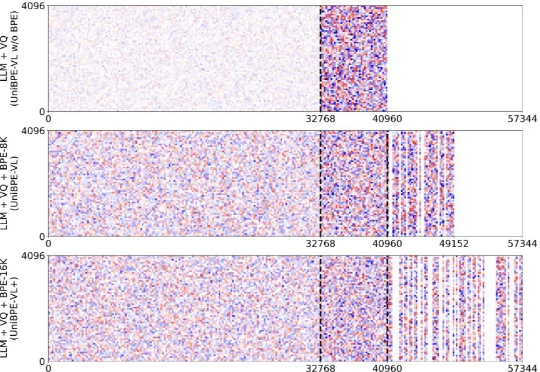

为此,北大、UC San Diego 和 BeingBeyond 联合提出一种新的方法——Being-VL 的视觉 BPE 路线。Being-VL 的出发点是把这一步后置:先在纯自监督、无 language condition 的设定下,把图像离散化并「分词」,再与文本在同一词表、同一序列中由同一 Transformer 统一建模,从源头缩短跨模态链路并保留视觉结构先验。

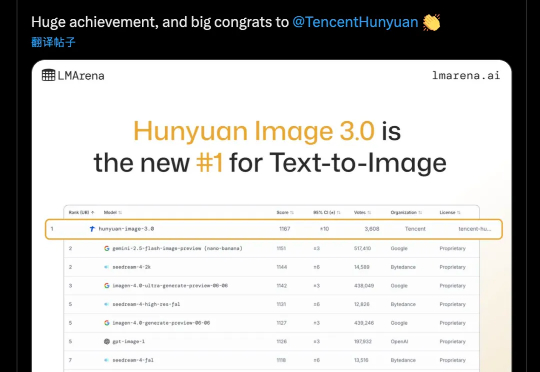

讲真,AI生图圈的内卷速度简直离谱。8月底的Nano Banana、9月中的即梦4.0已经把画质和效果卷到了一个新高度,但我还在纠结到底该把谁设为主力工具,因为总觉得他们差点什么:不是出错就是不懂场景。

谷歌下一代旗舰模型Gemini 3未发布便已悄然走红!原因很简单:强,实在是太强了。在国外社交媒体平台𝕏上,一大波网友激动地分享了Gemini 3的内测结果——从曝光的这些案例来看,Gemini 3尤为擅长前端、SVG矢量图生成,而且多模态能力变得更强。