Nature重磅!科学家开发AI医疗大模型Delphi-2M,提前20年预测上千种疾病!准确率行业领先!

Nature重磅!科学家开发AI医疗大模型Delphi-2M,提前20年预测上千种疾病!准确率行业领先!来自德国癌症研究中心(DKFZ)、欧洲分子生物学实验室(EMBL)、哥本哈根大学等机构的研究团队开发了一款名为Delphi-2M的AI医疗大模型。该模型能通过分析用户的医疗记录和生活方式,并提供长达了20年,覆盖癌症、皮肤病和免疫疾病等1258种疾病的风险估计。

来自德国癌症研究中心(DKFZ)、欧洲分子生物学实验室(EMBL)、哥本哈根大学等机构的研究团队开发了一款名为Delphi-2M的AI医疗大模型。该模型能通过分析用户的医疗记录和生活方式,并提供长达了20年,覆盖癌症、皮肤病和免疫疾病等1258种疾病的风险估计。

正所谓“得数据者得天下”,这家央企算是把高质量数据集给玩明白了——超过10万亿tokens的通用大模型语料数据,以及覆盖14个关键行业的专业数据集,总存储量高达350TB!

我一个 AI 圈的,为啥会关注到电影圈呢?倒不是因为我爱看电影,而是因为电影节的放映单元,突然冒出来了我们圈子里几个“老熟人”:Seedream(图像创作模型)、Seedance(视频生成模型)、即梦 AI。

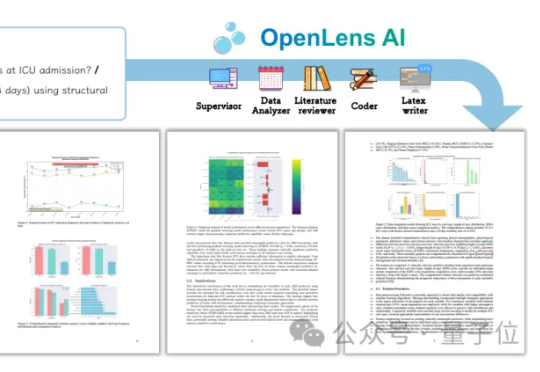

医学研究迎来“零人工”时代了?!清华大学自动化系索津莉课题组,发布首个专为医疗信息学设计的全自主AI研究框架——OpenLens AI。首次实现从文献挖掘→实验设计→数据分析→代码生成→可投稿论文的全链条自动化闭环。

9 月 25 日,生数科技新一代图生视频大模型 Vidu Q2 正式全球上线,打破了原有 AI 生成的表情太假,动作飘忽不定,运动幅度不够大,无法指哪打哪的行业问题,实现从 “视频生成” 到 “演技生成”,从 “动态流畅” 到 “情感表达” 的革命性跨越,标志着 AI 视频生成技术正式从追求 “形似” 进入追求 “神似” 的新纪元

其实大语言模型的“教育”问题也差不多。研究者在训练和使用这些模型时,离不开提示词。这就像一份人生剧本,告诉模型“你是谁?”“你要做什么?”“你能做到哪里?”但问题是,提示词到底应该像家长一样,

谷歌最新发布的Gemini Robotics 1.5系列模型,让机器人真正学会了「思考」,还能跨不同具身形态学习技能。这意味着,未来的机器人将成为和人类协作、主动完成复杂任务的智能伙伴。

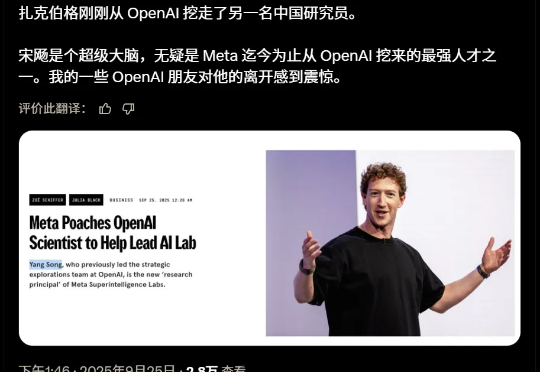

刚刚,Meta又从OpenAI挖来一员猛将——宋飏,扩散模型领域的核心人物,DALL·E 2技术路径的早期奠基者。他已正式加入Meta Superintelligence Labs,担任研究负责人,直接向他的师兄赵晟佳汇报。

今天,月之暗面正式发布全新 Agent,产品名别具一格:「OK Computer」。在大模型厂商进入战略对决关键时刻,这声“OK”,到底 O 不 OK?

就在刚刚!全球最受瞩目的 AI 音乐平台 Suno,正式迎来了史诗级的重大更新—— V5 模型炸裂上线!这一次,Suno 直接放出了它口中 “迄今为止最强大的音乐基础模型”: