发布 ChatGPT 健康 6 天后,OpenAI 在自家医疗健康 Benchmark 上被百川M3模型反超

发布 ChatGPT 健康 6 天后,OpenAI 在自家医疗健康 Benchmark 上被百川M3模型反超百川智能表示今年上半年,将陆续发布两款 to C 的医疗产品。 作者|Li Yuan 编辑|郑玄 你有没有向 AI 助手问过你的健康问题? 如果你和我一样是一个 AI 的深度用户,大概率你也试过。 O

百川智能表示今年上半年,将陆续发布两款 to C 的医疗产品。 作者|Li Yuan 编辑|郑玄 你有没有向 AI 助手问过你的健康问题? 如果你和我一样是一个 AI 的深度用户,大概率你也试过。 O

一份大模型中标数据报告,揭示了产业重心转移的清晰轨迹:应用类项目占比近六成,市场用真金白银为 “落地” 投票。2025 年,中国大模型产业在招投标市场上演了一场令人瞠目的 “狂飙”。智能超参数的监测数据显示,全年大模型相关中标项目数量达到 7539 个,披露金额 295.2 亿元,较 2024 年分别激增 396% 与 356%。市场正以前所未有的速度,将技术潜力兑换为商业订单。

发现一个很有意思的现象,模型能力已经不是瓶颈了。

假如你是一个致力于将 AI 引入传统行业的工程团队。现在,你有一个问题:训练一个能看懂复杂机械图纸、设备维护手册或金融研报图表的多模态助手。这个助手不仅要能专业陪聊,更要能精准地识别图纸上的零件标注,或者从密密麻麻的财报截图中提取关键数据。

故事得从我们那个行业交流群说起。

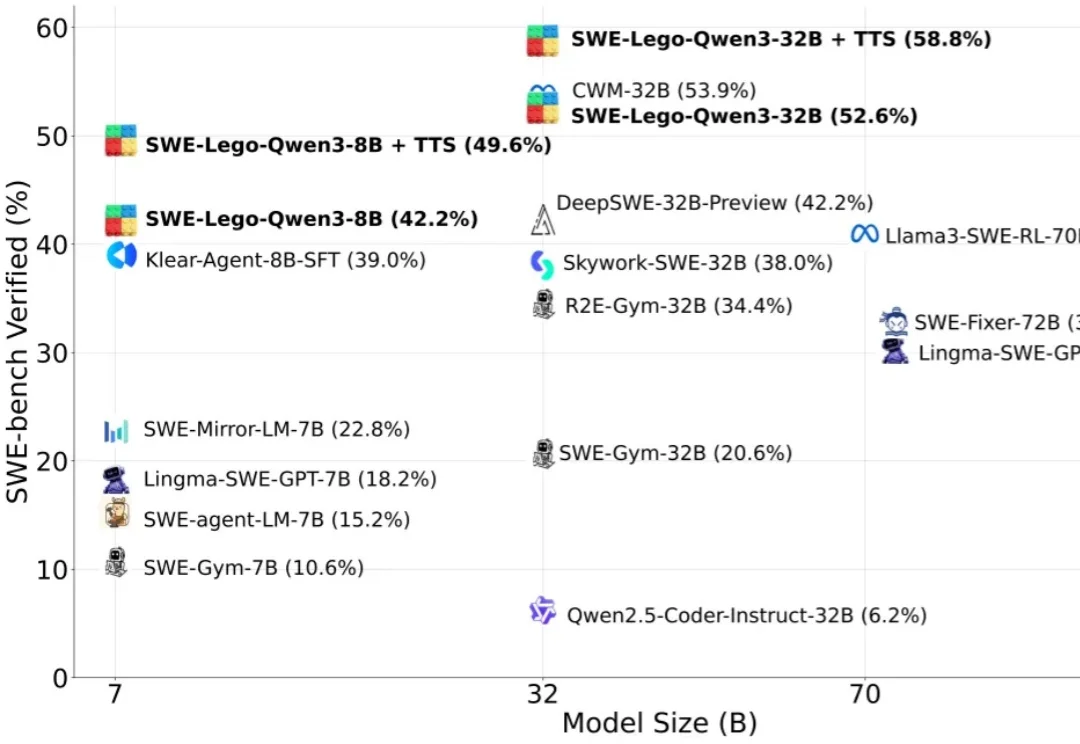

“软工任务要改多文件、多轮工具调用,模型怎么学透?高质量训练数据稀缺,又怕轨迹含噪声作弊?复杂 RL 训练成本高,中小团队望而却步?”

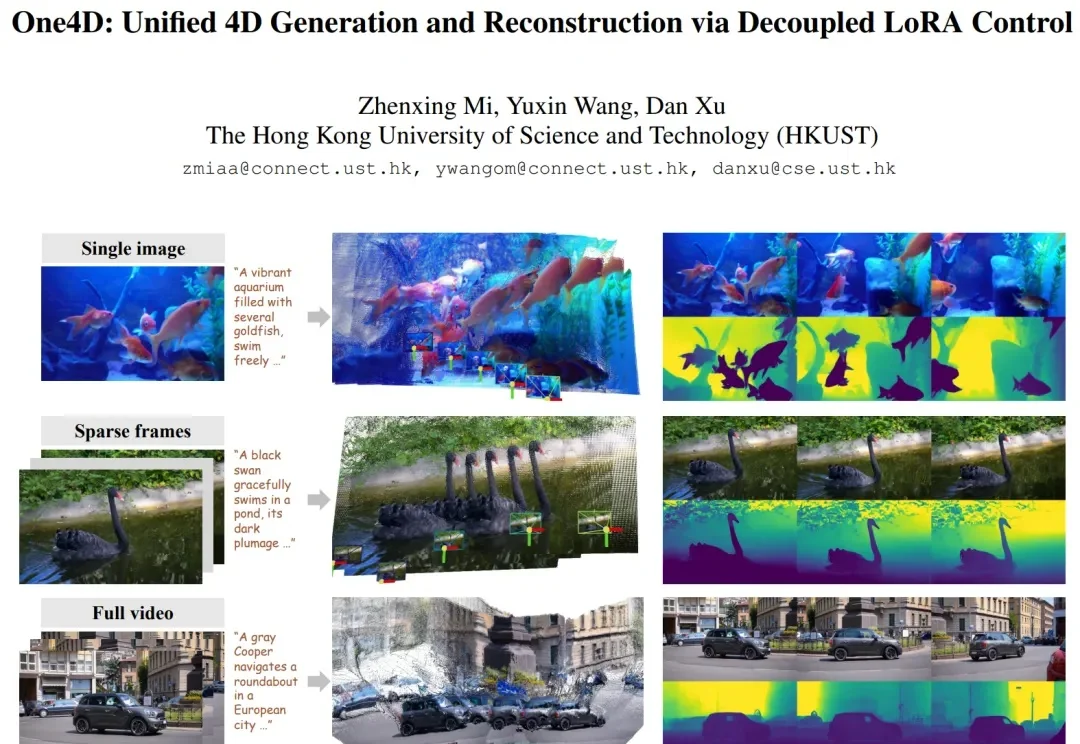

近年来,视频扩散模型在 “真实感、动态性、可控性” 上进展飞快,但它们大多仍停留在纯 RGB 空间。模型能生成好看的视频,却缺少对三维几何的显式建模。这让许多世界模型(world model)导向的应用(空间推理、具身智能、机器人、自动驾驶仿真等)难以落地,因为这些任务不仅需要像素,还需要完整地模拟 4D 世界。

深夜,梁文锋署名的DeepSeek新论文又来了。这一次,他们提出全新的Engram模块,解决了Transformer的记忆难题,让模型容量不再靠堆参数!

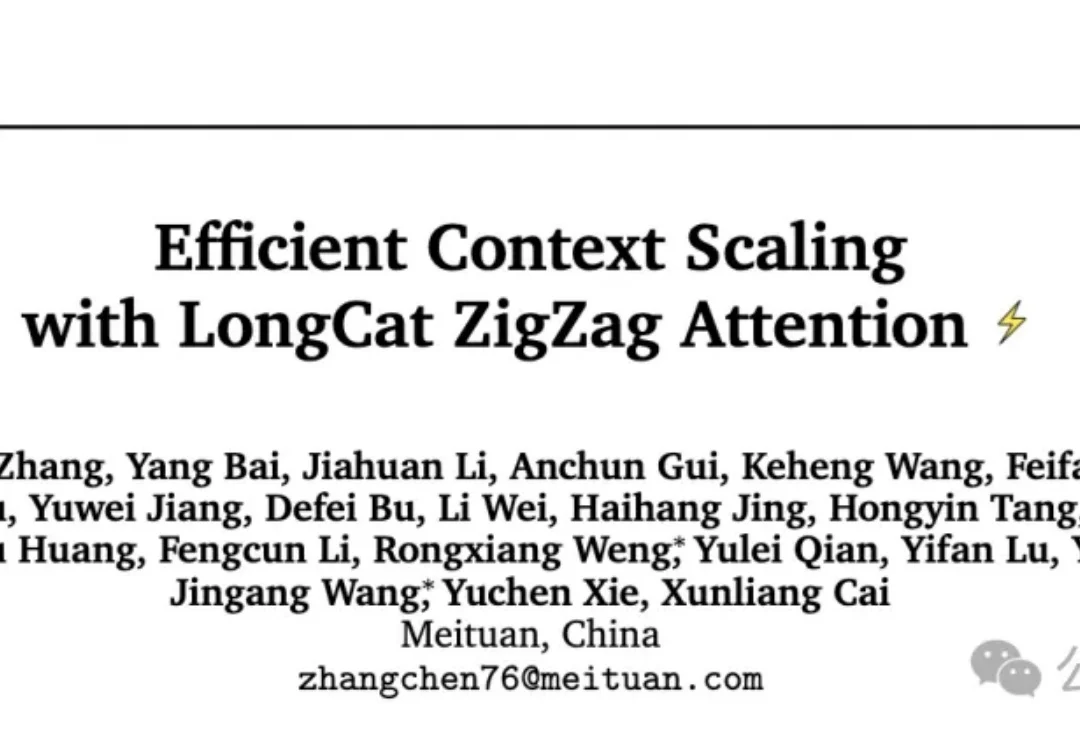

256K文本预加载提速超50%,还解锁了1M上下文窗口。

现在,我们越来越多地将大语言模型应用于搜索、编程、内容生成和决策辅助等现实场景中。尽管每天有数百万人使用大模型,但它的问题也随之而来,例如有时会产生幻觉,甚至在特定情境下表现出误导或欺骗用户的倾向。