刚刚,苹果官宣 iPhone 将搭载最强 AI!马斯克第一个跳出来骂

刚刚,苹果官宣 iPhone 将搭载最强 AI!马斯克第一个跳出来骂一觉醒来,你的 iPhone 即将用上最强 AI 了。就在刚刚,苹果和 Google 发布联合声明,双方达成达成多年深度合作协议。下一代「苹果基础模型」将直接基于 Google 的 Gemini 模型和云技术构建。

一觉醒来,你的 iPhone 即将用上最强 AI 了。就在刚刚,苹果和 Google 发布联合声明,双方达成达成多年深度合作协议。下一代「苹果基础模型」将直接基于 Google 的 Gemini 模型和云技术构建。

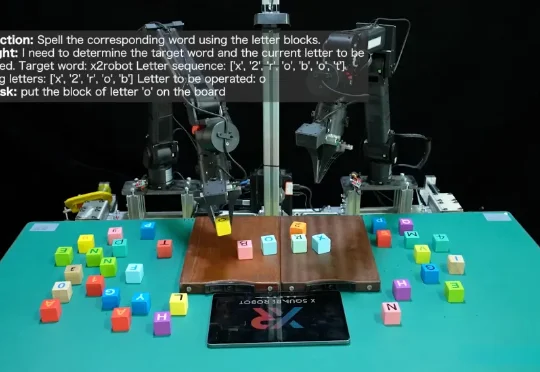

机器人终于迎来自己的「iOS时刻」,全球首个具身Agentic OS来了:不是装个更聪明的大模型,而是给机器人配上一套真正的「操作系统」。

未来不远(Futuring Robot)正式宣布完成 2 亿元的天使轮融资,目前已经完成家庭通用机器人领域端到端模型落地,真实家庭实测,C 端商业化等重大阶段。

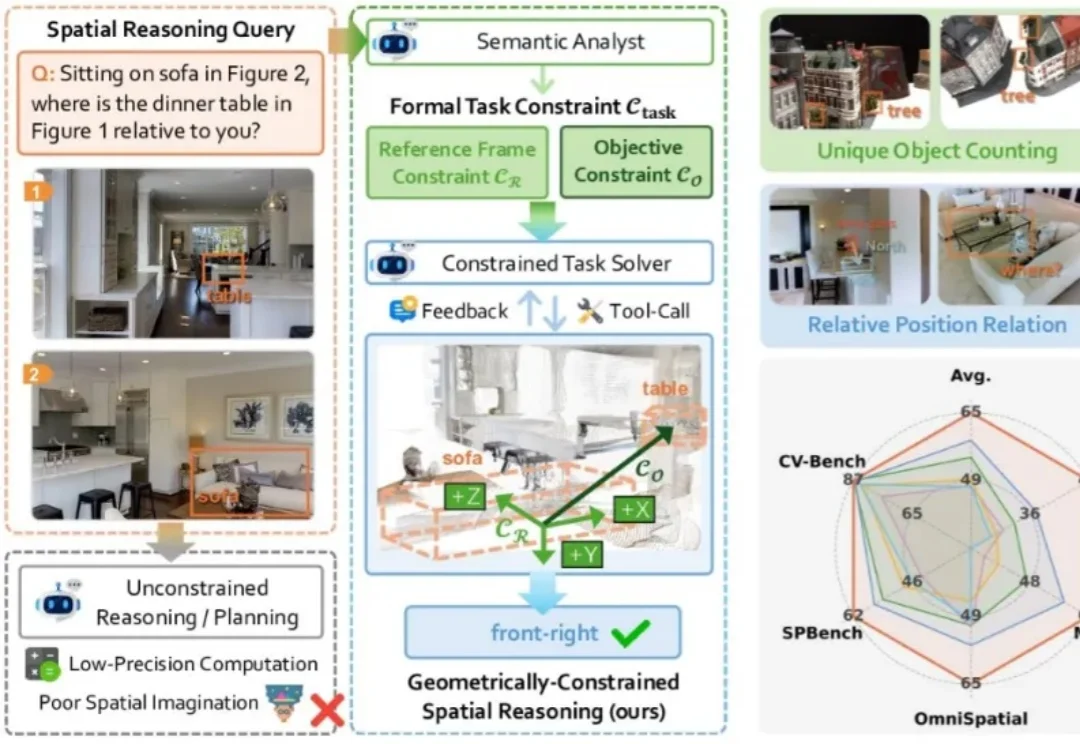

现有的视觉大模型普遍存在「语义-几何鸿沟」(Semantic-to-Geometric Gap),不仅分不清东南西北,更难以处理精确的空间量化任务。例如问「你坐在沙发上时,餐桌在你的哪一侧?」,VLM 常常答错。

在文章开始前,请您先打开Claude code,输入/skill,检查一下您的Claude code有多少个skills?是20个?50个?还是已经突破了100个?自从Anthropic推广Agent Skills以来,我们都爱上了这种“即插即用”的模块化体验。它把臃肿的多智能体编排(MAS)变成了一组优雅的Markdown文件调用,让API账单和延迟同时暴跌了50%以上。

企业级场景中,无论是做RAG还是agent,我们都会面临一个问题:出于数据隐私以及合规要求,数据必须保留在本地。但传统的本地存储方案往往存在数据隔离性差、崩溃易丢数据、配置管理混乱、操作不可撤销等问题。

2026年开年之际,具身智能赛道迎来了首个重磅融资事件,自变量机器人宣布完成十亿元A++轮融资。本轮融资由字节跳动、红杉中国、深创投、北京信息产业发展基金、锡创投、南山战新投等顶级投资机构及多元地方平台联合投资。据悉,这也是深创投AI基金成立以来的第一笔投资。

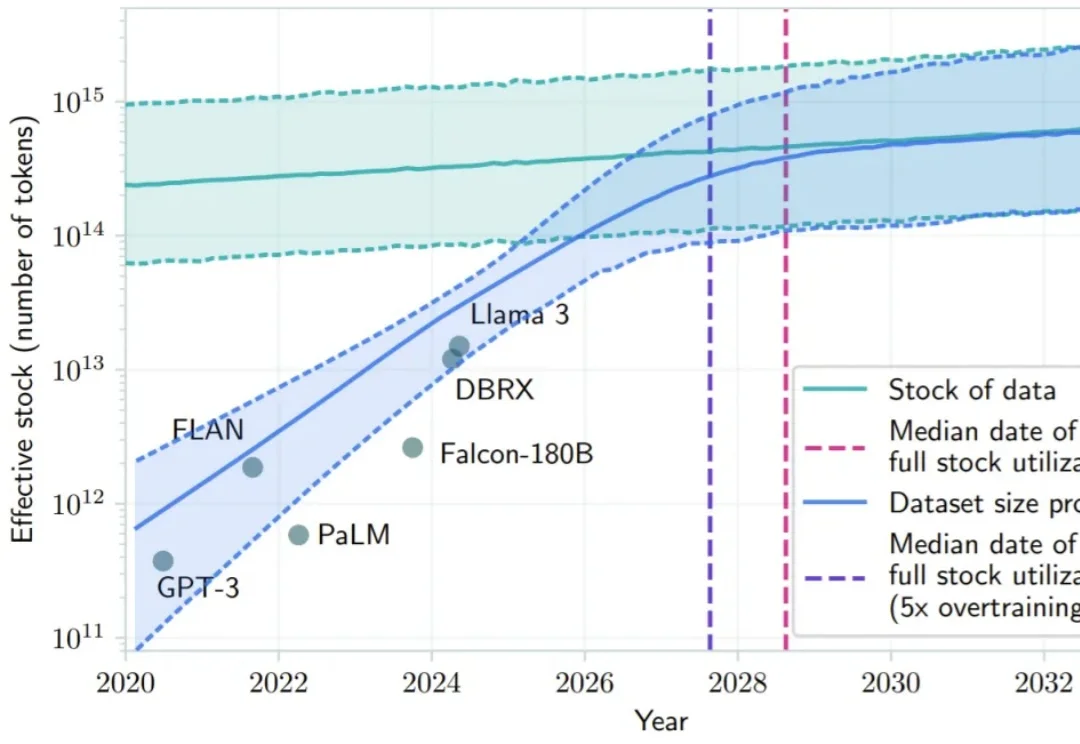

2024 年底,硅谷和北京的茶水间里都在讨论同一个令人不安的话题:Scaling Law 似乎正在撞墙。

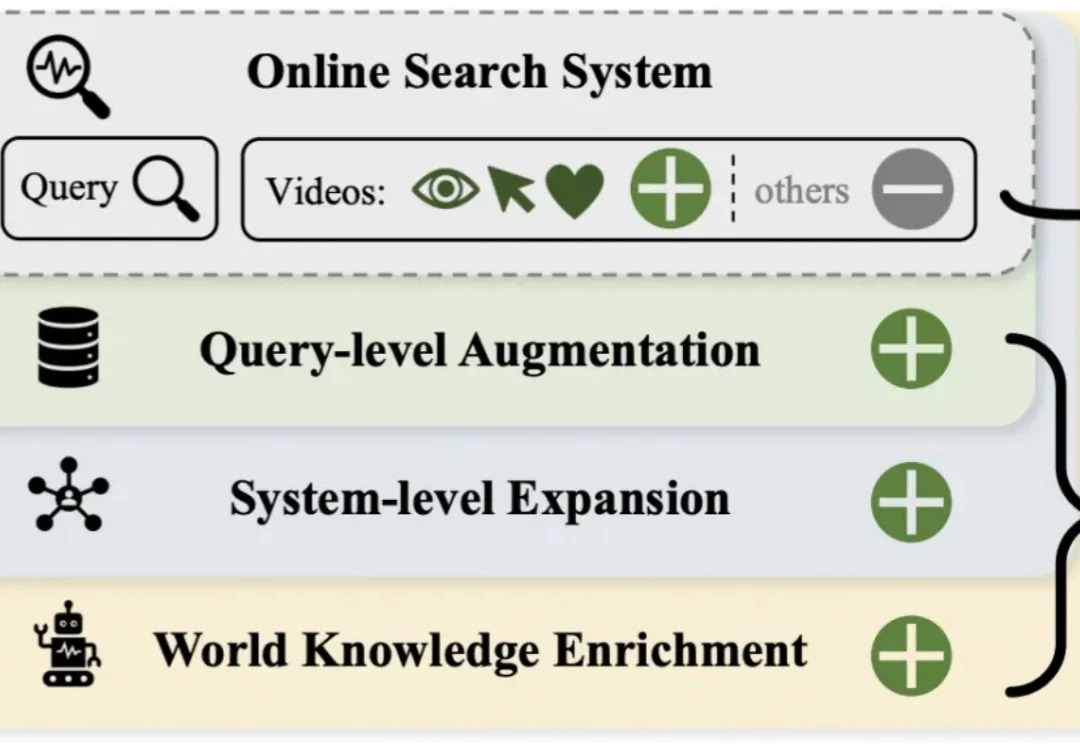

短视频搜索业务是向量检索在工业界最核心的应用场景之一。然而,当前业界普遍采用的「自强化」训练范式过度依赖历史点击数据,导致系统陷入信息茧房,难以召回潜在相关的新鲜内容。

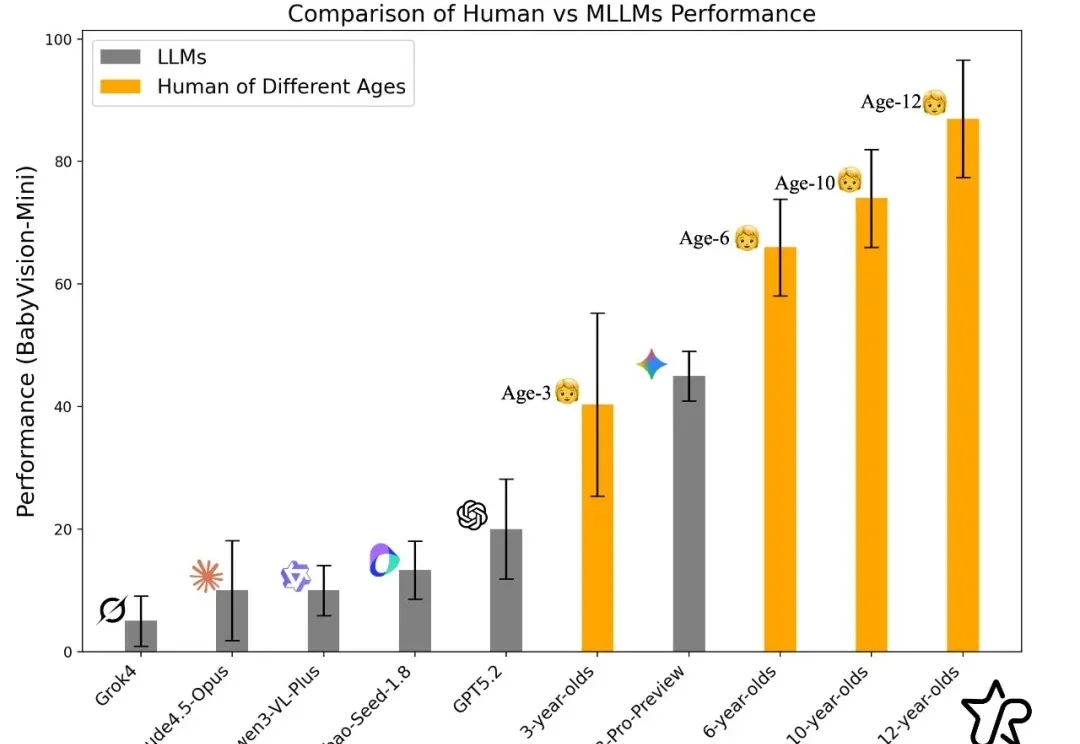

过去一年,大模型在语言与文本推理上突飞猛进:论文能写、难题能解、甚至在顶级学术 / 竞赛类题目上屡屡刷新上限。但一个更关键的问题是:当问题不再能 “用语言说清楚” 时,模型还能不能 “看懂”?