当AI学会欺骗,我们该如何应对?

当AI学会欺骗,我们该如何应对?前沿模型越来越多地被训练和部署为自主智能体。一个安全担忧是,AI智能体可能会隐秘地追求与人类目标不一致的目标,隐藏其真实能力和目的——这也被称为AI欺骗或谋划行为(AI deception or scheming)。

前沿模型越来越多地被训练和部署为自主智能体。一个安全担忧是,AI智能体可能会隐秘地追求与人类目标不一致的目标,隐藏其真实能力和目的——这也被称为AI欺骗或谋划行为(AI deception or scheming)。

我就说这个世界有点颠。 你看嗷,自打大模型爆火以来,不对,甚至在大模型爆火之前,人工智能客服就“入侵”了我们的生活。

持续适应性学习,即指适应环境并提升表现的能力,是自然智能与人工智能共有的关键特征。大脑达成这一目标的核心机制在于神经递质调控(例如多巴胺DA、乙酰胆碱ACh、肾上腺素)通过设置大脑全局变量来有效防止灾难性遗忘,这一机制有望增强人工神经网络在持续学习场景中的鲁棒性。本文将概述该领域的进展,进而详述两项6月Nature发表的背靠背相关研究。

在万物互联的智能时代,具身智能和空间智能需要的不仅是视觉和语言,还需要突破传统感官限制的能力

在正式走近ChatGPT Agent之前,让我们介绍一下这次谈话的几位主角,他们分别是OpenAI团队核心成员Isa Fulford、Casey Chu和孙之清。我们团队分别开发了Operator和Deep Research,在分析用户请求时发现,Deep Research的用户非常希望模型能够访问需要付费订阅的内容或有门槛的资源,而Operator恰好具备这种能力。

7月23日,夸克健康大模型成功通过中国12门核心学科的主任医师笔试评测,成为国内首个完成这一挑战的大模型。离上次通过12门副主任医师职称考试仅仅隔了两个月。

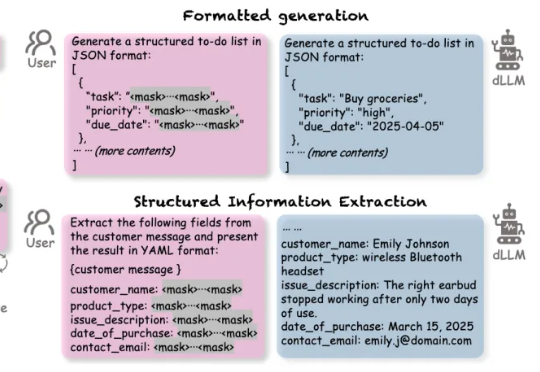

扩散语言模型(Diffusion-based LLMs,简称 dLLMs)以其并行解码、双向上下文建模、灵活插入masked token进行解码的特性,成为一个重要的发展方向。

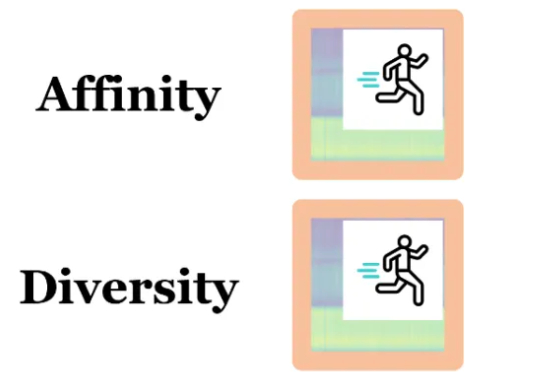

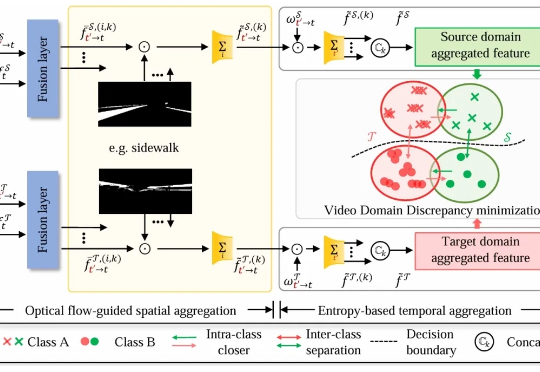

东北大学、武汉大学等的研究人员首次提出统一处理图像与视频的无监督领域自适应语义分割框架,通过四向混合机制(QuadMix)和光流引导的时空聚合模块,有效缩小跨域差异,显著提升模型性能,刷新多项基准记录。该方法不仅解决了图像与视频任务割裂的问题,还为未来多模态感知系统奠定了基础。

自 ChatGPT 引爆公众认知以来,AI 开始渗透进写作、编程、设计等多个应用场景,推动人类进入“智能体(Agent)”时代。曾经遥不可及的自动化交互,如今正在成为现实。在这背后,一场关于基础设施的重构也悄然展开——从模型能力到部署体验,谁能打通智能 Agent 的“最后一公里”,谁就掌握了这场范式变革的主动权。

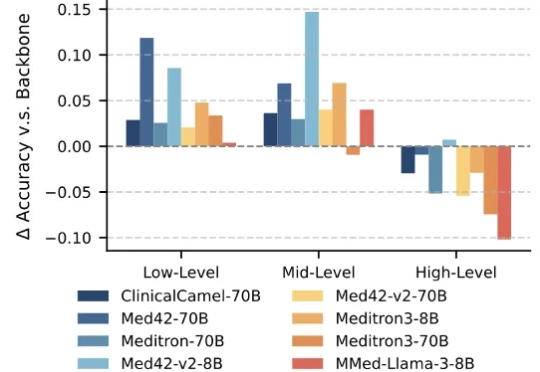

大语言模型(Large Language Models,LLMs)技术的迅猛发展,正在深刻重塑医疗行业。医疗领域正成为这一前沿技术的 “新战场” 之一。大模型具备强大的文本理解与生成能力,能够快速读取医学文献、解读病历记录,甚至基于患者表述生成初步诊断建议,有效辅助医生提升诊断的准确性与效率。