结构化预处理让DeepSeek准确率提升51%,现已开源丨清华&深言

结构化预处理让DeepSeek准确率提升51%,现已开源丨清华&深言零成本降低大模型幻觉新方法,让DeepSeek准确率提升51%!

零成本降低大模型幻觉新方法,让DeepSeek准确率提升51%!

香港中文大学提出了一个全新的算法框架RankSEG,用于提升语义分割任务的性能。传统方法在预测阶段使用threshold或argmax生成掩码,但这种方法并非最优。RankSEG无需重新训练模型,仅需在推理阶段增加三行代码,即可显著提高Dice或IoU等分割指标。

最新报告探讨了生成式模型Nano Banana Pro在低层视觉任务中的表现,如去雾、超分等,传统上依赖PSNR/SSIM等像素级指标。研究发现,Nano Banana Pro在视觉效果上更佳,但传统指标表现欠佳,因生成式模型更追求语义合理而非像素对齐。

你是否经历过这样的至暗时刻: 明明实验数据已经跑通,核心逻辑也已梳理完毕,却在面对空白的 PPT 页面时陷入停滞; 明明脑海里有清晰的系统架构,却要在 Visio 或 Illustrator 里跟一根歪歪扭扭的线条较劲半小时; 好不容易用 AI 生成了一张精美的流程图,却发现上面的文字是乱码,或者为了改一个配色不得不重新生成几十次……

月前,Pollo.ai 拿下千万美元融资,而今日, ListenHub 也拿下了 200 万美元融资。两个产品都没有做自研模型,创始人也都不是典型的技术或者大厂出身,都是非典型的 AI 应用层创业,这个在 2024年“质疑”声很大的模式,在 2025 年却结出了不少的果实。

让静态3D模型「动起来」一直是图形学界的难题:物理模拟太慢,生成模型又不讲「物理基本法」。近日,北京大学团队提出DragMesh,通过「语义-几何解耦」范式与双四元数VAE,成功将核心生成模块的算力消耗降低至SOTA模型的1/10,同时将运动轴预测误差降低了10倍。

LLM的下一个推理单位,何必是Token?刚刚,字节Seed团队发布最新研究——DLCM(Dynamic Large Concept Models)将大模型的推理单位从token(词) 动态且自适应地推到了concept(概念)层级。

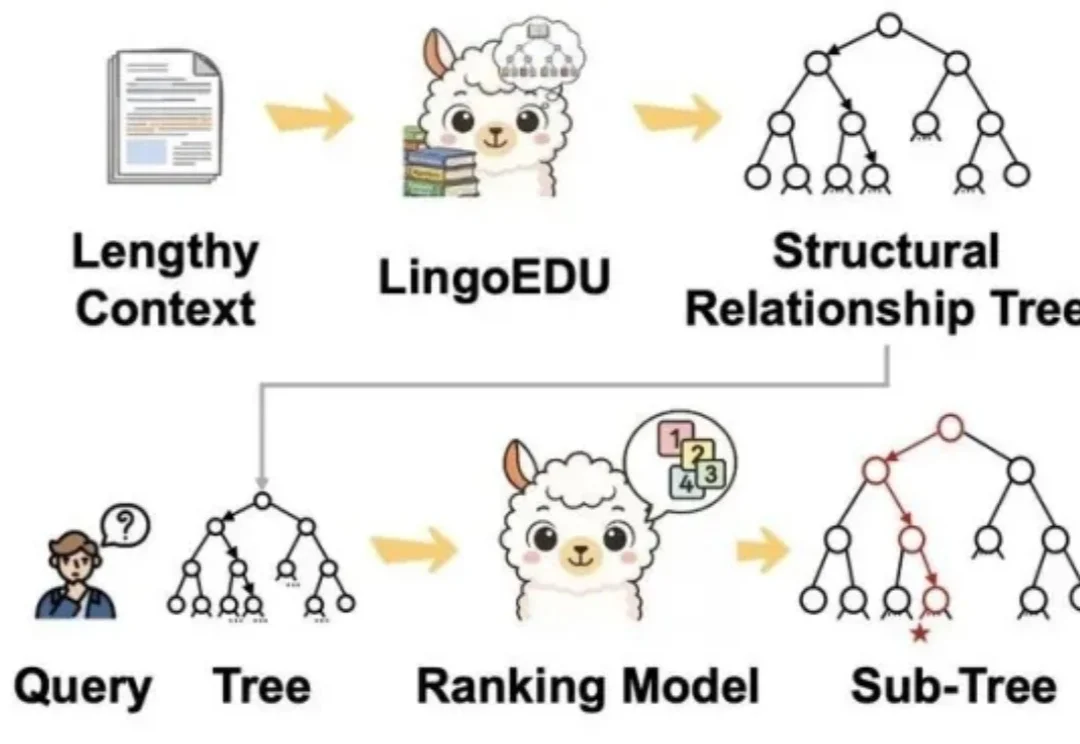

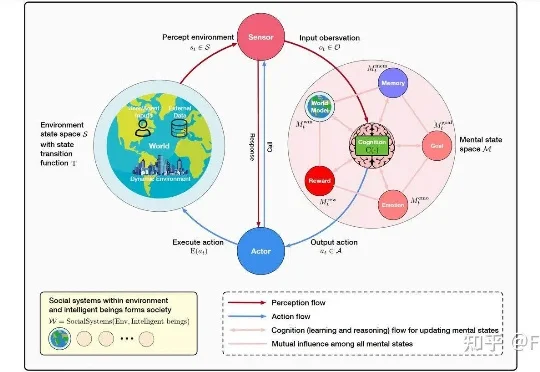

你有没有发现,你让AI读一篇长文章,结果它读着读着就忘了前面的内容? 你让它处理一份超长的文档,结果它给出来的答案,牛头不对马嘴? 这个现象,学术界有个专门的名词,叫做上下文腐化。 这也是目前AI的通病:大模型的记忆力太差了,文章越长,模型越傻!

1900亿美金的游戏帝国正迎来寒冬!《原神》式的重金堆砌已近极限,李飞飞携「世界模型」暴力拆解行业规则。从4倍速开发到Genie 3瞬间造梦,AI正在终结搬砖时代。这场关于造物权的豪赌,你准备好成为上帝了吗?

你有没有想过,如果你和 AI 聊天,无意中把自己的生日、住址或照片告诉了它,这些信息会不会被它记住?以及我们是否可以像删除微信聊天记录一样,让 AI 忘记这些隐私?