AI自己给自己当网管,实现安全“顿悟时刻”,风险率直降9.6%

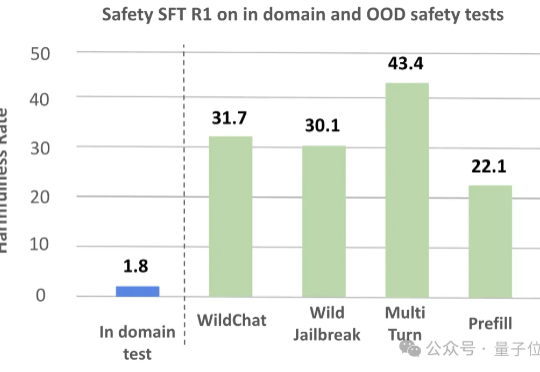

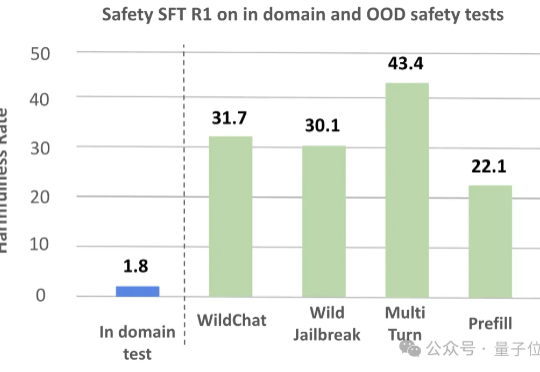

AI自己给自己当网管,实现安全“顿悟时刻”,风险率直降9.6%大型推理模型(LRMs)在解决复杂任务时展现出的强大能力令人惊叹,但其背后隐藏的安全风险不容忽视。

大型推理模型(LRMs)在解决复杂任务时展现出的强大能力令人惊叹,但其背后隐藏的安全风险不容忽视。

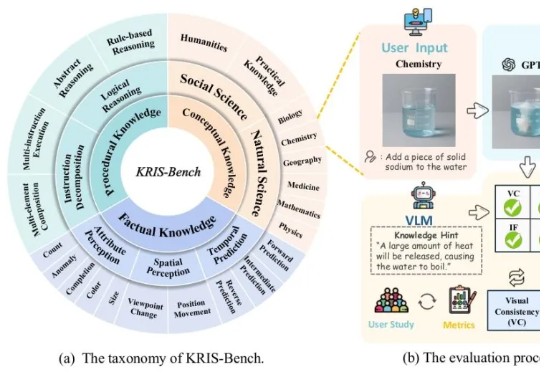

人类在学习新知识时,总是遵循从“记忆事实”到“理解概念”再到“掌握技能”的认知路径。

为了推动该领域加速健康发展,由上海交通大学、上海 AI 实验室、牛津大学、普林斯顿大学、Meta 等十个机构联合推出的 MASLab,带来首个统一、全面、研究友好的大模型多智能体系统代码库:

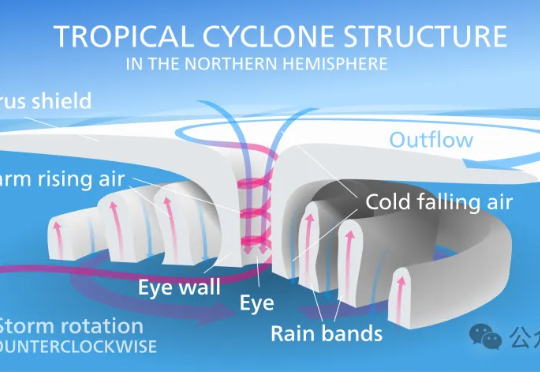

昨天,谷歌DeepMind与谷歌研究团队正式推出交互式气象平台Weather Lab,用于共享人工智能天气模型。在热带气旋路径预测方面,谷歌这次的新模型刷新SOTA,是首个在性能上明确超越主流物理模型的AI预测模型。

随着生成式人工智能技术的快速发展,大语言模型 (LLM) 正逐步成为推动智能设备升级的核心力量。乐鑫科技携手火山引擎扣子大模型团队,共同推出智能 AI 开发套件 —— EchoEar(喵伴)。该套件以端到端开发为核心理念,构建起从硬件接入、智能体构建到生态联动的一站式开发流程,为开发者提供了一条高效、开放、具备可复制性的落地路径。

对于 AI 相关专业毕业生来说,就业市场选择很多,各个大厂、小厂、初创都在积极招揽 AI 人才。同学们在择业时,会不会也有疑虑?或许我们可以从行业走势、公司基因、过往人才培养案例等方面跟同学们一起探讨一下。

4月份,李飞飞教授领先编制的《2025年人工智能指数报告》提供的数据显示,2024年全年具有特殊影响力的模型(Notable AI models)当中,排名前5的几乎都来自美国、中国的科技巨头。

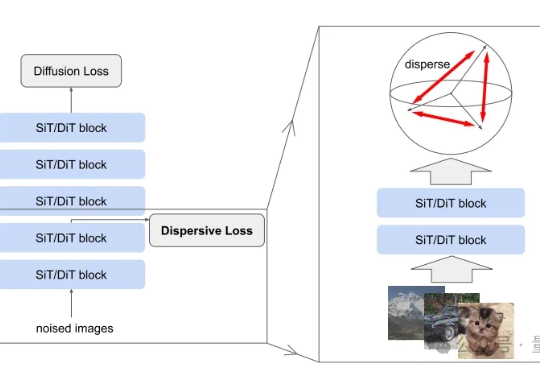

扩散模型风头正盛,何恺明最新论文也与此相关。 研究的是如何把扩散模型和表征学习联系起来—— 给扩散模型加上“整理收纳”功能,使其内部特征更加有序,从而生成效果更加自然逼真的图片。

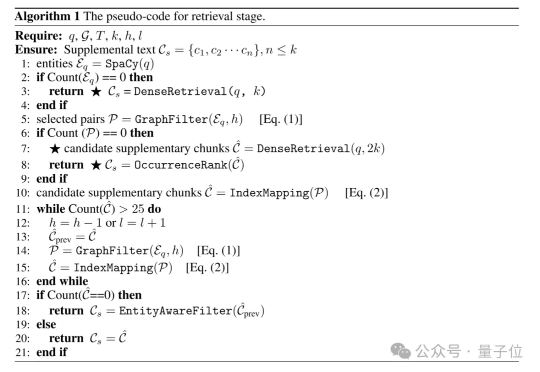

GraphRAG的索引速度慢,LightRAG的查询延迟高?

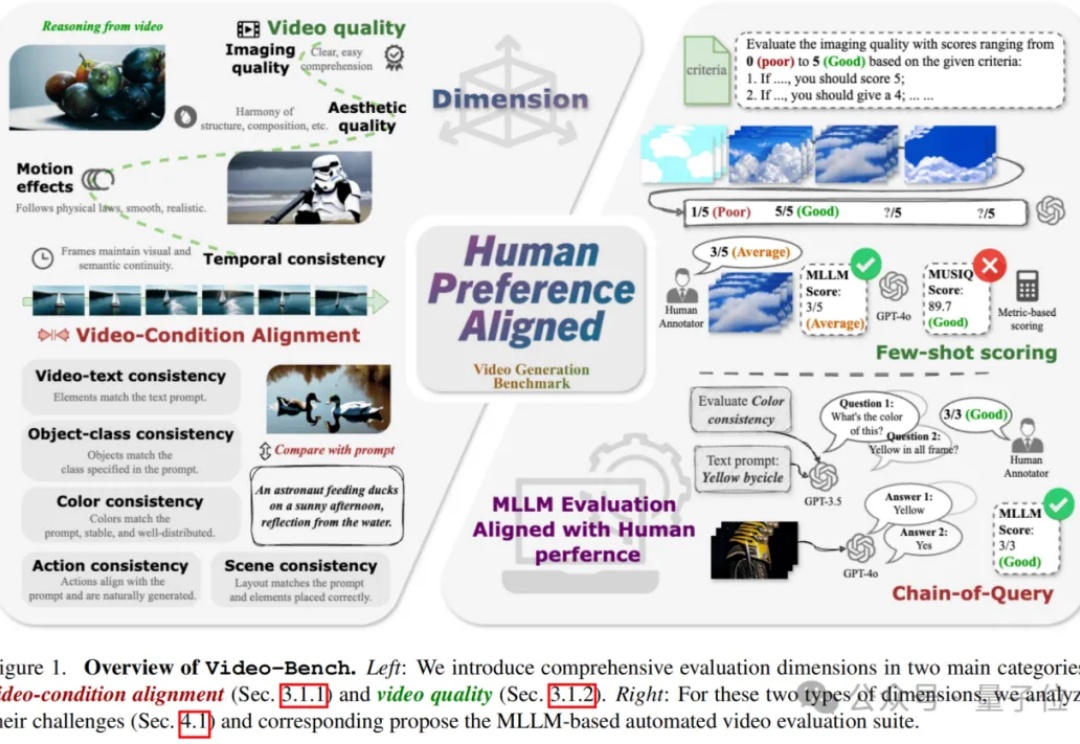

视频生成技术正以前所未有的速度革新着当前的视觉内容创作方式,从电影制作到广告设计,从虚拟现实到社交媒体,高质量且符合人类期望的视频生成模型正变得越来越重要。