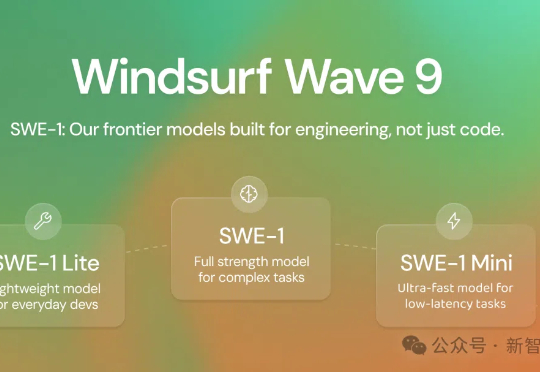

OpenAI很看好!首个SWE-1模型发布,软件开发或将提速99%

OpenAI很看好!首个SWE-1模型发布,软件开发或将提速99%Windsurf发布首个前沿模型SWE-1,AI编程领域风起云涌,目标是将开发效率提升99%。SWE-1不仅能写代码,更能理解并协助整个软件工程流程。核心创新在于「流动感知」系统,即AI与用户共享操作时间线,实现高效协作。

Windsurf发布首个前沿模型SWE-1,AI编程领域风起云涌,目标是将开发效率提升99%。SWE-1不仅能写代码,更能理解并协助整个软件工程流程。核心创新在于「流动感知」系统,即AI与用户共享操作时间线,实现高效协作。

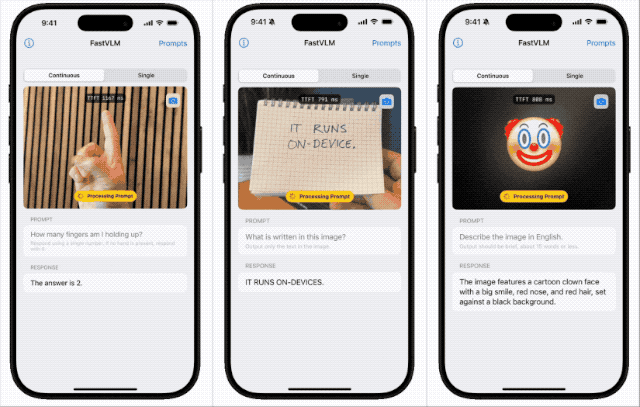

苹果近期开源本地端侧视觉语言模型FastVLM,支持iPhone等设备本地运行,具备快速响应、低延迟和多设备适配特性。该模型依托自研框架MLX和视觉架构FastViT-HD,通过算法优化实现高效推理,或为未来智能眼镜等新硬件铺路,体现苹果将AI深度嵌入系统底层的战略布局。

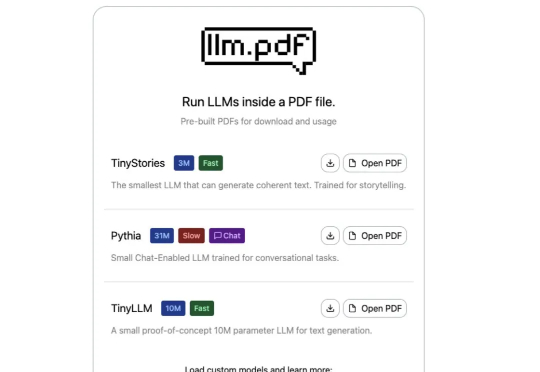

你以为PDF只是用来阅读文档的?这次它彻底颠覆了你的想象!极客Aiden Bai最新整活——直接把大语言模型(LLM)塞进PDF里,打开文件就能让AI讲故事、陪你聊天!更夸张的是,连Linux系统都能在PDF里运行。

近日,腾讯 PCG 社交线的研究团队针对这一问题,采用强化学习(RL)训练方法,通过分组相对策略优化(Group Relative Policy Optimization, GRPO)算法,结合基于奖励的课程采样策略(Reward-based Curriculum Sampling, RCS),将其创新性地应用在意图识别任务上,

最近,Google 推出了一个可以精准控制画面中光影的项目 —— LightLab。 它让用户能够从单张图像实现对光源的细粒度参数化控制, 可以改变可见光源的强度和颜色、环境光的强度,并且能够将虚拟光源插入场景中。

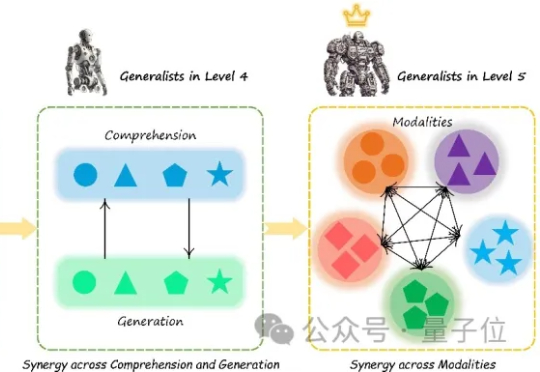

多模态大模型(Multimodal Large Language Models, MLLM)正迅速崛起,从只能理解单一模态,到如今可以同时理解和生成图像、文本、音频甚至视频等多种模态。正因如此,在AI竞赛进入“下半场”之际(由最近的OpenAI研究员姚顺雨所引发的共识观点),设计科学的评估机制俨然成为决定胜负的核心关键。

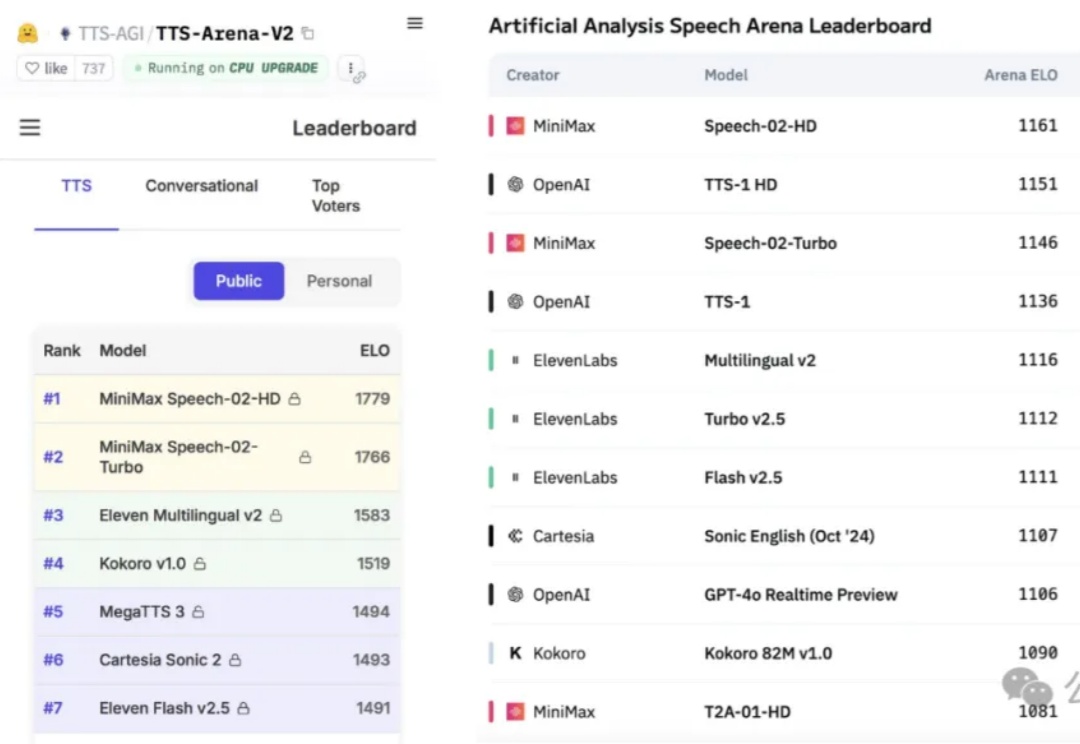

超越OpenAI! 国产大模型突袭,AI语音生成天花板被重新定义了。

梁文锋亲自参与的DeepSeek最新论文,来了!

打破科技巨头算力垄断,个人开发者联手也能训练超大规模AI模型?

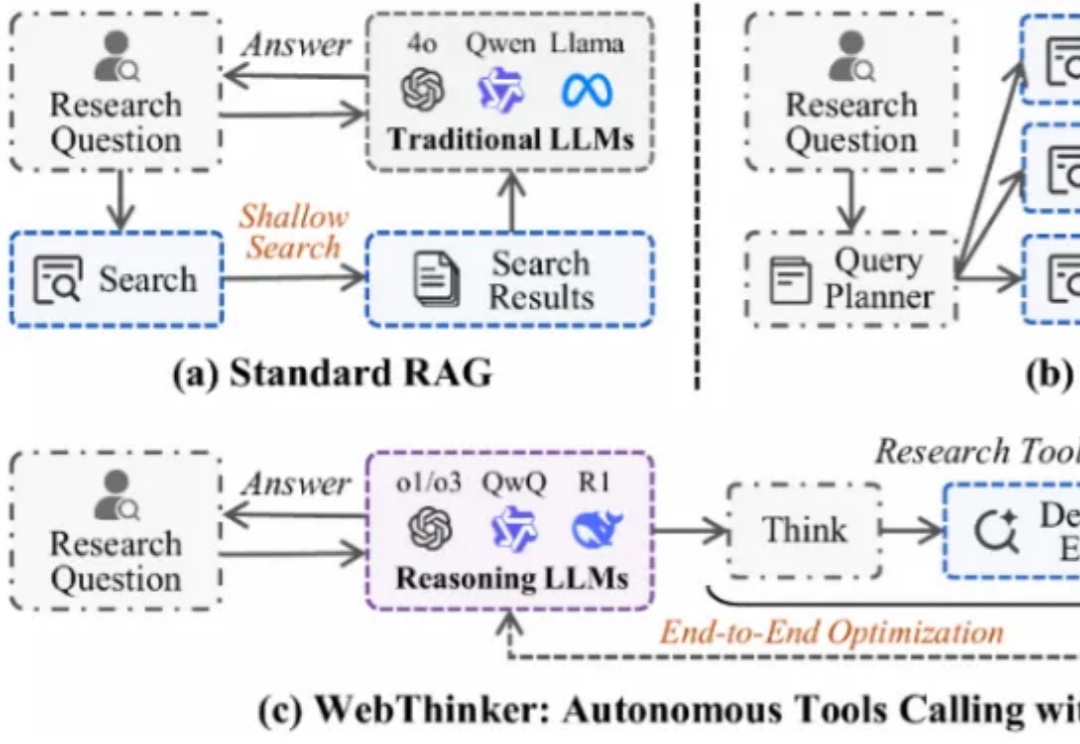

大型推理模型(如 OpenAI-o1、DeepSeek-R1)展现了强大的推理能力,但其静态知识限制了在复杂知识密集型任务及全面报告生成中的表现。为应对此挑战,深度研究智能体 WebThinker 赋予 LRM 在推理中自主搜索网络、导航网页及撰写报告的能力。