别听模型厂商的,Prompt 不是功能,是 bug

别听模型厂商的,Prompt 不是功能,是 bug除了是知名 AI 播客「No Priors」的主理人之外,Sarah Guo 更知名的身份,是风险投资 Conviction 的创始人。

除了是知名 AI 播客「No Priors」的主理人之外,Sarah Guo 更知名的身份,是风险投资 Conviction 的创始人。

OpenAI前研究员、Meta「AI梦之队员」毕书超在哥大指出:AGI就在眼前,突破需高质数据、好奇驱动探索与高效算法;Scaling Law依旧有效,规模决定智能,终身学习才是重点。

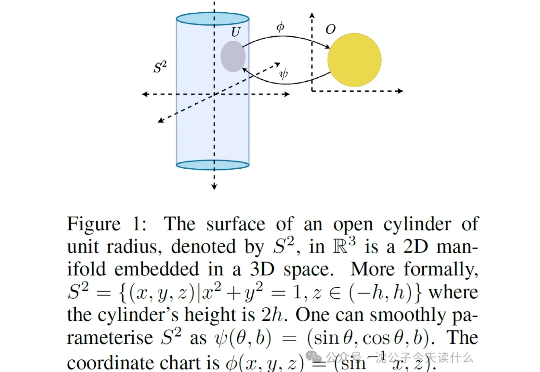

一句话概括,原来强化学习的“捷径”是天生的,智能体能去的地方(流形)被动作维度(低维流形)限制得死死的,根本没机会去那些没用的高维空间瞎逛。

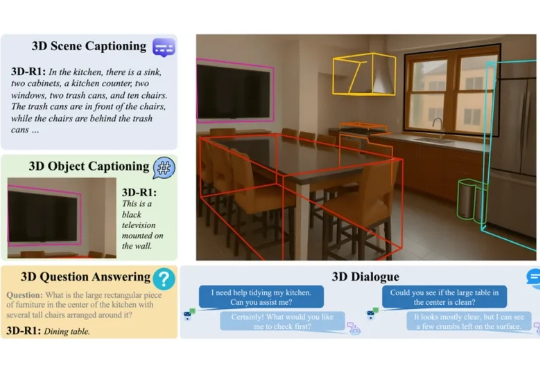

在人工智能快速发展的今天,我们已逐渐习惯于让 AI 识别图像、理解语言,甚至与之对话。但当我们进入真实三维世界,如何让 AI 具备「看懂场景」、「理解空间」和「推理复杂任务」的能力?这正是 3D 视觉语言模型(3D VLM)所要解决的问题。

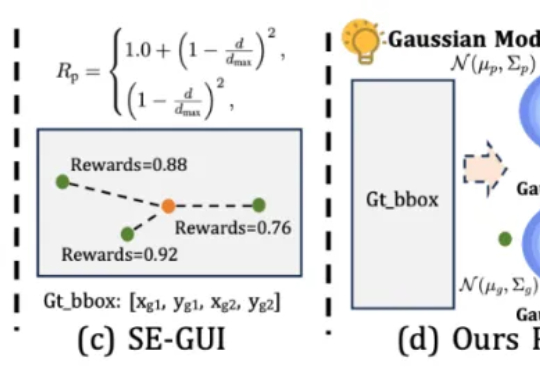

本文第一作者唐飞,浙江大学硕士生,研究方向是 GUI Agent、多模态推理等。

相信大家都有这样一个体验。 跟AI无论什么对话,感觉都是说空话套话。

提出一个真正好的猜想,比解决它更难。这是谷歌DeepMind首席执行官哈萨比斯(Demis Hassabis)在莱克斯(Lex Fridman)最新对谈中的感慨。他同时也是2024年诺贝尔化学奖的得主,带队开发出了能够高精度预测蛋白质的三维结构的AlphaFold系列模型。

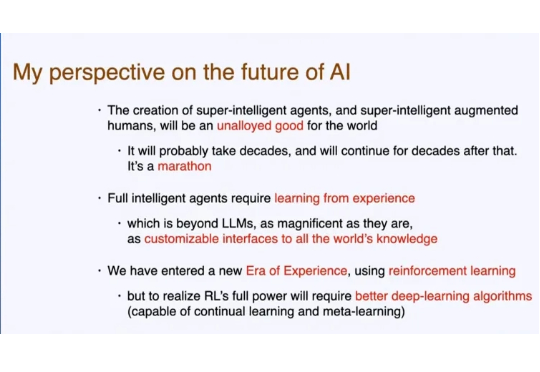

不知道大家是否还记得,人工智能先驱、强化学习之父、图灵奖获得者 Richard S. Sutton,在一个多月前的演讲。 Sutton 认为,LLM 现在学习人类数据的知识已经接近极限,依靠「模仿人类」很难再有创新。

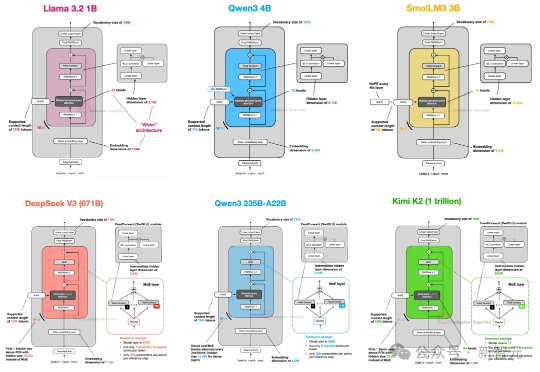

从GPT-2到DeepSeek-V3和Kimi K2,架构看似未变,却藏着哪些微妙升级?本文深入剖析2025年顶级开源模型的创新技术,揭示滑动窗口注意力、MoE和NoPE如何重塑效率与性能。

上下文工程(Context Engineering)现在有多火,就不用多说了吧。